一、简介 1. 简单介绍

MongoDB是一个基于分布式文件存储 的数据库

由C++语言编写,旨在为WEB应用提供可扩展的高性能数据存储解决方案。

MongoDB是一个介于关系数据库 和非关系数据库 之间的产品,是非关系数据库当中功能最丰富,最像关系数据库的。

它支持的数据结构非常松散,是类似json的bson格式,因此可以存储比较复杂的数据类型。

Mongo最大的特点是它支持的查询语言 非常强大,其语法有点类似于面向对象的查询语言,几乎可以实现类似关系数据库单表查询的绝大部分功能,而且还支持对数据建立索引

2. 业务应用场景 传统的关系型数据库(如MySQL),在数据操作的三高需求以及应对Web2.0的网站需求面前,显得力不从心,而 MongoDB可应对“三高“需求

High performance:对数据库高并发读写的需求

Huge Storage:对海量数据的高效率存储和访问的需求

High Scalability && High Availability:对数据库的高可扩展性和高可用性的需求

具体应用场景 :

社交场景,使用 MongoDB存储存储用户信息,以及用户发表的朋友圈信息,通过地理位置索引实现附近的人、地点等功能。

游戏场景,使用 MongoDB存储游戏用户信息,用户的装备、积分等直接以内嵌文档的形式存储,方便查询、高效率存储和访问。

物流场景,使用 MongoDB存储订单信息,订单状态在运送过程中会不断更新,以 MongoDB内嵌数组的形式来存储,一次查询就能将订单所有的变更读取出来

物联网场景,使用 MongoDB存储所有接入的智能设备信息,以及设备汇报的日志信息,并对这些信息进行多维度的分析。

这些应用场景中,数据操作方面的共同特点 是:

(1)数据量大

(2)写入操作频繁(读写都很频繁)

(3)价值较低的数据,对事务性要求不高

对于这样的数据,我们更适合使用 MongoDB来实现数据的存储。

3. 什么时候选择MongoDB

MongoDB是一个开源、高性能、无模式(没有具体的列)的文档型数据库,当初的设计就是用于简化开发和方便扩展,是NoSQL数据库产品中的一种。是最像关系型数据库(MySQL)的非关系型数据库。

它支持的数据结构非常松散,是一种类似于 JSON 的 格式叫BSON,所以它既可以存储比较复杂的数据类型,又相当的灵活。

1 2 3 4 5 6 7 8 9 10 11 12 13 # 对文档数据库进行操作的基本方式包括了读、写、改、删四种。 # 1 、写Insert 命令 DB.Books.Insert(“Book_ID”:”100002 ”,”Name”:”《C语言》”,”Price”:”60 ”) # 2 、选Select 命令 DB.Books.find(“Name”:”《C语言》”) # 3 、改Update 命令 DB.Books.Update({“Book_ID”:”100002 ”},{$set {“Price”:78 }}) # 4 、删Remove命令 DB.Books.Remove({“Book_ID”:”100004 ”}) 。

相对MySQL,在以上以用场景可以以更低的成本解决问题(包括学习、开发、运维等成本)

4. 体系机构

在MongoDB中,数据库存储着集合和文档。一个数据库可以创建多个集合,原则上我们通常将逻辑相近的集合都放在一个数据库中,不过出于性能和数据量的考虑,也可分开存储。MongoDB默认提供admin、local、config以及test数据库四个数据库,具体介绍如下:

admin数据库 ,主要存储数据库账号的相关信息。local数据库 ,可以用于存储限于本地单台服务器的任意集合,如oplog日志就存储在local数据库中,该数据库的数据不会被复制到从节点上。config数据库 ,用于存储分片集群中与分片相关的元数据信息。test数据库 ,是MongoDB默认创建的一个测试库,当连接mongod服务时,如果不指定连接的具体数据库,默认就会连接到test数据库。

集合 就是MongoDB的一组文档,分为一般集合和上限集合。一般集合 我们通常称之为集合,集合是无模式或动态模式 的,也就意味着集合没有固定的格式。在读写数据前,不需要创建集合模式就可使用,因此集合中的文档可以拥有不同的字段,也可以任意增减某个文档的字段。

需要注意的是,通常插入集合的数据都具有一定的关联性。

上限集合 (Capped collections)与一般集合的主要区别在于其可以限制集合的容量大小 ,在数据存满时,可以从头开始覆盖最开始的文档,从而进行**循环写入 **。

文档 是以 键值对的形式 存储在集合中,其中,键用于唯一标识一个文档,为字符串类型,而值则可以是各种复杂的文件类型,我们称这种存储形式为BSON (BSON是类JSON的一种二进制形式的存储格式,简称BinaryJSON,它和JSON一样,支持内嵌的文档对象和数组对象 ,但是BSON有JSON没有的一些数据类型,如Date和BinData类型)。

文档中不能有重复的键,每个文档都有一个默认的_id键 ,它相当于关系型数据库中的主键,这个键的值在同一个集合中必须是唯一的,_id键值默认是ObjectId类型,在插入文档的时候,如果用户不设置文档的_id值,MongoDB会自动生成一个唯一的ObjectId值 进行填充。

MongoDB的最小存储单位就是文档(document)对象 。文档(document)对象对应于关系型数据库的行。数据在MongoDB中以BSON(Binary-JSON)文档的格式存储在磁盘上。

BSON (Binary Serialized Document Format)是一种类json的一种二进制形式的存储格式 ,简称Binary JSON。BSON和JSON一样,支持内嵌的文档对象和数组对象,但是BSON有JSON没有的一些数据类型,如Date和BinData类型。

BSON采用了类似于 C 语言结构体的名称、对表示方法,支持内嵌的文档对象和数组对象,具有轻量性、可遍历性、高效性的三个特点,可以有效描述非结构化数据和结构化数据。这种格式的优点是灵活性高,但它的缺点是空间利用率不是很理想。

Bson中,除了基本的JSON类型:string,integer,boolean,double,null,array和object ,mongo还使用了特殊的数据类型。这些类型包括date,object id,binary data,regular expression 和code 。每一个驱动都以特定语言的方式实现了这些类型,查看你的驱动的文档来获取详细信息。BSON数据类型参考列表:

文档的键是字符串类型,而值除字符串类型外,还可以为内嵌文档、数组、Date等类型,文档内容具体如下

1 2 3 4 5 6 7 8 9 10 11 12 {_id: ObjectId("5099803df3f4948bd2f98391"), name: { first : "Alan", last : "Turing" }, birth: new Date ('Jun 23, 1912' ), death: new Date ('Jun 07, 1954' ), contribs: [ "Turing machine", "Turing test", "Turingery" ], views : NumberLong(1250000 )} _id:该字段的值为ObjectId类型。 name:该字段的值是由first 、last 字段组成的内嵌文档。 birth和death:这两个字段对应的值均为Date 类型。 contribs:该字段的值为字符串数组类型。 views:该字段的值为NumberLong类型。

数字类型 MongoDB支持三种数字类型(即32位整数(Int32 )、64位整数(Int64 )和64位浮点数(Double ))。 使用mongo shell命令行交互界面和JavaScript命令这两种方式查看和操作MongoDB时,数值被默认转为64位浮点数。可通过Java等语言可存储包含整数(32位和64位整型)的文档。 如果想要通过mongo shell插入/更新文档内的整数(32位/64位)类型数值,则可以通过函数NumberInt(“Number”)和NumberLong(“Number”)进行操作。

1 2 3 4 5 6 7 # 在mongo shell查看文档中的64 位整数时,会通过封装函数NumberLong()显示。 { "_id":Objectld("5e042c88b2275b76df53b302"), "age32":32 , "age64":NumberLong(64 ) }

日期类型 在mongo shell中创建包含日期类型数值的文档 ,类似于在javascript中创建日期的方式,需要使用**new Date(…)**的方式。MongoDB会将存储的日期自动保存成ISODate日期类型。默认情况下MongoDB中存储的是标准的时间(GMT),中国时间是东八区(GMT+8),若是我们将当前时间存储至MongoDB中会发现减少8个小时。不过有些编程语言已对此进行相关处理,比如Java读取时会自动加上时区8小时。

1 2 3 4 5 6 7 # 在mongo shell插入Date 类型文档的操作。 > db.bigdata.insert({"time":new Date ("2019-02-12 12:12:12")}) > db.bigdata.find() { "_id":Objectld("5de915201bc9accea9a23154"), "time":ISODate("2019-02-12T04:12:12Z") }

数组类型 MongoDB数组是一系列元素的集合 ,使用中括号“[ ]”表示数组 。数组元素允许重复且位置固定,数组中可以存在不同数据类型的元素。在关系数据库中,数组的这种设计实现方式是不常见的。

1 2 3 4 5 6 7 8 9 10 11 # 数组类型文档的结构。 { "_id":Objectld("5de91c6f1bc9accea9a2315b"), "hobby":[ "swim", "run", "sing", 4.0 , "sing" ] }

ObjectId类型 ObjectId 是一个12字节BSON类型 ,由一组十六进制的24位字符串构成,每个字节存储2位十六进制字符,总共使用了12字节的存储空间,具有格式如下所示。

Time:ObjectId的前4个字节表示时间戳,即前8位字符“5de91c6f” ,通过十六进制转换成十进制内容为“1575558255”,这个数字就是一个时间戳格式,通过时间戳的转换,可变为常见的时间格式。

Machine:在Time后的3个字节表示所在主机的唯一标识符,即Time之后的6位字符“1bc9ac” ,一般是机器主机名的散列值,这样就确保了不同主机生成不同的机器hash值,这样可以防止在分布式中出现ObjectId相同的冲突情况,这也就是**在同一台机器生成的ObjectId中间字符串都是一模一样的原因 **。

PID:在Machine后的2个字节表示进程标识符,即Machine后的4位字符“cea9” ,可以**确保在同一台机器不同的MongoDB进程不会出现相同的ObjectId **。

INC:在PID后的3个字节是一个随机值 ,即PID之后的4位字符“a2315b”。前面介绍的9个字节是为了保证1秒内不同机器 不同进程 生成的ObjectId不冲突,这3个字节生成的随机值是为了确保1秒内产生的ObjectId不发生冲突

内嵌文档 MongoDB一大优势在于能够在一条文档中存储对象类型的数据 ,并适当增加冗余让数据库更便于使用。文档中一个对象类型的字段在MongoDB中被称为内嵌文档 (Embedded),也是MongoDB推荐的存储格式。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 # 内嵌文档类型的文档格式(6 -9 行) { "_id" : ObjectId("5de92bda1bc9accea9a2315e"), "name" : "mongo", "price" : 50.0 , "size" : { "h" : 8.5 , "w" : 11.0 }, "reading" : [ "John", "Dave" ] }

Code类型 在MongoDB数据库的文档中,可以存储一些JavaScript方法,这些方法可以重复使用\

1 2 3 4 5 # Code类型的文档格式如下。 { "_id" : ObjectId("5de92fdd1bc9accea9a23161"), "jscode" : function jsCode(a){ b= a+ 2 ;return b;} }

5. 数据类型 BSON数据类型参考列表:

提示 :shell默认使用64位浮点型数值。 {“x”:3.14或{“x”:3}。对于整型值,可以使用NumberInt(4字节符号整数)或 NumberLong(8字节符号整数),{“x”:NumberInt(“3” ){“x”:NumberLong(“3”)}

6. 特点

高性能

对嵌入式数据模型的支持减少了数据库系统上I/O活动。

索引支持更快的查询,并且可以包含来自嵌入式文档和数组的键。(文本索引解决搜索的需求、TTL索引解决历史数据自动过期的需求、地理位置索引可用于构建各种O2O应用)

mmapv1、 wiredtiger、 mongorocks( rocks)、 In-memory等多引擎支持满足各种场景需求

Gridfs解决文件存储的需求

高可用性

高扩展性

分片将数据分布在一组集群的机器上。(海量数据存储,服务能力水平扩展)

从3.4开始,MoηgoDB支持基于片键创建数据区域。在一个平衡的集群中, MongoDB将一个区域所覆盖的读写只定向到该区域内的那些片。

丰富的查询支持

其他特点

如无模式(动态模式)、灵活的文档模型

二、Windows安装&启动&连接 1. 下载压缩包 下载地址:https://www.mongodb.com/try/download/community

这里以zip的格式进行下载

附加:mongodb的命名格式: x.y.z

1 2 3 - y为奇数表示当前版本为开发版,如:1.5.2、4.1.13 - y为偶数表示当前版本为稳定版,如:1.6.3、4.0.10 - z为修正版本号,越大越好

2. 解压 下载完成后得到压缩包,解压;其中的bin目录就存放着mongodb相关的命令

3. 安装服务 首先要在安装目录里创建两个目录:

数据目录:data

日志目录:logs

然后以管理员模式,切换到安装目录下的bin目录运行以下格式命令来指定mongdb的数据及日志目录

1 mongod --install --dbpath 数据目录 --logpath 日志目录\日志名称

注意整个文件的路径中不能包含中文,中文,中文!踩过坑!

具体的代码为如下所示:

1 mongod --install --dbpath D:\JAVA_Environment\MongoDB\mongodb-win32-x86_64-windows-4.4.2\data --logpath D:\JAVA_Environment\MongoDB\mongodb-win32-x86_64-windows-4.4.2\logs\mongodb.log

没有任何报错和提示,则代表MongoDB服务创建成功

我们可以进行验证,win+r输入services.msc

看到MongoDB服务即成功

补充一下:如果想要删除MongoDB服务的话

4. 启动服务 输入以下命令启动服务

http://localhost:27017/如果看到以下内容,代表启动成功

5. shell连接登录&退出 输入以下命令进行登录与退出

1 2 3 4 5 6 #登录 mongo mongo --host=localhost --port=27017 #退出 exit

相关语法 :

1 2 3 4 5 mongod --install --dbpath 数据目录 --logpath 日志目录\日志名称 #创建服务 mongod --remove #卸载服务 net start mongodb #启动服务 net stop mongodb #关闭服务 mongod #是处理MongoDB系统的主要进程。它处理数据请求,管理数据存储,和执行后台管理操作。当我们运行mongod命令意味着正在启动MongoDB进程,并且在后台运行。

6. Compass图形化连接登录 MongoDB的GUI。直观地浏览您的数据。在几秒钟内运行查询。借助完整的CRUD功能与您的数据进行交互。查看和优化您的查询性能。在Linux,Mac或Windows上可用。Compass使您能够做出更明智的索引,文档验证等决策。

下载地址:https://www.mongodb.com/try/download/compass

点击Download下载即可,下载完成后得到压缩包

解压,可以看到MongoDBCompass.exe

双击运行,直接Next,最后Get Stated,默认选项即可

然后直接点击CONNECT就会连接本地的数据库localhost:27017

可以看到所有的数据库及相关信息

三、Linux安装&启动&连接 1 2 3 4 5 6 7 cd /opt mkdir module cd module mkdir mongodb cd mongodb rm -rf /path/to/directory 强制删除文件

传输、解压、移动安装包

(1). 打开Linux虚拟机并通过传输工具WinSCP 连接Linux平台,并存储在CentOS中的 /opt/ 路径下。

1 wget https://fastdl.mongodb.org/linux/mongodb-linux-x86_64-rhel80-4.4.24.tgz

(2). 在Xshell中执行tar -zxvf mongodb-linux-x86_64-rhel80-4.4.24.tgz命令,解压tgz包。

(3). 执行mv mongodb-linux-x86_64-rhel80-4.4.24/* /opt/module/mongodb,移动解压后的文件夹到/opt/module/mongodb

新建并修改配置文件

(1). 新建几个目录,分别用来存储数据和日志。

1 2 3 4 5 6 7 8 9 [root@localhost mongodb]# mkdir -p shihanshuo/data/db [root@localhost mongodb]# mkdir -p shihanshuo/logs [root@localhost mongodb]# touch shihanshuo/logs/mongologs.log

(2). 新建并修改配置文件 vi shihanshuo/mongod.conf

配置文件的内容如下:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 systemLog: destination: file path: "/opt/module/mongodb/shihanshuo/logs/mongologs.log" logAppend: true storage: dbPath: "/opt/module/mongodb/shihanshuo/data/db" journal: enabled: true processManagement: fork: true net: bindIp: localhost,192.168.24.105 port: 27017

复制后,按键盘 Esc 键,退出编辑模式,然后键盘组合键 Shift + :键,输入wq写保存。

wq:写保存

q:退出

wq!:强制写保存

q!:强制退出

设置环境变量,使用mongo命令启动服务

(1). 由于Mongodb的相关服务均放在解压后/mongodb/bin路径下,若想启动服务,必须在bin目录下启动。因此为了避免启动之前需要进入到该路径,我们配置用户的环境变量即可

(2). 执行vi /etc/profile命令,编辑用户环境变量文件。找到export字段在其下方添加代码。

1 2 export MONGODB_HOME=/opt/module/mongodbexport PATH=$PATH :$MONGODB_HOME /bin

(3). 添加并wq写保存

(4). 执行source /etc/profile命令,初始化用户环境变量。

在任意路径下,即可执行mongod -f /opt/module/mongodb/shihanshuo/mongod.conf启动服务mongo连接到服务器

1 2 3 4 5 6 7 [root@localhost mongodb]# vi /etc/profile [root@localhost mongodb]# source /etc/profile [root@localhost mongodb]# cd [root@localhost ~]# mongod -f /opt/module/mongodb/shihanshuo/mongod.conf about to fork child process, waiting until server is ready for connections. forked process: 8075 child process started successfully, parent exiting

启动和关闭MongoDB服务

(1). 执行ps -ef|grep mongod查看服务进程。

(2). 确保mongodb服务启动后,使用客户端连接远程数据库服务器在终端执行 mongo --host=192.168.24.105然后执行show dbs查看当前数据库。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 [root@localhost ~]# mongo --host=192.168.24.105 MongoDB shell version v4.2.18 connecting to: mongodb://192.168.24.105:27017/?compressors=disabled&gssapiServiceName=mongodb Implicit session: session { "id" : UUID("43fc9a44-2f87-443c-9b57-eb55d50aace3" ) } MongoDB server version: 4.2.18 Welcome to the MongoDB shell. For interactive help , type "help" . For more comprehensive documentation, see https://docs.mongodb.com/ Questions? Try the MongoDB Developer Community Forums https://community.mongodb.com > show dbs admin 0.000GB config 0.000GB local 0.000GB>

(3). 执行exit退出mongo shell,执行kill -2 8075结束mongodb服务的进程。

1 2 3 4 5 6 7 8 9 10 11 12 13 > show dbs admin 0.000GB config 0.000GB local 0.000GB> exit bye [root@Server01 ~]# ps -ef|grep mongod root 8607 1 0 23:26 ? 00:00:00 mongod -f /opt/module/mongodb/standalone/mongod.conf root 8664 3744 0 23:27 pts/0 00:00:00 grep --color=auto mongod [root@Server01 ~]# kill -2 8607 [root@Server01 ~]# ps -ef|grep mongod root 8674 3744 0 23:27 pts/0 00:00:00 grep --color=auto mongod [root@Server01 ~]#

启动报错的解决:

报错一:ERROR: child process failed, exited with error number 48

解决方案:通过mongod –repair检查具体错误。

原来是端口冲突。删除前面没执行成功的文件,然后修改XXX.conf配置文件。将其中端口号改为27016后。重新执行后成功。

如果启动后没有关闭,再起启动也会报错48.则可以先使用关闭命令关闭,然后再次启动。

报错二:-bash: /usr/local/mongodb6/bin/mongod: Permission denied

启动的时候报错了,是因为没权限访问该文件

解决方案:给mongodb文件夹分配最高权限

sudo chmod -R 777 /usr/local/mongodb

-R 是指级联应用到目录里的所有子目录和文件

centOS启动mongoDB错误:./mongod: error while loading shared libraries: libcrypto.so.10: cannot open share

[root]# rpm -qa | grep libcrypto.so

我们发现启动失败,出现这种情况我们编辑用户级配置文件 vim ~/.bashrc

添加配置信息: export PATH=/usr/local/mongodb/bin:$PATH (中间那部分就是你的安装目录下的bin)

wq保存退出

然后刷新:source ~/.bashrc

再次启动

6. Compass图形化连接登录 利用Compass进行连接,Hostname为服务器的公网IP,其他默认

连接失败的原因:

未打开安全组策略

暴露给外部的端口需要打开对应的安全组设置

防火墙开放端口未设置

首先查看防火墙是否开启,结果为not running表示未开启,则不是防火墙的问题,跳过

查看防火墙是否开启 firewall-cmd –state

如果显示running,则继续排查,查看防火墙开放的端口

查看防火墙所开放的端口 1 2 3 4 firewall-cmd --list-ports [root@zsr ~]# firewall-cmd --list-ports 20/tcp 21/tcp 22/tcp 80/tcp 8888/tcp 39000-40000/tcp 3306/tcp 3306/udp 8080/tcp 8080/udp 3355/tcp

也可以用firewall-cmd –list-all查看防火墙的详细信息

我这里的问题就是防火墙未开放27017端口,所以要开放防火墙的对外暴露的端口

开放90端口(–premanent表示永久添加) 1 firewall-cmd --permanent --add-port=27017/tcp

重启防火墙(修改配置后要重启防火墙) 添加完成后再次查看就可以看到27017端口被开放

四、基本常用命令 1. 数据库相关 1 2 3 4 5 6 7 8 9 10 11 # 查看所有数据库 show databases # 选择数据库(如果数据库不存在,不会报错;会隐式创建:当后期该数据库有数据时自动创建) use 数据库名 # 查看当前正在使用的数据库命令: db # 删除数据库(先选中数据库) db.dropDatabase()

2. 集合相关 1 2 3 4 5 6 7 8 # 查看所有集合 show collections # 创建集合(插入数据会隐式创建) db.createCollection('集合名') # 删除集合 db.集合名.drop()

五、CURD 增:插入文档

集合存在则直接插入数据,不存在则隐式创建集合并插入数据

json数据格式要求key得加"",但这里为了方便查看,对象的key统一不加"";查看集合数据时系统会自动给key加""

mongodb会自动给每条数据创建全球唯一的_id键(我们也可以自定义_id的值,只要给插入的json数据增加_id键即可覆盖,但是不推荐这样做)

测试 :

插入一条数据

1 db.student.insert({name:"shs",age:20})

一次插入多条数据并指定_id

1 db.stuent.insert([{_id:1,namme:"z",age:20},{_id:2,namme:"x",age:21},{_id:3,namme:"c",age:23}])

批量插入多条文章评论:

1 2 3 4 5 db.comment.insertMany([ {"_id":"1","articleid":"100001","content":"我们不应该把清晨浪费在手机上,健康很重要,一杯温水幸福你我他。","userid":"1002","nickname":"相忘于江湖","createdatetime":new Date ("2019-08-05T22:08:15.522Z"),"likenum":NumberInt(1000 ),"state":"1"}, {"_id":"2","articleid":"100001","content":"我夏天空腹喝凉开水,冬天喝温开水","userid":"1005","nickname":"伊人憔悴","createdatetime":new Date ("2019-08-05T23:58:51.485Z"),"likenum":NumberInt(888 ),"state":"1"}, {"_id":"3","articleid":"100001","content":"我一直喝凉开水,冬天夏天都喝。","userid":"1004","nickname":"杰克船长","createdatetime":new Date ("2019-08-06T01:05:06.321Z"),"likenum":NumberInt(666 ),"state":"1"}, ]);

提示:

如果某条数据插入失败,将会终止插入,但已经插入成功的数据不会回滚掉。

因为批量插入由于数据较多容易出现失败,因此,可以使用try catch进行异常捕捉处理 ,测试的时候可以不处理。如(掌握):

1 2 3 4 5 6 7 8 9 try { db.comment.insertMany([ {"_id":"1","articleid":"100001","content":"我们不应该把清晨浪费在手机上,健康很重要,一杯温水幸福你我他。","userid":"1002","nickname":"相忘于江湖","createdatetime":new Date ("2019-08-05T22:08:15.522Z"),"likenum":NumberInt(1000 ),"state":"1"}, {"_id":"2","articleid":"100001","content":"我夏天空腹喝凉开水,冬天喝温开水","userid":"1005","nickname":"伊人憔悴","createdatetime":new Date ("2019-08-05T23:58:51.485Z"),"likenum":NumberInt(888 ),"state":"1"}, {"_id":"3","articleid":"100001","content":"我一直喝凉开水,冬天夏天都喝。","userid":"1004","nickname":"杰克船长","createdatetime":new Date ("2019-08-06T01:05:06.321Z"),"likenum":NumberInt(666 ),"state":"1"}, ]); } catch (e) { print (e); }

利用for循环插入数据

1 2 3 for(var i=1;i<10;i++){ db.student.insert({name:"a"+i,age:i}) }

删:删除文档 1 2 3 4 5 6 7 8 db.集合名.remove(条件 [,是否删除一条]) db.student.remove({},true) db.student.remove({},false) # 是否删除一条 - false删除多条,即全部删除(默认) - true删除一条

改:修改文档 1 2 3 4 5 6 7 8 9 10 11 db.集合名.update(条件, 新数据 [,是否新增, 是否修改多条]) # 新数据 - 默认是对原数据进行替换 - 若要进行修改,格式为 {修改器:{key:value}} # 是否新增 - 条件匹配不到数据时是否插入: true插入,false不插入(默认) # 是否修改多条 - 条件匹配成功的数据是否都修改: true都修改,false只修改一条(默认)

修改器 作用

$inc

递增

$rename

重命名列

$set

修改列值

$unset

删除列

准备工作 :插入十条数据

1 2 3 for(var i=1;i<=10;i++){ db.people.insert({name:"zsr"+i,age:i}) }

将{name:“zsr1”}更改为{name:“zsr2”}

1 db.people.update({name:"zsr1"},{name:"zsr2"})

发现问题 :默认不是修改而是替换

解决问题 :使用修改器将{name:“zsr3”}更改为{name:“zsr3333”}

1 db.people.update({name:"zsr3"},{$set:{name:"zsr3333"}})

给{name:“zsr10”}的年龄增加或减少2岁

1 2 3 4 5 # 增加两岁 db.people.update({name:"zsr10"},{$inc:{age:2}}) # 减少两岁 db.people.update({name:"zsr10"},{$inc:{age:-2}})

一次写多个修改器

首先插入一条数据

1 db.people.insert({username:"gcc",age:20,sex:"女",address:"unknown"})

任务:修改gcc的username为bareth,age+11,sex字段重命名为sexuality,删除address字段

1 2 3 4 5 6 db.people.update({username:"gcc"},{ $ set :{username:"bareth" }, $ inc:{age:11}, $ rename:{sex:"sexuality" }, $ unset :{address:true }})

查:查询文档 1 2 3 4 5 6 7 8 9 10 11 12 db.集合名.find(条件 [,查询的列]) db.集合名.find(条件 [,查询的列]).pretty() #格式化查看 # 条件 - 查询所有数据 {}或不写 - 查询指定要求数据 {key:value}或{key:{运算符:value}} # 查询的列(可选参数) - 不写则查询全部列 - {key:1} 只显示key列 - {key:0} 除了key列都显示 - 注意:_id列都会存在

运算符 作用

$gt

大于

$gte

大于等于

$lt

小于

$lte

小于等于

$ne

不等于

$in

in

$nin

not in

查询指定列的所有数据

1 2 3 db.student.find({},{name:1}) 只查询name列 db.student.find({},{name:0}) 查询除了name列以外的列

查询指定条件的数据

统计查询 使用count()方法

【示例】

(2)按条件统计记录数:

1 db.comment.count({userid:1003})

六、排序&分页&复杂查询 数据准备 :

1 2 3 for(var i=1;i<5;i++){ db.person.insert({_id:i,name:"p"+i,age:10+i}) }

排序 1 2 3 4 5 db.集合名.find().sort(json数据) # json数据(key:value) - key就是要排序的字段 - value为1表示升序,-1表示降序

1 db.people.find().sort({age:-1}) 按年龄降序排列

分页 1 2 3 4 5 6 7 8 9 10 db.集合名.find().sort().skip(数字).limit(数字)[.count()] # skip(数字) - 指定跳过的数量(可选) # limit (数字)- 限制查询的数量 # count() - 统计数量

测试:

实战 :数据库有1~10条数据,每页显示2条,一共5页

1 2 3 4 5 6 7 8 skip计算公式: (当前页-1)*每页显示的条数 页数 起始 终止 跳过数 1页 1 2 0 2页 3 4 2 3页 5 6 4 4页 7 8 6 5页 9 10 8

1 2 3 4 5 6 7 8 9 # 数据准备 for(var i=1;i<11;i++){ db.page.insert({_id:i,name:"p"+i}) } # 分5页,每页2条显示 for(var i=0;i<10;i=i+2){ db.page.find().skip(i).limit(2) }

复杂查询 文档的正则复杂条件查询 MongoDB的模糊查询是通过正则表达式的方式实现的。格式为:

db.collection.find({field:/正则表达式/})

或

db.集合.find({字段:/正则表达式/})

提示:正则表达式是js的语法,直接量的写法。

例如,我要查询评论内容包含“开水”的所有文档,代码如下:

1 db.comment.find({content:/ 开水/ })

如果要查询评论的内容中以“专家”开头的,代码如下:

1 db.comment.find({content:/ ^ 专家/ })

文档的比较查询 <, <=, >, >= 这个操作符也是很常用的 ,格式如下:

1 2 3 4 5 db.集合名称.find({ "field" : { $gt: value }}) // 大于: field > value db.集合名称.find({ "field" : { $lt: value }}) // 小于: field < value db.集合名称.find({ "field" : { $gte: value }}) // 大于等于: field >= value db.集合名称.find({ "field" : { $lte: value }}) // 小于等于: field <= value db.集合名称.find({ "field" : { $ne: value }}) // 不等于: field != value

示例:查询评论点赞数量大于700的记录

1 db.comment.find({likenum:{$gt:NumberInt(700 )}})

文档的包含查询 包含使用$in操作符。 示例:查询评论的集合中userid字段包含1003或1004的文档

1 db.comment.find({userid:{$in :["1003","1004"]}})

不包含使用$nin操作符。 示例:查询评论集合中userid字段不包含1003和1004的文档

1 db.comment.find({userid:{$nin:["1003","1004"]}})

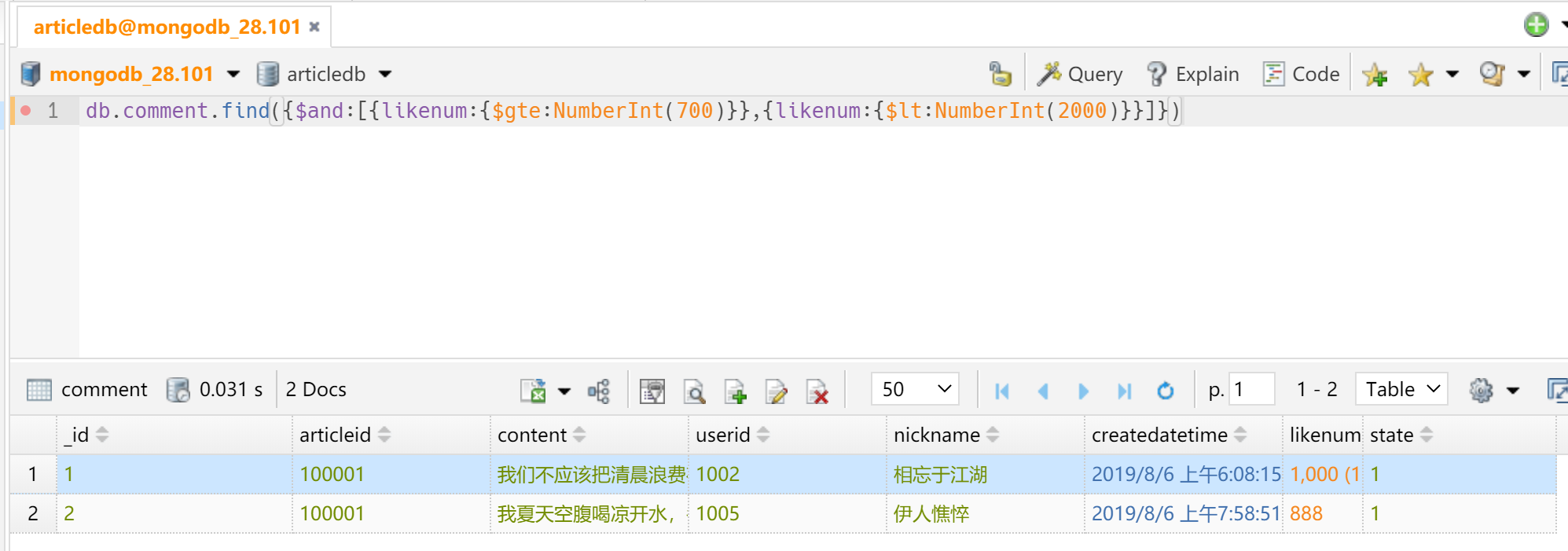

文档的条件连接查询 我们如果需要查询同时满足两个以上条件,需要使用$and操作符将条件进行关联 。(相当于SQL的and)格式为:

示例:查询评论集合中likenum大于等于700 并且小于2000的文档:

1 db.comment.find({$and :[{likenum:{$gte:NumberInt(700 )}},{likenum:{$lt:NumberInt(2000 )}}]})

如果两个以上条件之间是或者的关系,我们使用操作符进行关联 ,与前面and的使用方式相同格式为:

示例:查询评论集合中userid为1003,或者点赞数小于1000的文档记录

1 db.comment.find({$or :[ {userid:"1003"} ,{likenum:{$lt:1000 } }]})

小结 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 选择切换数据库:use articledb 插入数据:db.comment.insert({bson数据}) 查询所有数据:db.comment.find(); 条件查询数据:db.comment.find({条件}) 查询符合条件的第一条记录:db.comment.findOne({条件}) 查询符合条件的前几条记录:db.comment.find({条件}).limit(条数) 查询符合条件的跳过的记录:db.comment.find({条件}).skip(条数) 修改数据:db.comment.update({条件},{修改后的数据}) 或db.comment.update({条件},{$set:{要修改部分的字段:数据}) 修改数据并自增某字段值:db.comment.update({条件},{$inc:{自增的字段:步进值}}) 删除数据:db.comment.remove({条件}) 统计查询:db.comment.count({条件}) 模糊查询:db.comment.find({字段名:/正则表达式/}) 条件比较运算:db.comment.find({字段名:{$gt:值}}) 包含查询:db.comment.find({字段名:{$in:[值1,值2]}})或db.comment.find({字段名:{$nin:[值1,值2]}}) 条件连接查询:db.comment.find({$and:[{条件1},{条件2}]})或db.comment.find({$or:[{条件1},{条件2}]})

七、聚合查询 1. 语法 1 2 3 4 db.集合名.aggregate([ {管道:{表达式}} ... ])

常用管道 :

$group

将集合中的文档分组,用于统计结果

$match

过滤数据,只输出符合条件的文档

$sort

聚合数据进一步排序

$skip

跳过指定文档数

$limit

限制集合数据返回文档数

常用表达式 :

$sum

总和($num:1同count表示统计)

$avg

平均

$min

最小值

$max

最大值

2. 测试 数据准备:

1 2 3 4 5 db.people.insert({_id:1,name:"a",sex:"男",age:21}) db.people.insert({_id:2,name:"b",sex:"男",age:20}) db.people.insert({_id:3,name:"c",sex:"女",age:20}) db.people.insert({_id:4,name:"d",sex:"女",age:18}) db.people.insert({_id:5,name:"e",sex:"男",age:19})

统计男生、女生的总年龄

1 2 3 db.people.aggregate([ {$group:{_id:"$sex",age_sum:{$sum:"$age"}}} ])

统计男生女生的总人数

1 2 3 db.people.aggregate([ {$group:{_id:"$sex",sum:{$sum:1}}} ])

求学生总数和平均年龄

1 2 3 db.people.aggregate([ {$group:{_id:null,total_num:{$sum:1},total_avg:{$avg:"$age"}}} ])

查询男生、女生人数,按人数升序

1 2 3 4 db.people.aggregate([ {$group:{_id:"$sex",rs:{$sum:1}}}, {$sort:{rs:1}} ])

Map-Reduce操作 MongoDB提供Map-Reduce操作来进行聚合操作。通常,Map-Reduce操作有两个阶段,即Map和Reduce阶段 ,其中Map阶段是对集合中的每个输入文档进行处理,处理结束后输出一个或多个结果,****Reduce阶段是将Map阶段输出的一个或多个结果进行合并输出 。

①query阶段,查询集合orders中字段status为A的文档

②map阶段,按照字段cust_id进行分组,将字段cust_id相同的amount值放到一个数组中

③reduce阶段,通过函数sum对每组的amount值进行求和

④output阶段,将结果输出到集合order_totals中

1 2 3 4 5 6 7 8 9 10 db.COLLECTION_NAME.mapReduce( function (){emit(key,value );}, / / map函数 function (key,values ){return reduceFunction}, / / reduce函数 { query:条件, out :New_COLLECTION_NAME, sort:条件, limit:number } )

示例:

查询集合comment中字段state为1的文档,按照字段nickname对文档进行分组,计算出每个评论者的评论条数。

1 2 3 4 5 6 7 8 db.comment.mapReduce( function (){emit(this.nickname,1 );}, function (key,values ){return Array.sum (values )}, { query:{state:"1"}, out :"comment_total" } )

查询结果集合comment_total中的结果数据。

八、索引 1. 简介 索引 是一种排序好的便于快速查询数据的数据结构,用于帮助数据库高效的查询数据

优点 :

提高数据查询的效率,降低数据库的IO成本

通过索引对数据进行排序,降低数据排序的成本,降低CPU的消耗

缺点 :

占用磁盘空间

大量索引影响SQL语句的执行效率,因为每次插入和修改数据都要更新索引

2. 语法 创建索引语法 :

1 2 3 4 5 6 7 8 9 10 11 12 # 创建索引 db.集合名.createIndex(待创建索引的列:方式 [,额外选项]) # 创建复合索引 db.集合名.createIndex({key1:方式,key2:方式} [,额外选项]) # 参数说明: - `待创建索引的列:方式`:{key:1}/{key:-1} 1表示升序,-1表示降序; 例如{age:1}表示创建age索引并按照升序方法排列 - `额外选项`:设置索引的名称或者唯一索引等 设置名称:{name:索引名} 唯一索引:{unique:列名}

删除索引语法 :

1 2 3 4 5 # 删除全部索引 db.集合名.dropIndexes() # 删除指定索引 db.集合名.dropIndex(索引名)

查看索引语法 :

1 2 # 查看索引 db.集合名.getIndexes()

3. 练习 十万条数据准备 :

1 2 3 4 5 6 # 选择数据库 use test # 插入100000条数据 for(var i=0;i<100000;i++){ db.data.insert({name:"zsr"+i,age:i}) }

创建普通索引

1 2 3 4 5 # 给name添加普通升序索引 db.data.createIndex({name:1}) db.data.getIndexes() # 查看索引

1 2 # 给age创建索引并起名age_up db.data.createIndex({age:1},{name:"age_up"})

删除索引

1 2 # 删除name列的索引 db.data.dropIndex("name_1")

创建复合/组合索引 :也就是一次给两个字段建立索引

1 2 # 给name和age添加组合索引 db.data.createIndex({name:1,age:1})

创建唯一索引

1 2 3 4 5 # 删除所有索引 db.data.dropIndexes() # 给name创建唯一索引 db.data.createIndex({name:1},{unique:"name"})

4. 分析索引(explain) 1 db.集合名.find().explain('executionStats')

我们通过简单的案例来测试索引的好处

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 > db.data.find({age:500}).explain('executionStats' ) { "queryPlanner" : { "plannerVersion" : 1, "namespace" : "test.data", "indexFilterSet" : false, "parsedQuery" : { "age" : { "$eq" : 500 } }, "winningPlan" : { "stage" : "COLLSCAN", "filter" : { "age" : { "$eq" : 500 } }, "direction" : "forward" }, "rejectedPlans" : [ ] }, "executionStats" : { #执行计划相关统计信息 "executionSuccess" : true, #执行成功的状态 "nReturned" : 1, #返回结果集数目 "executionTimeMillis" : 37, #执行所需要的ms数 "totalKeysExamined" : 0, #索引检查的时间 "totalDocsExamined" : 100000, #检查文档总数 "executionStages" : { "stage" : "COLLSCAN", #索引扫描方式 "filter" : { #过滤条件 "age" : { "$eq" : 500 } }, "nReturned" : 1, #返回结果集数目 "executionTimeMillisEstimate" : 1, #预估执行时间(ms) "works" : 100002, #工作单元数,一个查询会被派生为一个小的工作单元 "advanced" : 1, #优先返回的结果数 "needTime" : 100000, "needYield" : 0, "saveState" : 100, "restoreState" : 100, "isEOF" : 1, "direction" : "forward", "docsExamined" : 100000 #文档检查数目 } }, "serverInfo" : { "host" : "LAPTOP-8J48VF43", "port" : 27017, "version" : "4.4.2", "gitVersion" : "15e73dc5738d2278b688f8929aee605fe4279b0e" }, "ok" : 1 }

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 # 给age添加升序索引 > db.data.createIndex({age:1}) { "createdCollectionAutomatically" : false, "numIndexesBefore" : 2, "numIndexesAfter" : 3, "ok" : 1 } # 性能分析 > db.data.find({age:500}).explain('executionStats' ) { "queryPlanner" : { "plannerVersion" : 1, "namespace" : "test.data", "indexFilterSet" : false, "parsedQuery" : { "age" : { "$eq" : 500 } }, "winningPlan" : { "stage" : "FETCH", "inputStage" : { "stage" : "IXSCAN", "keyPattern" : { "age" : 1 }, "indexName" : "age_1", "isMultiKey" : false, "multiKeyPaths" : { "age" : [ ] }, "isUnique" : false, "isSparse" : false, "isPartial" : false, "indexVersion" : 2, "direction" : "forward", "indexBounds" : { "age" : [ "[500.0, 500.0]" ] } } }, "rejectedPlans" : [ ] }, "executionStats" : { #执行计划相关统计信息 "executionSuccess" : true, #执行成功的状态 "nReturned" : 1, #返回结果集数目 "executionTimeMillis" : 1, #执行所需要的ms数 "totalKeysExamined" : 1, #索引检查的时间 "totalDocsExamined" : 1, #检查文档总数 "executionStages" : { "stage" : "FETCH", #索引扫描方式 "nReturned" : 1, #返回结果集数目 "executionTimeMillisEstimate" : 0, #预估执行时间(ms) "works" : 2, #工作单元数,一个查询会被派生为一个小的工作单元 "advanced" : 1, #优先返回的结果数 "needTime" : 0, "needYield" : 0, "saveState" : 0, "restoreState" : 0, "isEOF" : 1, "docsExamined" : 1, "alreadyHasObj" : 0, "inputStage" : { "stage" : "IXSCAN", "nReturned" : 1, "executionTimeMillisEstimate" : 0, "works" : 2, "advanced" : 1, "needTime" : 0, "needYield" : 0, "saveState" : 0, "restoreState" : 0, "isEOF" : 1, "keyPattern" : { "age" : 1 }, "indexName" : "age_1", "isMultiKey" : false, "multiKeyPaths" : { "age" : [ ] }, "isUnique" : false, "isSparse" : false, "isPartial" : false, "indexVersion" : 2, "direction" : "forward", "indexBounds" : { "age" : [ "[500.0, 500.0]" ] }, "keysExamined" : 1, "seeks" : 1, "dupsTested" : 0, "dupsDropped" : 0 } } }, "serverInfo" : { "host" : "LAPTOP-8J48VF43", "port" : 27017, "version" : "4.4.2", "gitVersion" : "15e73dc5738d2278b688f8929aee605fe4279b0e" }, "ok" : 1 }

三种扫描方式

COLLSCAN:全盘扫描INSCAN:索引扫描FETCH:根据索引去检索指定document

5. 选择规则 如何选择合适的列创建索引?

为常做条件、排序、分组的字段建立索引

选择唯一性索引

选择较小的数据列,为较长的字符串使用前缀索引

九、权限机制

安装完Mongodb后,在命令行输入mongo命令即可登录数据库,这肯定是不安全的,我们需要使用权限机制,开启验证模式

创建账号语法 创建账号

1 2 3 4 5 6 7 8 db.createUser({ "user":"账号", "pwd":"密码", "roles":[{ role:"角色", db:"所属数据库" }] })

角色种类

超级用户角色:root

数据库用户角色:read、readWrite

数据库管理角色:dbAdmin、userAdmin

集群管理角色: clusterAdmin、clusterManager、clusterMonitor、hostManager

备份恢复角色: backup、restore

所有数据库角色: readAnyDatabase、readWriteAnyDatabase、userAdminAnyDatabase、dbAdminAnyDatabase

角色说明

root:只在admin数据库中可用。超级账号,超级权限;read:允许用户读取指定数据库;readWrite:允许用户读写指定数据库

开启验证模式

验证模式 :值用户需要输入账号密码才能登录使用

1. 添加超级管理员账号 1 2 3 4 5 6 7 8 9 10 11 12 # 必须使用admin数据库 use admin # 创建超级用户 db.createUser({ "user":"zsr", "pwd":"123456", "roles":[{ role:"root", db:"admin" }] })

system.users可以查看详细信息

2. 卸载服务 首先exit退出登录,然后以管理员模式打开终端输入如下命令卸载服务

3. 安装需要身份验证的服务 1 mongod --install --dbpath 数据目录 --logpath 日志目录\日志名称 --auth

这里为:

1 mongod --install --dbpath D:\JAVA_Environment\MongoDB\mongodb-win32-x86_64-windows-4.4.2\data --logpath D:\JAVA_Environment\MongoDB\mongodb-win32-x86_64-windows-4.4.2\logs\mongodb-zsr.log --auth

4. 启动服务

5. 登录测试 输入mongo命令登录,可以发现不再显示警告,且查看数据库看不到,这是因为还没有身份验证,没有通过账号登录

6. 通过超级管理员账号登录 1 2 # 方法一 mongo 服务器ip地址:端口号/数据库 -u 用户名 -p 密码

1 2 3 4 # 方法二 mongo #先登录 use admin #选择数据库 db.auth(用户名,密码)

练习

添加用户shop1可以读shop数据库

添加用户shop2可以读写shop数据库

注意:必须在对应的数据库中创建用户

1 2 3 4 use shop for(var i=1;i<=10;i++){ db.goods.insert({name:"goods"+i,price:i}) }

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 use shop # 创建shop1用户 db.createUser({ "user":"shop1", "pwd":"123456", "roles":[{ role:"read", db:"shop" }] }) # 创建shop2用户 db.createUser({ "user":"shop2", "pwd":"123456", "roles":[{ role:"readWrite", db:"shop" }] })

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 # 验证shop1可读 C:\WINDOWS\system32>mongo localhost:27017/shop -u shop1 -p 123456 MongoDB shell version v4.4.2 connecting to: mongodb://localhost:27017/shop?compressors=disabled&gssapiServiceName=mongodb Implicit session: session { "id" : UUID("727ada5f-985f-4858-bb30-523d1777fa3a") } MongoDB server version: 4.4.2 > show dbs shop 0.000GB > db.goods.find() { "_id" : ObjectId("60364ec9fd9e42c81a76f431"), "name" : "goods1", "price" : 1 } { "_id" : ObjectId("60364ec9fd9e42c81a76f432"), "name" : "goods2", "price" : 2 } { "_id" : ObjectId("60364ec9fd9e42c81a76f433"), "name" : "goods3", "price" : 3 } { "_id" : ObjectId("60364ec9fd9e42c81a76f434"), "name" : "goods4", "price" : 4 } { "_id" : ObjectId("60364ec9fd9e42c81a76f435"), "name" : "goods5", "price" : 5 } { "_id" : ObjectId("60364ec9fd9e42c81a76f436"), "name" : "goods6", "price" : 6 } { "_id" : ObjectId("60364ec9fd9e42c81a76f437"), "name" : "goods7", "price" : 7 } { "_id" : ObjectId("60364ec9fd9e42c81a76f438"), "name" : "goods8", "price" : 8 } { "_id" : ObjectId("60364ec9fd9e42c81a76f439"), "name" : "goods9", "price" : 9 } { "_id" : ObjectId("60364ec9fd9e42c81a76f43a"), "name" : "goods10", "price" : 10 } > db.goods.insert({name:"zsr" }) WriteCommandError({ "ok" : 0, "errmsg" : "not authorized on shop to execute command { insert: \"goods\", ordered: true, lsid: { id: UUID(\"727ada5f-985f-4858-bb30-523d1777fa3a\") }, $db: \"shop\" }", "code" : 13, "codeName" : "Unauthorized" }) # 验证shop2可读可写 C:\WINDOWS\system32>mongo localhost:27017/shop -u shop2 -p 123456 MongoDB shell version v4.4.2 connecting to: mongodb://localhost:27017/shop?compressors=disabled&gssapiServiceName=mongodb Implicit session: session { "id" : UUID("1fbca023-aeb3-4514-b2e4-700934000cc9") } MongoDB server version: 4.4.2 > db.goods.find() { "_id" : ObjectId("60364ec9fd9e42c81a76f431"), "name" : "goods1", "price" : 1 } { "_id" : ObjectId("60364ec9fd9e42c81a76f432"), "name" : "goods2", "price" : 2 } { "_id" : ObjectId("60364ec9fd9e42c81a76f433"), "name" : "goods3", "price" : 3 } { "_id" : ObjectId("60364ec9fd9e42c81a76f434"), "name" : "goods4", "price" : 4 } { "_id" : ObjectId("60364ec9fd9e42c81a76f435"), "name" : "goods5", "price" : 5 } { "_id" : ObjectId("60364ec9fd9e42c81a76f436"), "name" : "goods6", "price" : 6 } { "_id" : ObjectId("60364ec9fd9e42c81a76f437"), "name" : "goods7", "price" : 7 } { "_id" : ObjectId("60364ec9fd9e42c81a76f438"), "name" : "goods8", "price" : 8 } { "_id" : ObjectId("60364ec9fd9e42c81a76f439"), "name" : "goods9", "price" : 9 } { "_id" : ObjectId("60364ec9fd9e42c81a76f43a"), "name" : "goods10", "price" : 10 } > db.goods.insert({name:"zsr" }) 可写 WriteResult({ "nInserted" : 1 })

十、备份还原 下载MongoDB数据库工具

进行备份还原之前,首先要下载相关的工具

MongoDB Database Tools:https://www.mongodb.com/try/download/database-tools

MongoDB数据库工具是用于处理MongoDB部署的命令行实用程序的集合。这些工具独立于MongoDB Server计划发布,使您能够获得更频繁的更新,并在新功能可用时立即加以利用。有关更多信息,请参阅MongoDB数据库工具文档。

bin目录,可以看到各种工具,接下来的备份还原就需要用到其中的mongodump和mongorestoreexe文件拷贝到MongoDB安装目录下的bin目录中

备份数据库mongodump 1 2 3 4 5 6 7 8 9 10 # 导出数据 mongodump -h -port -u -p -d -o # 说明 -h 服务器ip地址(一般不写,默认本机) -port 端口(一般不写,默认27017) -u 账号 -p 密码 -d 数据库(不写则表示导出全部) -o 备份到指定目录下

1️⃣ 备份所有数据:

在MongoDB安装目录下新建一个data_backup目录用于存放所有的备份数据

1 mongodump -u zsr -p 123456 -o D:\JAVA_Environment\MongoDB\mongodb-win32-x86_64-windows-4.4.2\data_backup

data_backup目录,可以看到备份的所有的数据库

2️⃣ 备份指定数据:

在MongoDB安装目录下新建一个data_backup2目录用于存放备份的shop数据库

1 2 # 用具有读权限的shop1/shop2用户都可以 mongodump -u shop1 -p 123456 -d shop -o D:\JAVA_Environment\MongoDB\mongodb-win32-x86_64-windows-4.4.2\data_backup2

data_backu2目录,可以看到备份的shop数据库

还原数据库mongorestore 1 2 3 4 5 6 7 8 9 mongostore -h -port -u -p -d --drop 备份数据目录 # 说明 -h 服务器ip地址(一般不写,默认本机) -port 端口(一般不写,默认27017) -u 账号 -p 密码 -d 数据库(不写则表示还原全部数据) --drop 先删除数据库再导入,不写则覆盖

1️⃣ 还原所有数据:

首先删除几个数据库data_backup目录进行恢复

1 mongorestore -u zsr -p 123456 --drop D:\JAVA_Environment\MongoDB\mongodb-win32-x86_64-windows-4.4.2\data_backup

2️⃣ 还原指定数据:

首先删除shop数据库data_backup2目录恢复shop数据库

1 2 # 用具有写权限的shop2用户 mongorestore -u shop2 -p 123456 -d shop --drop D:\JAVA_Environment\MongoDB\mongodb-win32-x86_64-windows-4.4.2\data_backup2\shop

十一、测试使用Java操作MongoDB 搭建Java环境 JDK的卸载 删除JDK的文件夹

1、在控制面板–程序中,卸载java8的旧版本

2、然后找到安装路径后,直接删除

删除环境变量的配置

此电脑–高级系统设置–环境变量–删除JAVA_HOME

删除Path中关于java的目录

测试是否卸载成功

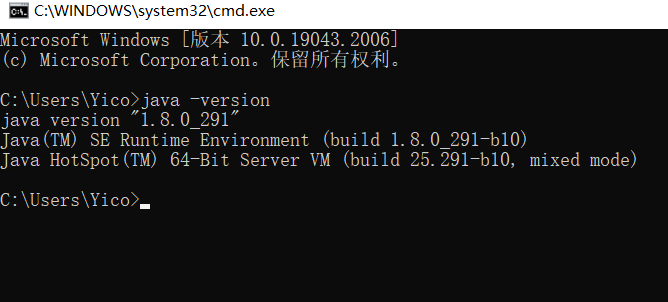

WIN + R 打开CMD,输入java -version 测试是否卸载成功。

安装新版的JDK 1、百度搜索JDK 8

2、同意协议3、下载电脑对应的版本

4、双击安装JDK

5、记住安装路径(避免使用中文路径)

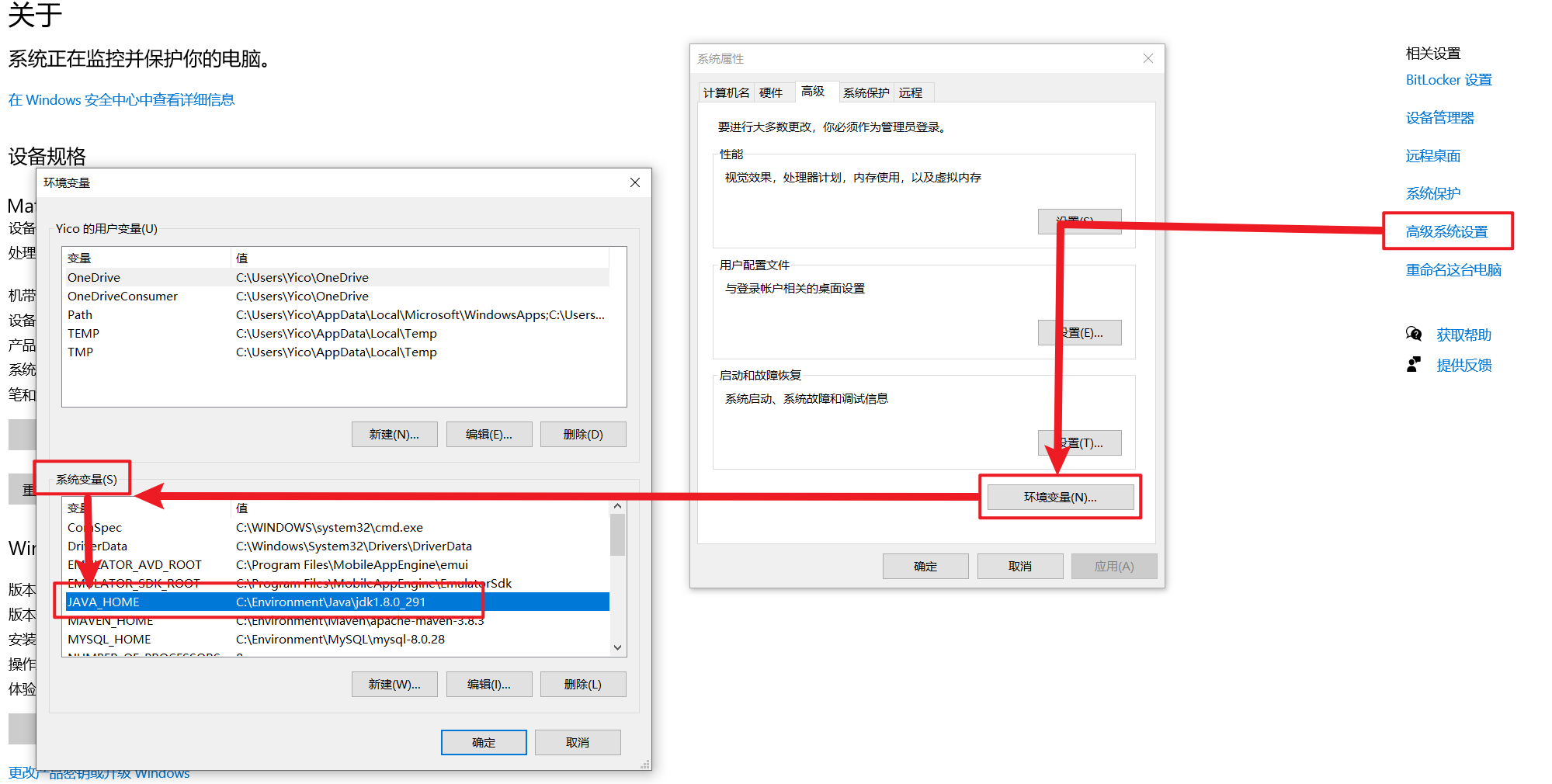

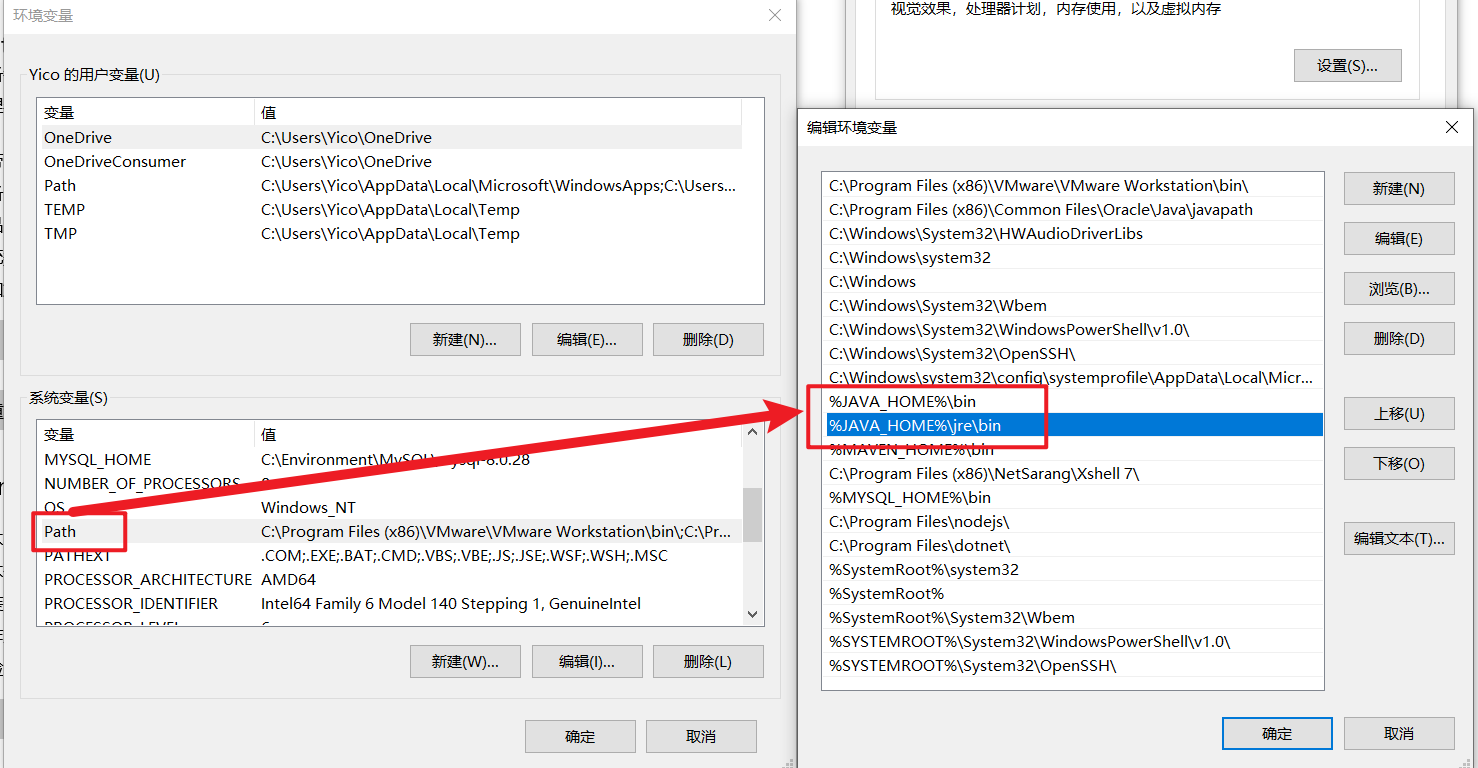

6、配置环境变量

1.此电脑–右键–属性–高级系统设置–环境变量

2.环境变量–>JAVA_HOME

3.配置Path变量

新建 %JAVA_HOME%\bin

新建 %JAVA_HOME%\jre\bin

4.测试是否成功

CMD中,输入java -version

maven的安装 访问maven官网下载Windows系统下的Maven安装包,本书下载的是maven 3.8.3版本,即apache-maven-3.8.3-bin.zip安装包。

将Maven安装路径下的bin目录添加到系统环境变量的Path变量中,这里添加的C:\Environment\Maven\apache-maven-3.8.3\bin。

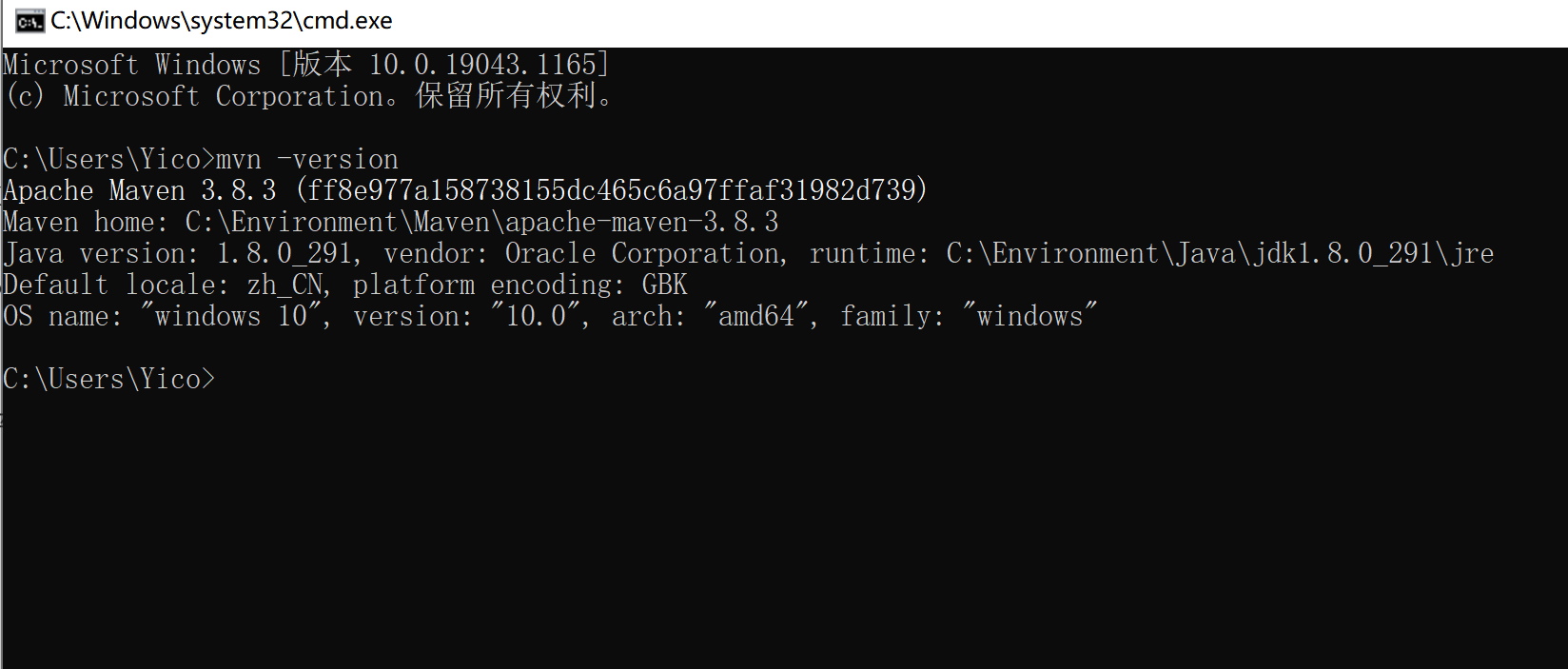

Maven环境变量配置完成后,在Windows的DOS窗口执行“mvn -version”命令,查看Maven是否安装配置成功。

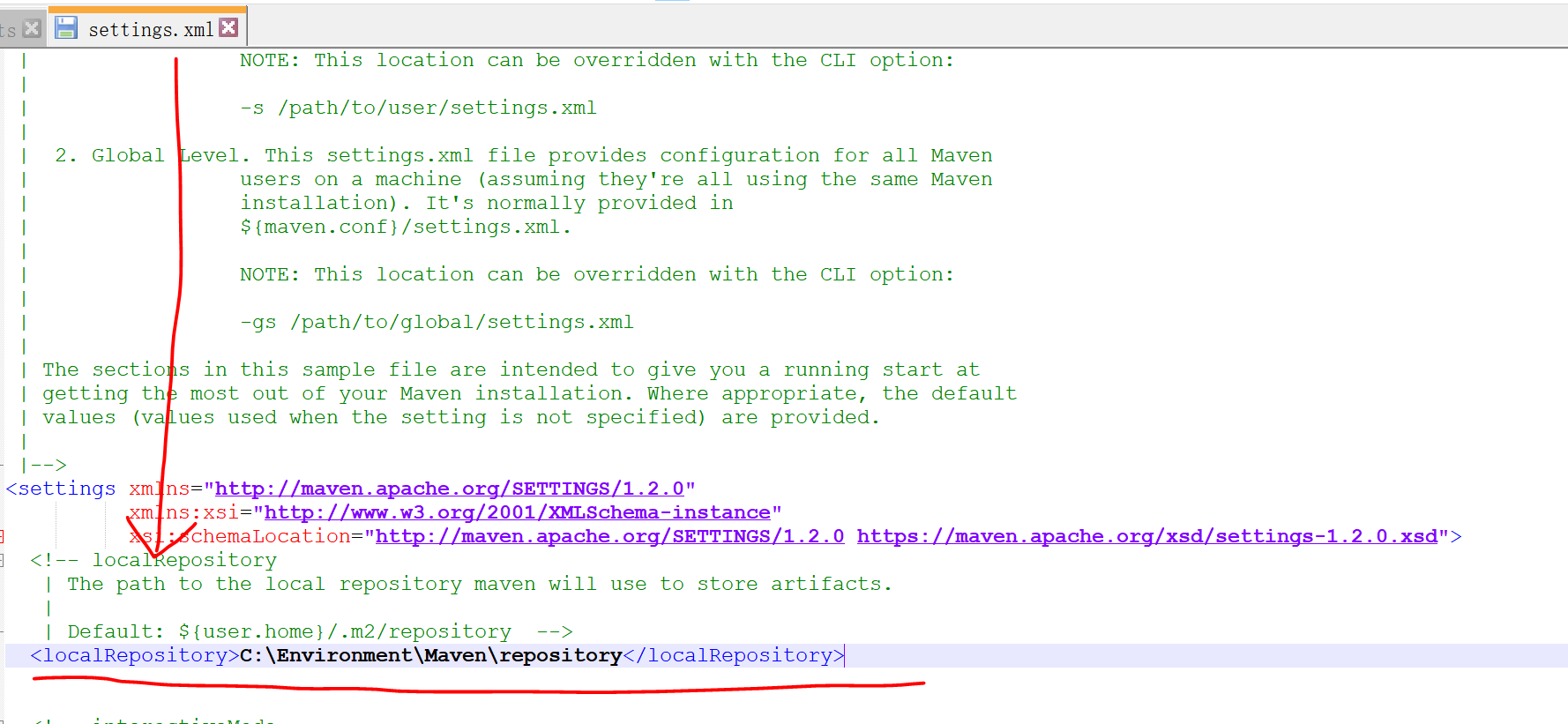

修改Maven配置文件settings.xml,该文件位于Maven安装路径下的conf文件夹内,向配置文件中添加本地仓库路径和远程仓库路径,需要注意的是本地仓库路径需要提前创建。

本地仓库

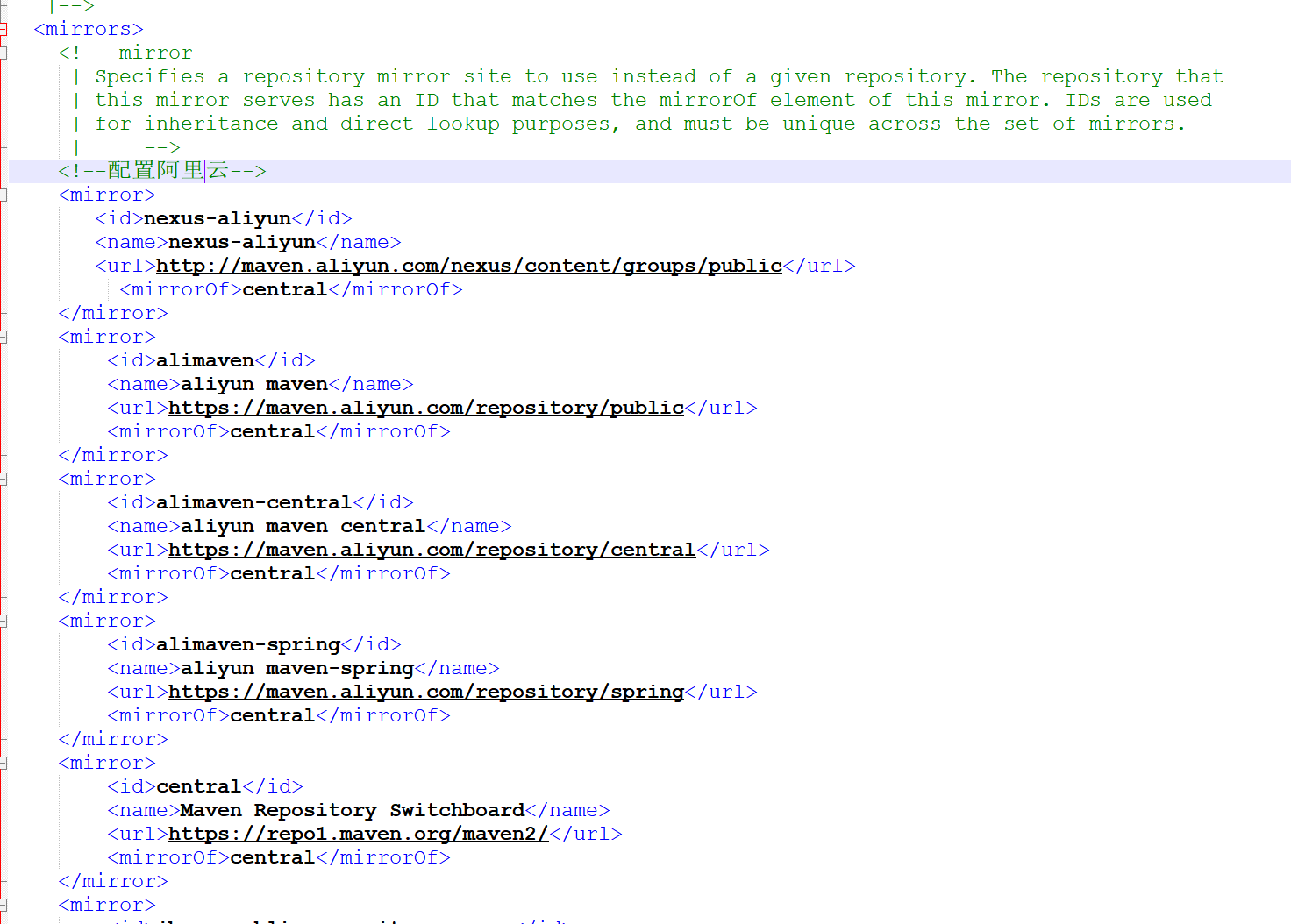

远程仓库(可配阿里云-自行百度)

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 <mirrors > <mirror > <id > nexus-aliyun</id > <name > nexus-aliyun</name > <url > http://maven.aliyun.com/nexus/content/groups/public</url > <mirrorOf > central</mirrorOf > </mirror > <mirror > <id > alimaven</id > <name > aliyun maven</name > <url > https://maven.aliyun.com/repository/public</url > <mirrorOf > central</mirrorOf > </mirror > <mirror > <id > alimaven-central</id > <name > aliyun maven central</name > <url > https://maven.aliyun.com/repository/central</url > <mirrorOf > central</mirrorOf > </mirror > <mirror > <id > alimaven-spring</id > <name > aliyun maven-spring</name > <url > https://maven.aliyun.com/repository/spring</url > <mirrorOf > central</mirrorOf > </mirror > <mirror > <id > central</id > <name > Maven Repository Switchboard</name > <url > https://repo1.maven.org/maven2/</url > <mirrorOf > central</mirrorOf > </mirror > <mirror > <id > jboss-public-repository-group</id > <mirrorOf > central</mirrorOf > <name > JBoss Public Repository Group</name > <url > http://repository.jboss.org/nexus/content/groups/public</url > </mirror > <mirror > <id > spring-snapshots</id > <mirrorOf > central</mirrorOf > <name > Spring Snapshots</name > <url > https://repo.spring.io/snapshot</url > </mirror > <mirror > <id > spring-milestones</id > <mirrorOf > central</mirrorOf > <name > Spring Milestones</name > <url > https://repo.spring.io/milestone</url > </mirror > <mirror > <id > maven-default-http-blocker</id > <mirrorOf > external:http:*</mirrorOf > <name > Pseudo repository to mirror external repositories initially using HTTP.</name > <url > http://0.0.0.0/</url > <blocked > true</blocked > </mirror > </mirrors >

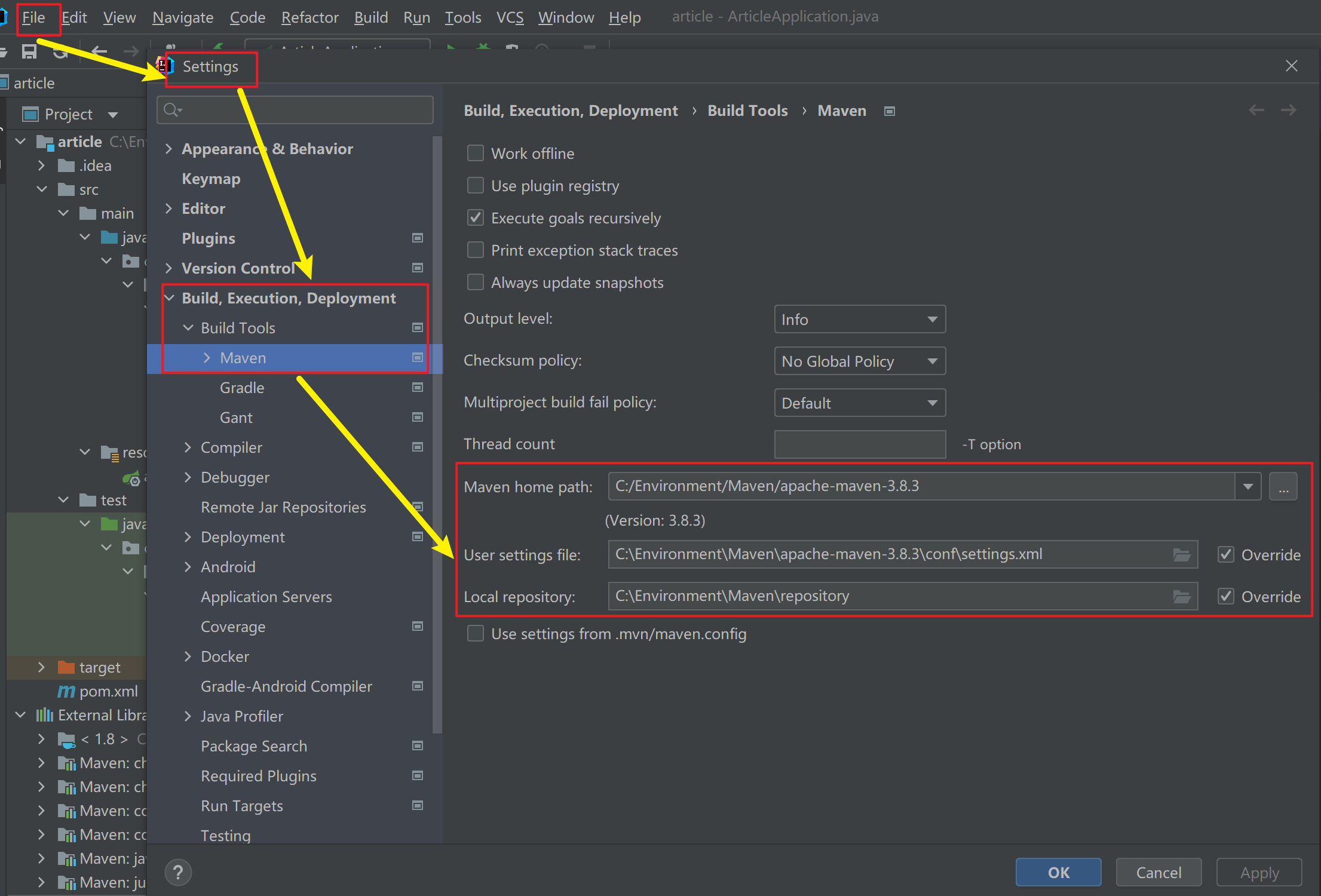

基于Java API操作MongoDB idea项目建立 配置IDEA工具,在IDEA安装完成后的界面,单击“Configure”→“Settings”→“Build,Execution,Deployment”→“Build Tools”→“Maven”,将Maven添加至IDEA工具中。

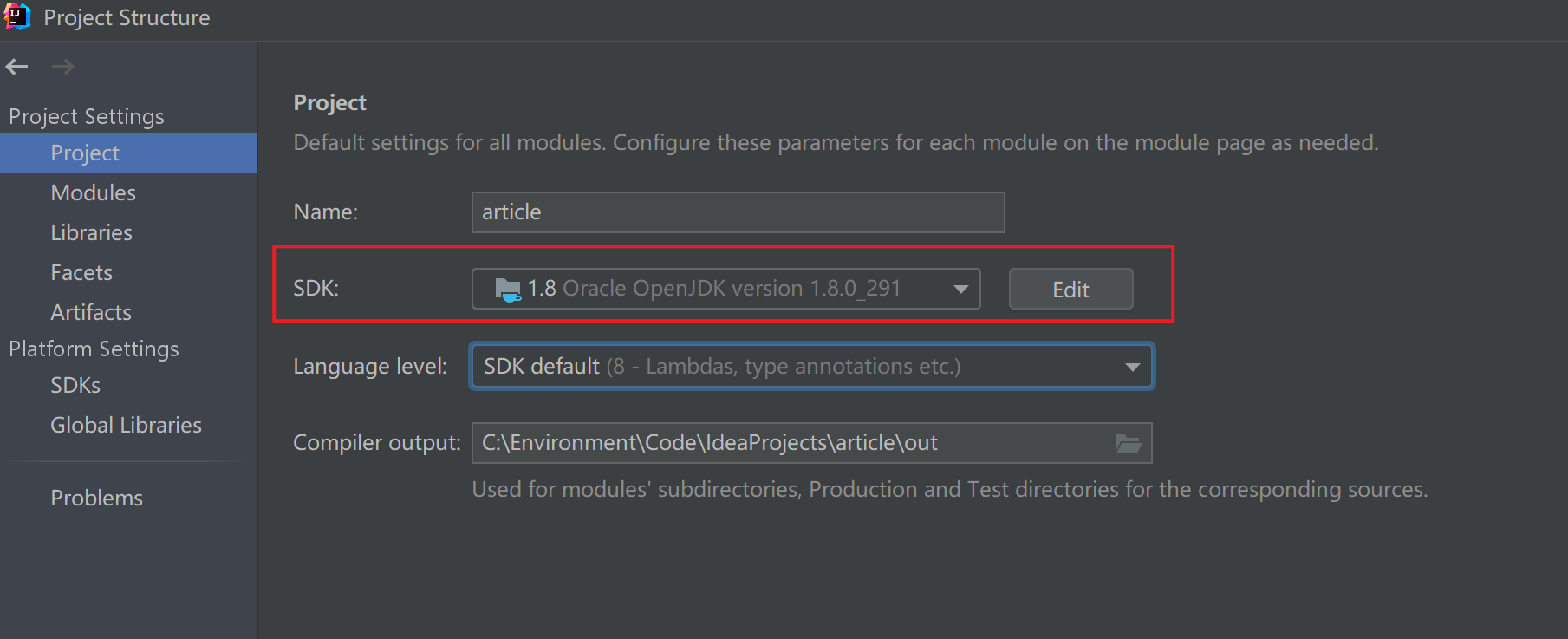

配置IDEA工具,在IDEA安装完成后的界面,“Configure”→“Structure for New Projects”→“Project”,将jdk添加至IDEA工具中。

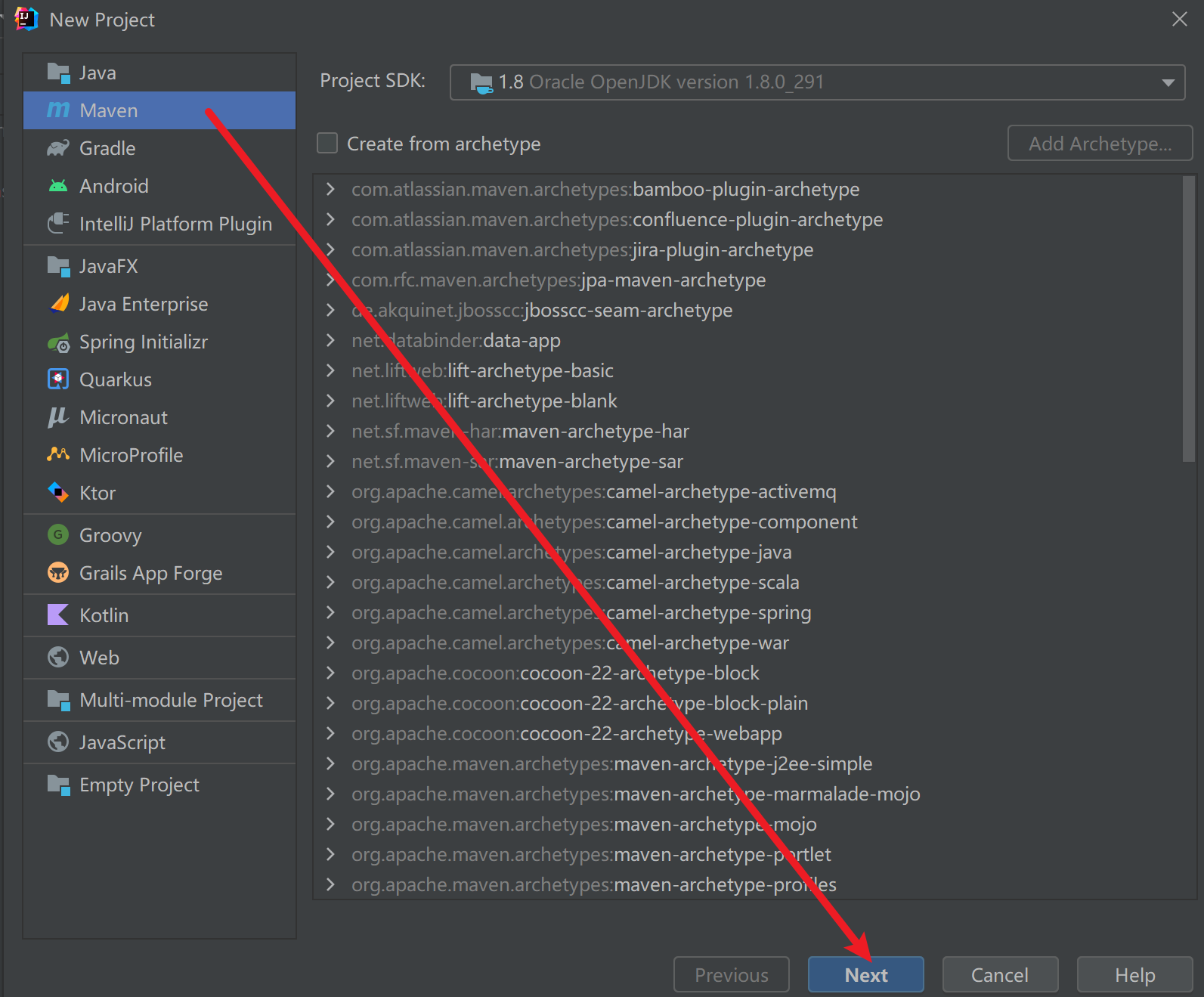

打开IDEA工具,单击“Create New Project”→“Maven”,选择创建一个Maven项目。

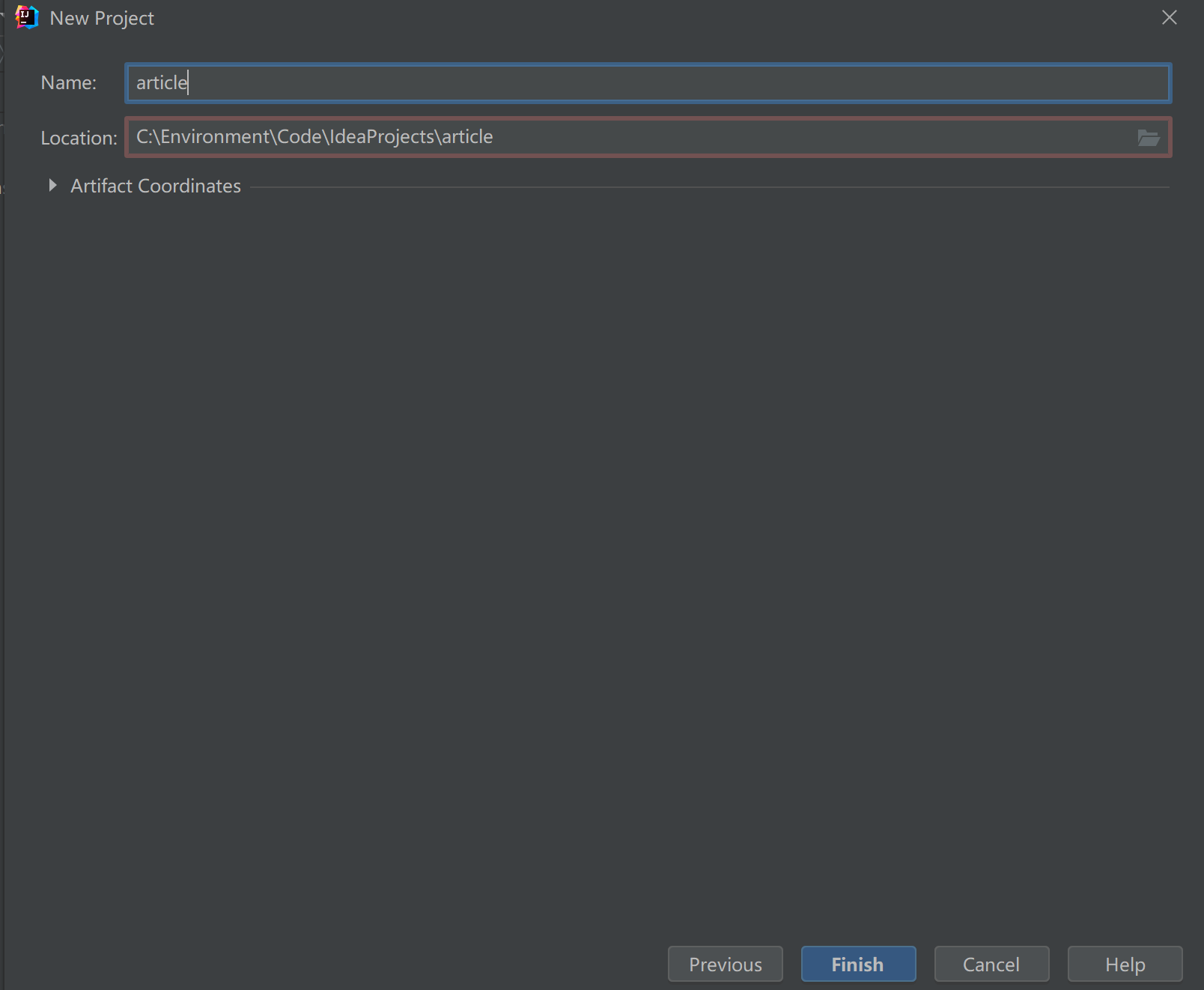

添加Maven项目的名称和指定项目的存储路径。

完成Maven项目的创建。

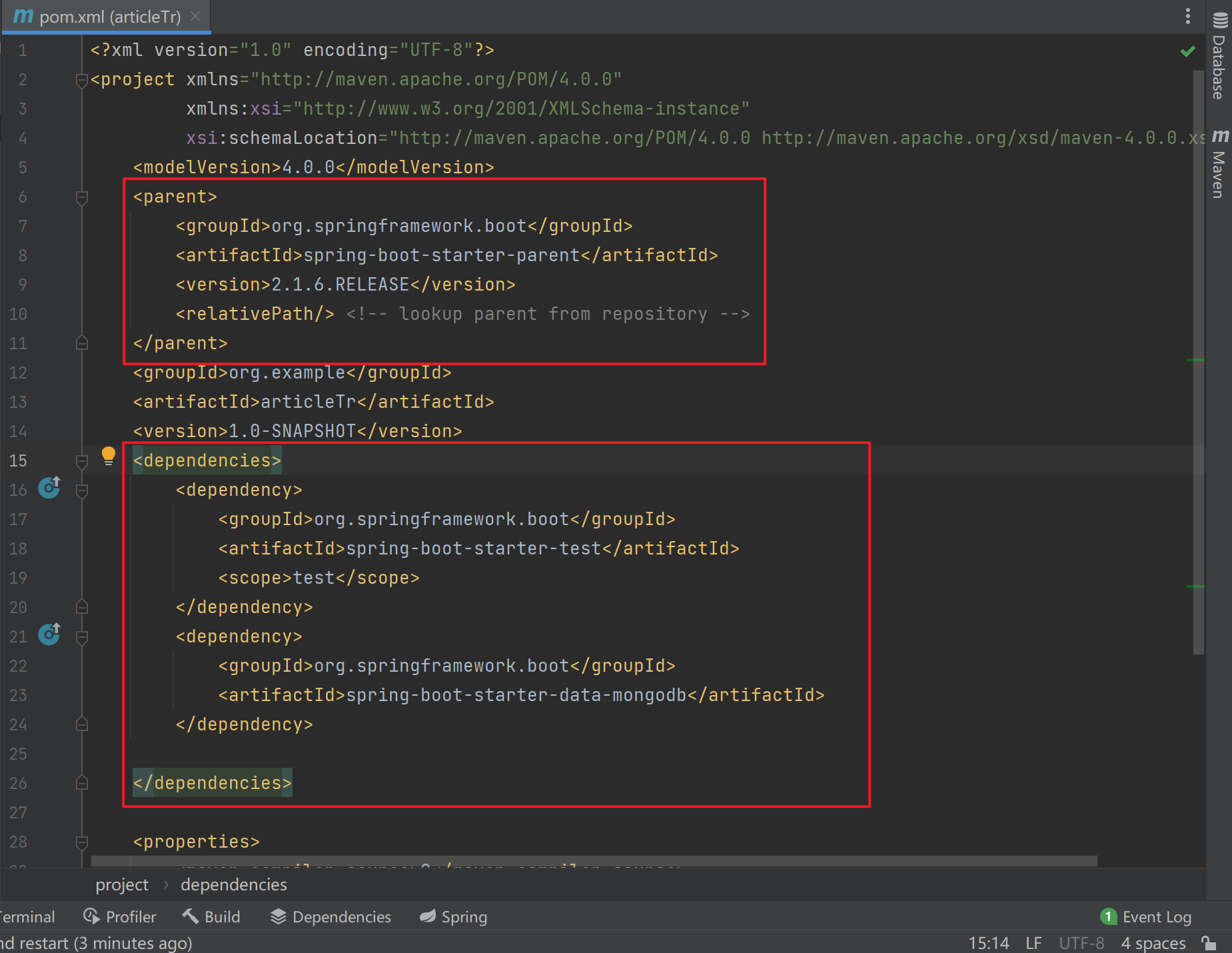

在项目article中配置pom.xml文件,引入MongoDB相关的依赖和单元测试的依赖 。

项目实训 文章评论 需要实现 以下功能:

1)基本增删改查API

2)根据文章id查询评论

3)评论点赞

数据库:articledb

文章微服务模块搭建 (1)搭建项目工程article,并设置pom.xml引入依赖: 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 <?xml version="1.0" encoding="UTF-8" ?> <project xmlns ="http://maven.apache.org/POM/4.0.0" xmlns:xsi ="http://www.w3.org/2001/XMLSchema-instance" xsi:schemaLocation ="http://maven.apache.org/POM/4.0.0 http://maven.apache.org/xsd/maven-4.0.0.xsd" > <modelVersion > 4.0.0</modelVersion > <parent > <groupId > org.springframework.boot</groupId > <artifactId > spring-boot-starter-parent</artifactId > <version > 2.1.6.RELEASE</version > <relativePath /> </parent > <groupId > org.example</groupId > <artifactId > article</artifactId > <version > 1.0-SNAPSHOT</version > <dependencies > <dependency > <groupId > org.springframework.boot</groupId > <artifactId > spring-boot-starter-test</artifactId > <scope > test</scope > </dependency > <dependency > <groupId > org.springframework.boot</groupId > <artifactId > spring-boot-starter-data-mongodb</artifactId > </dependency > </dependencies > <properties > <maven.compiler.source > 8</maven.compiler.source > <maven.compiler.target > 8</maven.compiler.target > </properties > </project >

(2)在article\src\main\resources下创建文件application.yml 1 2 3 4 5 spring: #数据源配置 data: mongodb: uri: mongodb:

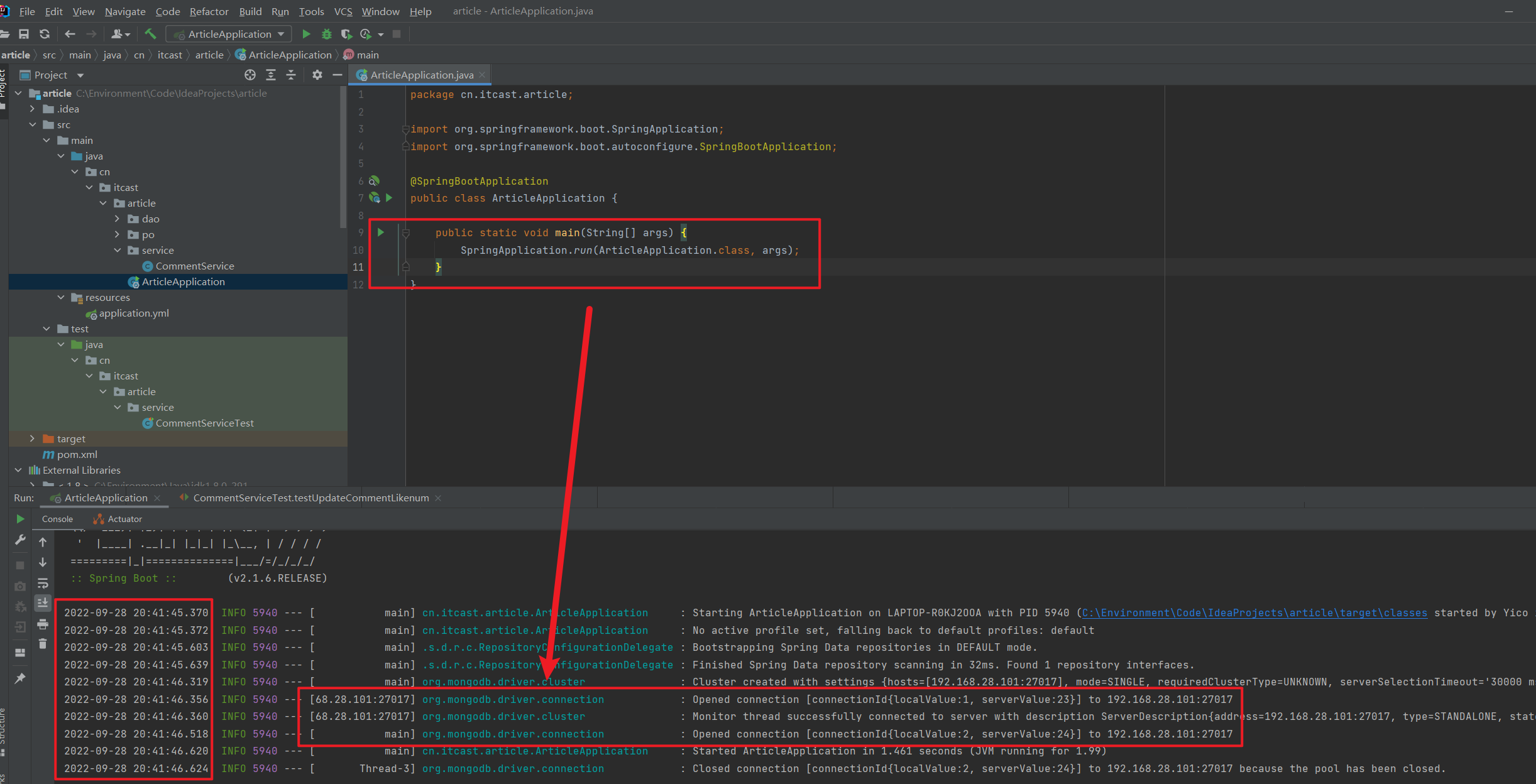

(3)创建启动类 在article\src\main\java下创建类cn.itcast.article.ArticleApplication(此处命名方法使用到包机制)

1 2 3 4 5 6 7 8 9 10 11 12 package cn.itcast.article;import org.springframework.boot.SpringApplication;import org.springframework.boot.autoconfigure.SpringBootApplication;@SpringBootApplication public class ArticleApplication { public static void main (String[] args) { SpringApplication.run(ArticleApplication.class, args); } }

(4)启动项目,看是否能正常启动,控制台没有错误。

文章评论实体类的编写 在article\src\main\java下创建实体类,创建包cn.itcast.article,包下建包po用于存放实体类,创建实体类

cn.itcast.article.po.Comment

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143 144 145 146 147 package cn.itcast.article.po;import org.springframework.data.annotation.Id;import org.springframework.data.mongodb.core.index.CompoundIndex;import org.springframework.data.mongodb.core.index.Indexed;import org.springframework.data.mongodb.core.mapping.Document;import org.springframework.data.mongodb.core.mapping.Field;import java.io.Serializable;import java.time.LocalDateTime;import java.util.Date;@Document(collection="comment") @CompoundIndex( def = "{'userid': 1, 'nickname': -1}") public class Comment implements Serializable { private String id; @Field("content") private String content; private Date publishtime; @Indexed private String userid; private String nickname; private LocalDateTime createdatetime; private Integer likenum; private Integer replynum; private String state; private String parentid; private String articleid; public String getId () { return id; } public void setId (String id) { this .id = id; } public String getContent () { return content; } public void setContent (String content) { this .content = content; } public Date getPublishtime () { return publishtime; } public void setPublishtime (Date publishtime) { this .publishtime = publishtime; } public String getUserid () { return userid; } public void setUserid (String userid) { this .userid = userid; } public String getNickname () { return nickname; } public void setNickname (String nickname) { this .nickname = nickname; } public LocalDateTime getCreatedatetime () { return createdatetime; } public void setCreatedatetime (LocalDateTime createdatetime) { this .createdatetime = createdatetime; } public Integer getLikenum () { return likenum; } public void setLikenum (Integer likenum) { this .likenum = likenum; } public Integer getReplynum () { return replynum; } public void setReplynum (Integer replynum) { this .replynum = replynum; } public String getState () { return state; } public void setState (String state) { this .state = state; } public String getParentid () { return parentid; } public void setParentid (String parentid) { this .parentid = parentid; } public String getArticleid () { return articleid; } public void setArticleid (String articleid) { this .articleid = articleid; } @Override public String toString () { return "Comment{" + "id='" + id + '\'' + ", content='" + content + '\'' + ", publishtime=" + publishtime + ", userid='" + userid + '\'' + ", nickname='" + nickname + '\'' + ", createdatetime=" + createdatetime + ", likenum=" + likenum + ", replynum=" + replynum + ", state='" + state + '\'' + ", parentid='" + parentid + '\'' + ", articleid='" + articleid + '\'' + '}' ; } }

文章评论的基本增删改查 (1)创建数据访问接口 cn.itcast.article包下创建dao包,包下创建接口 cn.itcast.article.dao.CommentRepository

1 2 3 4 5 6 7 8 9 10 11 12 13 package cn.itcast.article.dao;import cn.itcast.article.po.Comment;import org.springframework.data.domain.Page;import org.springframework.data.domain.Pageable;import org.springframework.data.mongodb.repository.MongoRepository;public interface CommentRepository extends MongoRepository <Comment,String > { Page<Comment> findByParentid (String parentid,Pageable pageable) ; }

(2)创建业务逻辑类 cn.itcast.article包下创建service包,包下创建类 cn.itcast.article.service.CommentService

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 package cn.itcast.article.service;import cn.itcast.article.dao.CommentRepository;import cn.itcast.article.po.Comment;import org.springframework.beans.factory.annotation.Autowired;import org.springframework.data.domain.Page;import org.springframework.data.domain.PageRequest;import org.springframework.data.domain.Pageable;import org.springframework.data.mongodb.core.MongoTemplate;import org.springframework.data.mongodb.core.query.Criteria;import org.springframework.data.mongodb.core.query.Query;import org.springframework.data.mongodb.core.query.Update;import org.springframework.stereotype.Service;import java.util.List;@Service public class CommentService { @Autowired private CommentRepository commentRepository; @Autowired private MongoTemplate mongoTemplate; public void saveComment (Comment comment) { commentRepository.save(comment); } public void updateComment (Comment comment) { commentRepository.save(comment); } public void deleteCommentById (String id) { commentRepository.deleteById(id); } public List<Comment> findCommentList () { return commentRepository.findAll(); } public Comment findCommentById (String id) { return commentRepository.findById(id).orElse(null ); } public Page<Comment> findCommentListByParentid (String parentid,int page,int size) { return commentRepository.findByParentid(parentid,PageRequest.of(page-1 ,size)); } public void updateCommentLikenum (String id) { Query query = Query.query(Criteria.where("_id" ).is(id)); Update update = new Update (); update.inc("likenum" ); mongoTemplate.updateFirst(query,update,Comment.class); } }

(3)新建Junit测试类,测试保存和查询所有: 在article\src\test\java下新建测试类cn.itcast.article.service.CommentServiceTest

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 package cn.itcast.article.service;import cn.itcast.article.ArticleApplication;import cn.itcast.article.po.Comment;import org.junit.Test;import org.junit.runner.RunWith;import org.springframework.beans.factory.annotation.Autowired;import org.springframework.boot.test.context.SpringBootTest;import org.springframework.data.domain.Page;import org.springframework.test.context.junit4.SpringRunner;import java.time.LocalDateTime;import java.util.List;@RunWith(SpringRunner.class) @SpringBootTest(classes = ArticleApplication.class) public class CommentServiceTest { @Autowired private CommentService commentService; @Test public void testFindCommentList () { List<Comment> commentList = commentService.findCommentList(); System.out.println(commentList); } @Test public void testFindAll () { List<Comment> list = commentService.findCommentList(); System.out.println(list); } @Test public void testFindCommentById () { Comment commentById = commentService.findCommentById("1" ); System.out.println(commentById); } @Test public void testSaveComment () { Comment comment=new Comment (); comment.setArticleid("100000" ); comment.setContent("测试添加的数据" ); comment.setCreatedatetime(LocalDateTime.now()); comment.setUserid("1003" ); comment.setNickname("凯撒大帝" ); comment.setState("1" ); comment.setLikenum(0 ); comment.setReplynum(0 ); commentService.saveComment(comment); } @Test public void testFindCommentListByParentid () { Page<Comment> page = commentService.findCommentListByParentid("3" , 1 , 2 ); System.out.println("----总记录数:" + page.getTotalElements()); System.out.println("----当前页数据:" + page.getContent()); } @Test public void testUpdateCommentLikenum () { commentService.updateCommentLikenum("1" ); } }

添加一条测试数据

根据上级ID查询文章评论的分页列表

插入一条测试数据

1 db.comment.insert([{"parentid":"3","nickname":"张三"}])

MongoTemplate实现评论点赞

十二、MongoDB副本集 MongoDB独立模式可以简单且快速的构建MongoDB数据库系统,然而独立模式存在弊端,即一旦MongoDB发生宕机,将会面临数据丢失的风险,这在生产环境中是不允许发生的,此时我们可以利用MongoDB提供的高可用机制,即复制。MongoDB支持两种复制类型:传统的主/从复制和副本集,副本集可以理解为传统主/从复制的一种复杂形式,支持自动故障恢复功能,拥有更高的可用性,是MongoDB部署中的一种推荐方法 。

副本集概述 副本集(Replica Set)是一组MongoDB实例保持其相同数据集的集群,由一个主(Primary )服务器和多个副本(Secondary )服务器构成。通过复制(Replication )将数据的更新由主服务器推送到其它副本服务器上 ,在一定的延迟之后,达到每个MongoDB实例维护相同的数据集副本。副本集通过维护冗余的数据库副本 、读写分离 和故障自动转移 的功能,摆脱数据库在使用过程中出现的环境故障影响,是所有生产环境部署的基础。

数据的冗余 :副本集可以确保副本节点与主节点数据的自动异步同步,以防止单个数据库服务宕机造成数据丢失的问题。这些副本节点可以和主节点位于同一数据中心或出于安全考虑分布于其它数据中心。自动故障转移 :副本集没有固定的主节点,整个集群会选举出一个主节点,当这个主节点不能正常工作时,会选举出一个副本节点切换为主节点,客户端会连接到这个新的主节点,并且数据和应用程序都将保持可用。MongoDB副本集实现这样的主/副本切换是自动的,因此副本集是保证MongoDB高可用的基础。读写分离 :副本集可以将读取请求分流到所有副本上,以减轻主节点的读写压力。

副本集成员 副本集有三个主要成员主节点(Primary)、副本节点(Secondary)、仲裁节点(Arbiter)。

主节点 ——主节点是副本集中负责处理客户端请求和读写数据主要成员。主节点通过oplog(操作日志)记录所有操作。副本集中有且只有一个主节点 ,如果当前主节点不可用,则会从副本节点中选举出新的主节点 。

副本节点 ——副本节点定期轮询主节点获取oplog记录的操作内容,然后对自己的数据副本执行这些操作,从而保证副本节点的数据副本与主节点保持一致 。副本集中可以有一个或多个副本节点。当主节点宕机时,副本集会根据优先级选举出新的主节点。

仲裁节点 ——仲裁节点不会同步 主节点的数据副本,也不会被选举 为主节点,它主要是参与选举投票 。仲裁节点需要的资源很小。当副本集中成员个数为偶数时,建议添加一个仲裁节点,防止选举新的主节点过程中出现票数一致,导致无法选举出新的主节点。

副本集成员架构 客户端程序(Client Application)通过驱动器(Driver)连接副本集主节点(Primary)进行读写操作,当主节点数据副本发生变化,此时副本节点(Secondary)通过Replication(复制)同步主节点的数据副本,使副本集中副本节点与主节点存储相同数据副本。

副本集中的各节点还会通过传递心跳信息(Heartbeat)来检测各自的健康状态。当主节点故障时,拥有投票权的副本节点和仲裁节点(Arbiter)会触发一次新的选举操作,并从副本节点中选举出新的主节点,以确保副本集正常运行 。

部署副本集 推荐方案 通过三台虚拟机部署官方推荐方案的副本集,该副本集包含一个主节点和两个副本节点,三台虚拟机的创建可参考本书资源中提供的环境配置文档,副本集各服务器的基本信息及角色分配如下表。

虚拟机名称 IP****地址 成员角色 主机名

NoSQL_01

192.168.24.14

主节点

nosql01

NoSQL_02

192.168.24.15

副本节点

nosql02

NoSQL_03

192.168.24.16

副本节点

nosql03

为了降低资源分配,这里仅使用一台服务器,但是分配3个端口(27017、27018、27019)来分别实现主节点、副本节点、和仲裁节点的功能。

1.创建主节点 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 mkdir -p /opt/module/mongodb/shihanshuo_replica_sets/shihanshuors_27017/logs \ & mkdir -p /opt/module/mongodb/shihanshuo_replica_sets/shihanshuors_27017/data/db vi /opt/module/mongodb/shihanshuo_replica_sets/shihanshuors_27017/mongod.conf systemLog: destination: file path: "/opt/module/mongodb/shihanshuo_replica_sets/shihanshuors_27017/logs/mongologs.log" logAppend: true storage: dbPath: "/opt/module/mongodb/shihanshuo_replica_sets/shihanshuors_27017/data/db" journal: enabled: true processManagement: fork: true pidFilePath: "/opt/module/mongodb/shihanshuo_replica_sets/shihanshuors_27017/logs/mongod.pid" net: bindIp: localhost,192.168.24.105 port: 27017 replication: replSetName: shihanshuors mongod -f /opt/module/mongodb/shihanshuo_replica_sets/shihanshuors_27017/mongod.conf

2.创建副本节点 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 mkdir -p /opt/module/mongodb/shihanshuo_replica_sets/shihanshuors_27018/logs \ & mkdir -p /opt/module/mongodb/shihanshuo_replica_sets/shihanshuors_27018/data/db vi /opt/module/mongodb/shihanshuo_replica_sets/shihanshuors_27018/mongod.conf systemLog: destination: file path: "/opt/module/mongodb/shihanshuo_replica_sets/shihanshuors_27018/logs/mongologs.log" logAppend: true storage: dbPath: "/opt/module/mongodb/shihanshuo_replica_sets/shihanshuors_27018/data/db" journal: enabled: true processManagement: fork: true pidFilePath: "/opt/module/mongodb/shihanshuo_replica_sets/shihanshuors_27018/logs/mongod.pid" net: bindIp: localhost,192.168.24.105 port: 27018 replication: replSetName: shihanshuors mongod -f /opt/module/mongodb/shihanshuo_replica_sets/shihanshuors_27018/mongod.conf

3.创建仲裁节点 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 mkdir -p /opt/module/mongodb/shihanshuo_replica_sets/shihanshuors_27019/logs \ & mkdir -p /opt/module/mongodb/shihanshuo_replica_sets/shihanshuors_27019/data/db vi /opt/module/mongodb/shihanshuo_replica_sets/shihanshuors_27019/mongod.conf systemLog: destination: file path: "/opt/module/mongodb/shihanshuo_replica_sets/shihanshuors_27019/logs/mongologs.log" logAppend: true storage: dbPath: "/opt/module/mongodb/shihanshuo_replica_sets/shihanshuors_27019/data/db" journal: enabled: true processManagement: fork: true pidFilePath: "/opt/module/mongodb/shihanshuo_replica_sets/shihanshuors_27019/logs/mongod.pid" net: bindIp: localhost,192.168.24.105 port: 27019 replication: replSetName: shihanshuors mongod -f /opt/module/mongodb/shihanshuo_replica_sets/shihanshuors_27019/mongod.conf

4.启动服务 执行 ps -ef|grep mongod 查看端口是否已启动服务

5.初始化配置副本集和主节点 使用客户端命令连接任意一个节点,但这里尽量要连接主节点(27017节点):

由于之前已经配置过环境变量且当前是在本机中测试,因此可以使用 mongo --port=27017 连接上之后,很多命令无法使用,比如 show dbs 等,必须初始化副本集才行。准备初始化新的副本集:rs.initiate()

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 [root@Server01 ~]# ps -ef | grep mongod root 2454 1 0 20:20 ? 00:00:01 mongod -f /opt/module/mongodb/shihanshuo_replica_sets/shihanshuors_27017/mongod.conf root 2519 1 0 20:21 ? 00:00:01 mongod -f /opt/module/mongodb/shihanshuo_replica_sets/shihanshuors_27018/mongod.conf root 2590 1 6 20:23 ? 00:00:00 mongod -f /opt/module/mongodb/shihanshuo_replica_sets/shihanshuors_27019/mongod.conf root 2645 2338 0 20:23 pts/0 00:00:00 grep --color=auto mongod [root@Server01 ~]# mongo --port=27017 MongoDB shell version v4.4.24 connecting to: mongodb://127.0.0.1:27017/?compressors=disabled&gssapiServiceName=mongodb Implicit session: session { "id" : UUID("aeaf58ca-9271-4d80-9c27-ef91bf1f42ca" ) } MongoDB server version: 4.4.24 --- The server generated these startup warnings when booting: 2023-10-08T20:20:45.692+08:00: Access control is not enabled for the database. Read and write access to data and configuration is unrestricted 2023-10-08T20:20:45.692+08:00: You are running this process as the root user, which is not recommended 2023-10-08T20:20:45.692+08:00: /sys/kernel/mm/transparent_hugepage/enabled is 'always' . We suggest setting it to 'never' 2023-10-08T20:20:45.692+08:00: Soft rlimits too low 2023-10-08T20:20:45.692+08:00: currentValue: 1024 2023-10-08T20:20:45.692+08:00: recommendedMinimum: 64000 --- > show dbs uncaught exception: Error: listDatabases failed:{ "topologyVersion" : { "processId" : ObjectId("65229e9d3d28ff7e81a43fe4" ), "counter" : NumberLong(0) }, "ok" : 0, "errmsg" : "not master and slaveOk=false" , "code" : 13435, "codeName" : "NotPrimaryNoSecondaryOk" } : _getErrorWithCode@src/mongo/shell/utils.js:25:13 Mongo.prototype.getDBs/<@src/mongo/shell/mongo.js:147:19 Mongo.prototype.getDBs@src/mongo/shell/mongo.js:99:12 shellHelper.show@src/mongo/shell/utils.js:937:13 shellHelper@src/mongo/shell/utils.js:819:15 @(shellhelp2):1:1 > rs.initiate { "info2" : "no configuration specified. Using a default configuration for the set" , "me" : "192.168.24.105:27017" , "ok" : 1 } shihanshuors:SECONDARY> shihanshuors:SECONDARY> shihanshuors:PRIMARY> shihanshuors:PRIMARY> show dbs admin 0.000GB config 0.000GB local 0.000GBshihanshuors:PRIMARY>

提示:

6.查看副本集的配置内容 说明 :语法 :

configuration:可选,如果没有配置,则使用默认主节点配置

【示例】

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 shihanshuors:PRIMARY> rs.conf { "_id" : "shihanshuors" , "version" : 1, "term" : 1, "protocolVersion" : NumberLong(1), "writeConcernMajorityJournalDefault" : true , "members" : [ { "_id" : 0, "host" : "192.168.24.105:27017" , "arbiterOnly" : false , "buildIndexes" : true , "hidden" : false , "priority" : 1, "tags" : { }, "slaveDelay" : NumberLong(0), "votes" : 1 } ], "settings" : { "chainingAllowed" : true , "heartbeatIntervalMillis" : 2000, "heartbeatTimeoutSecs" : 10, "electionTimeoutMillis" : 10000, "catchUpTimeoutMillis" : -1, "catchUpTakeoverDelayMillis" : 30000, "getLastErrorModes" : { }, "getLastErrorDefaults" : { "w" : 1, "wtimeout" : 0 }, "replicaSetId" : ObjectId("65229fa43d28ff7e81a43ffc" ) } } shihanshuors:PRIMARY>

说明:

1) “_id” : “shihanshuors” :副本集的配置数据存储的主键值,默认就是副本集的名字

2) “members” :副本集成员数组,此时只有一个: “host” : “192.168.24.105:27017”,该成员不是仲裁节点:”arbiterOnly” : false ,优先级(权重值): “priority” : 1,

3) “settings” :副本集的参数配置。

7.查看副本集状态 检查副本集状态。

说明 :语法 :

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 shihanshuors:PRIMARY> rs.status { "set" : "shihanshuors" , "date" : ISODate("2023-10-08T12:26:22.897Z" ), "myState" : 1, "term" : NumberLong(1), "syncSourceHost" : "" , "syncSourceId" : -1, "heartbeatIntervalMillis" : NumberLong(2000), "majorityVoteCount" : 1, "writeMajorityCount" : 1, "votingMembersCount" : 1, "writableVotingMembersCount" : 1, "optimes" : { "lastCommittedOpTime" : { "ts" : Timestamp(1696767978, 1), "t" : NumberLong(1) }, "lastCommittedWallTime" : ISODate("2023-10-08T12:26:18.962Z" ), "readConcernMajorityOpTime" : { "ts" : Timestamp(1696767978, 1), "t" : NumberLong(1) }, "readConcernMajorityWallTime" : ISODate("2023-10-08T12:26:18.962Z" ), "appliedOpTime" : { "ts" : Timestamp(1696767978, 1), "t" : NumberLong(1) }, "durableOpTime" : { "ts" : Timestamp(1696767978, 1), "t" : NumberLong(1) }, "lastAppliedWallTime" : ISODate("2023-10-08T12:26:18.962Z" ), "lastDurableWallTime" : ISODate("2023-10-08T12:26:18.962Z" ) }, "lastStableRecoveryTimestamp" : Timestamp(1696767958, 1), "electionCandidateMetrics" : { "lastElectionReason" : "electionTimeout" , "lastElectionDate" : ISODate("2023-10-08T12:25:08.924Z" ), "electionTerm" : NumberLong(1), "lastCommittedOpTimeAtElection" : { "ts" : Timestamp(0, 0), "t" : NumberLong(-1) }, "lastSeenOpTimeAtElection" : { "ts" : Timestamp(1696767908, 1), "t" : NumberLong(-1) }, "numVotesNeeded" : 1, "priorityAtElection" : 1, "electionTimeoutMillis" : NumberLong(10000), "newTermStartDate" : ISODate("2023-10-08T12:25:08.951Z" ), "wMajorityWriteAvailabilityDate" : ISODate("2023-10-08T12:25:08.969Z" ) }, "members" : [ { "_id" : 0, "name" : "192.168.24.105:27017" , "health" : 1, "state" : 1, "stateStr" : "PRIMARY" , "uptime" : 337, "optime" : { "ts" : Timestamp(1696767978, 1), "t" : NumberLong(1) }, "optimeDate" : ISODate("2023-10-08T12:26:18Z" ), "lastAppliedWallTime" : ISODate("2023-10-08T12:26:18.962Z" ), "lastDurableWallTime" : ISODate("2023-10-08T12:26:18.962Z" ), "syncSourceHost" : "" , "syncSourceId" : -1, "infoMessage" : "Could not find member to sync from" , "electionTime" : Timestamp(1696767908, 2), "electionDate" : ISODate("2023-10-08T12:25:08Z" ), "configVersion" : 1, "configTerm" : 1, "self" : true , "lastHeartbeatMessage" : "" } ], "ok" : 1, "$clusterTime " : { "clusterTime" : Timestamp(1696767978, 1), "signature" : { "hash" : BinData(0,"AAAAAAAAAAAAAAAAAAAAAAAAAAA=" ), "keyId" : NumberLong(0) } }, "operationTime" : Timestamp(1696767978, 1) }

说明:

8.添加副本从节点 在主节点添加从节点,将其他成员加入到副本集语法 :rs.add(host, arbiterOnly)

【示例】

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 shihanshuors:PRIMARY> rs.add("192.168.24.105:27018" ) { "ok" : 1, "$clusterTime " : { "clusterTime" : Timestamp(1696768126, 1), "signature" : { "hash" : BinData(0,"AAAAAAAAAAAAAAAAAAAAAAAAAAA=" ), "keyId" : NumberLong(0) } }, "operationTime" : Timestamp(1696768126, 1) } shihanshuors:PRIMARY> shihanshuors:PRIMARY> rs.status { "set" : "shihanshuors" , "date" : ISODate("2023-10-08T12:32:15.646Z" ), "myState" : 1, "term" : NumberLong(1), "syncSourceHost" : "" , "syncSourceId" : -1, "heartbeatIntervalMillis" : NumberLong(2000), "majorityVoteCount" : 2, "writeMajorityCount" : 2, "votingMembersCount" : 2, "writableVotingMembersCount" : 2, "optimes" : { "lastCommittedOpTime" : { "ts" : Timestamp(1696768329, 1), "t" : NumberLong(1) }, "lastCommittedWallTime" : ISODate("2023-10-08T12:32:09.024Z" ), "readConcernMajorityOpTime" : { "ts" : Timestamp(1696768329, 1), "t" : NumberLong(1) }, "readConcernMajorityWallTime" : ISODate("2023-10-08T12:32:09.024Z" ), "appliedOpTime" : { "ts" : Timestamp(1696768329, 1), "t" : NumberLong(1) }, "durableOpTime" : { "ts" : Timestamp(1696768329, 1), "t" : NumberLong(1) }, "lastAppliedWallTime" : ISODate("2023-10-08T12:32:09.024Z" ), "lastDurableWallTime" : ISODate("2023-10-08T12:32:09.024Z" ) }, "lastStableRecoveryTimestamp" : Timestamp(1696768319, 1), "electionCandidateMetrics" : { "lastElectionReason" : "electionTimeout" , "lastElectionDate" : ISODate("2023-10-08T12:25:08.924Z" ), "electionTerm" : NumberLong(1), "lastCommittedOpTimeAtElection" : { "ts" : Timestamp(0, 0), "t" : NumberLong(-1) }, "lastSeenOpTimeAtElection" : { "ts" : Timestamp(1696767908, 1), "t" : NumberLong(-1) }, "numVotesNeeded" : 1, "priorityAtElection" : 1, "electionTimeoutMillis" : NumberLong(10000), "newTermStartDate" : ISODate("2023-10-08T12:25:08.951Z" ), "wMajorityWriteAvailabilityDate" : ISODate("2023-10-08T12:25:08.969Z" ) }, "members" : [ { "_id" : 0, "name" : "192.168.24.105:27017" , "health" : 1, "state" : 1, "stateStr" : "PRIMARY" , "uptime" : 690, "optime" : { "ts" : Timestamp(1696768329, 1), "t" : NumberLong(1) }, "optimeDate" : ISODate("2023-10-08T12:32:09Z" ), "lastAppliedWallTime" : ISODate("2023-10-08T12:32:09.024Z" ), "lastDurableWallTime" : ISODate("2023-10-08T12:32:09.024Z" ), "syncSourceHost" : "" , "syncSourceId" : -1, "infoMessage" : "" , "electionTime" : Timestamp(1696767908, 2), "electionDate" : ISODate("2023-10-08T12:25:08Z" ), "configVersion" : 2, "configTerm" : 1, "self" : true , "lastHeartbeatMessage" : "" }, { "_id" : 1, "name" : "192.168.24.105:27018" , "health" : 1, "state" : 2, "stateStr" : "SECONDARY" , "uptime" : 209, "optime" : { "ts" : Timestamp(1696768329, 1), "t" : NumberLong(1) }, "optimeDurable" : { "ts" : Timestamp(1696768329, 1), "t" : NumberLong(1) }, "optimeDate" : ISODate("2023-10-08T12:32:09Z" ), "optimeDurableDate" : ISODate("2023-10-08T12:32:09Z" ), "lastAppliedWallTime" : ISODate("2023-10-08T12:32:09.024Z" ), "lastDurableWallTime" : ISODate("2023-10-08T12:32:09.024Z" ), "lastHeartbeat" : ISODate("2023-10-08T12:32:14.434Z" ), "lastHeartbeatRecv" : ISODate("2023-10-08T12:32:15.611Z" ), "pingMs" : NumberLong(0), "lastHeartbeatMessage" : "" , "syncSourceHost" : "192.168.24.105:27017" , "syncSourceId" : 0, "infoMessage" : "" , "configVersion" : 2, "configTerm" : 1 } ], "ok" : 1, "$clusterTime " : { "clusterTime" : Timestamp(1696768329, 1), "signature" : { "hash" : BinData(0,"AAAAAAAAAAAAAAAAAAAAAAAAAAA=" ), "keyId" : NumberLong(0) } }, "operationTime" : Timestamp(1696768329, 1) } shihanshuors:PRIMARY>

说明:

2) “name” : “192.168.24.105:27018”,是第二个节点的名字,其角色是 “stateStr” : “SECONDARY”

9.添加仲裁从节点 添加一个仲裁节点到副本集语法 :rs.addArb(host)

【示例】

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143 144 145 146 147 148 149 shihanshuors:PRIMARY> rs.addArb("192.168.24.105:27019" ) { "ok" : 1, "$clusterTime " : { "clusterTime" : Timestamp(1696768393, 1), "signature" : { "hash" : BinData(0,"AAAAAAAAAAAAAAAAAAAAAAAAAAA=" ), "keyId" : NumberLong(0) } }, "operationTime" : Timestamp(1696768393, 1) } shihanshuors:PRIMARY> rs.status { "set" : "shihanshuors" , "date" : ISODate("2023-10-08T12:33:17.655Z" ), "myState" : 1, "term" : NumberLong(1), "syncSourceHost" : "" , "syncSourceId" : -1, "heartbeatIntervalMillis" : NumberLong(2000), "majorityVoteCount" : 2, "writeMajorityCount" : 2, "votingMembersCount" : 3, "writableVotingMembersCount" : 2, "optimes" : { "lastCommittedOpTime" : { "ts" : Timestamp(1696768393, 1), "t" : NumberLong(1) }, "lastCommittedWallTime" : ISODate("2023-10-08T12:33:13.643Z" ), "readConcernMajorityOpTime" : { "ts" : Timestamp(1696768393, 1), "t" : NumberLong(1) }, "readConcernMajorityWallTime" : ISODate("2023-10-08T12:33:13.643Z" ), "appliedOpTime" : { "ts" : Timestamp(1696768393, 1), "t" : NumberLong(1) }, "durableOpTime" : { "ts" : Timestamp(1696768393, 1), "t" : NumberLong(1) }, "lastAppliedWallTime" : ISODate("2023-10-08T12:33:13.643Z" ), "lastDurableWallTime" : ISODate("2023-10-08T12:33:13.643Z" ) }, "lastStableRecoveryTimestamp" : Timestamp(1696768379, 1), "electionCandidateMetrics" : { "lastElectionReason" : "electionTimeout" , "lastElectionDate" : ISODate("2023-10-08T12:25:08.924Z" ), "electionTerm" : NumberLong(1), "lastCommittedOpTimeAtElection" : { "ts" : Timestamp(0, 0), "t" : NumberLong(-1) }, "lastSeenOpTimeAtElection" : { "ts" : Timestamp(1696767908, 1), "t" : NumberLong(-1) }, "numVotesNeeded" : 1, "priorityAtElection" : 1, "electionTimeoutMillis" : NumberLong(10000), "newTermStartDate" : ISODate("2023-10-08T12:25:08.951Z" ), "wMajorityWriteAvailabilityDate" : ISODate("2023-10-08T12:25:08.969Z" ) }, "members" : [ { "_id" : 0, "name" : "192.168.24.105:27017" , "health" : 1, "state" : 1, "stateStr" : "PRIMARY" , "uptime" : 752, "optime" : { "ts" : Timestamp(1696768393, 1), "t" : NumberLong(1) }, "optimeDate" : ISODate("2023-10-08T12:33:13Z" ), "lastAppliedWallTime" : ISODate("2023-10-08T12:33:13.643Z" ), "lastDurableWallTime" : ISODate("2023-10-08T12:33:13.643Z" ), "syncSourceHost" : "" , "syncSourceId" : -1, "infoMessage" : "" , "electionTime" : Timestamp(1696767908, 2), "electionDate" : ISODate("2023-10-08T12:25:08Z" ), "configVersion" : 3, "configTerm" : 1, "self" : true , "lastHeartbeatMessage" : "" }, { "_id" : 1, "name" : "192.168.24.105:27018" , "health" : 1, "state" : 2, "stateStr" : "SECONDARY" , "uptime" : 271, "optime" : { "ts" : Timestamp(1696768393, 1), "t" : NumberLong(1) }, "optimeDurable" : { "ts" : Timestamp(1696768393, 1), "t" : NumberLong(1) }, "optimeDate" : ISODate("2023-10-08T12:33:13Z" ), "optimeDurableDate" : ISODate("2023-10-08T12:33:13Z" ), "lastAppliedWallTime" : ISODate("2023-10-08T12:33:13.643Z" ), "lastDurableWallTime" : ISODate("2023-10-08T12:33:13.643Z" ), "lastHeartbeat" : ISODate("2023-10-08T12:33:17.650Z" ), "lastHeartbeatRecv" : ISODate("2023-10-08T12:33:17.654Z" ), "pingMs" : NumberLong(0), "lastHeartbeatMessage" : "" , "syncSourceHost" : "192.168.24.105:27017" , "syncSourceId" : 0, "infoMessage" : "" , "configVersion" : 3, "configTerm" : 1 }, { "_id" : 2, "name" : "192.168.24.105:27019" , "health" : 1, "state" : 7, "stateStr" : "ARBITER" , "uptime" : 4, "lastHeartbeat" : ISODate("2023-10-08T12:33:17.654Z" ), "lastHeartbeatRecv" : ISODate("2023-10-08T12:33:15.670Z" ), "pingMs" : NumberLong(0), "lastHeartbeatMessage" : "" , "syncSourceHost" : "" , "syncSourceId" : -1, "infoMessage" : "" , "configVersion" : 3, "configTerm" : 1 } ], "ok" : 1, "$clusterTime " : { "clusterTime" : Timestamp(1696768393, 1), "signature" : { "hash" : BinData(0,"AAAAAAAAAAAAAAAAAAAAAAAAAAA=" ), "keyId" : NumberLong(0) } }, "operationTime" : Timestamp(1696768393, 1) } shihanshuors:PRIMARY>

说明 :

2) “name” : “192.168.24.105:27019” 是第二个节点的名字,其角色是 “stateStr” : “ARBITER”

10.可使用可视化工具创建连接

Studio 3T版本

副本集操作 副本集的数据读写操作 目标:测试三个不同角色的节点的数据读写情况。

1.登录主节点27017 使用mongo shell 登录主节点27017,写入和读取数据:

1 mongo --host=192.168.24.105 --port=27017

1 2 3 4 5 6 7 8 9 10 11 shihanshuors:PRIMARY> show dbs admin 0.000GB config 0.000GB local 0.000GBshihanshuors:PRIMARY> use articledb switched to db articledb shihanshuors:PRIMARY> db articledb shihanshuors:PRIMARY>db.comment.insert({"articleid" :"100000" ,"content" :"今天天气真好,阳光 明媚" ,"userid" :"1001" ,"nickname" :"Rose" ,"createdatetime" :new Date()}) WriteResult({ "nInserted" : 1 }) shihanshuors:PRIMARY> db.comment.find()

或使用可视化工具打开主节点服务器

插入测试数据

1 db.comment.insert({"articleid":"100000","content":"今天天气真好,阳光明媚","userid":"1001","nickname":"Rose","createdatetime":new Date ()})

2.登录从节点27018: 使用mongo shell 登录从节点,

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 [root@Server01 ~]# mongo --host=192.168.24.105 --port=27018 MongoDB shell version v4.4.24 connecting to: mongodb://192.168.24.105:27018/?compressors=disabled&gssapiServiceName=mongodb Implicit session: session { "id" : UUID("4b677922-4900-45d4-a671-3f5a32659899" ) } MongoDB server version: 4.4.24 --- The server generated these startup warnings when booting: 2023-10-08T20:21:35.751+08:00: Access control is not enabled for the database. Read and write access to data and configuration is unrestricted 2023-10-08T20:21:35.751+08:00: You are running this process as the root user, which is not recommended 2023-10-08T20:21:35.751+08:00: /sys/kernel/mm/transparent_hugepage/enabled is 'always' . We suggest setting it to 'never' 2023-10-08T20:21:35.751+08:00: Soft rlimits too low 2023-10-08T20:21:35.751+08:00: currentValue: 1024 2023-10-08T20:21:35.751+08:00: recommendedMinimum: 64000 --- shihanshuors:SECONDARY> show dbs uncaught exception: Error: listDatabases failed:{ "topologyVersion" : { "processId" : ObjectId("65229ecfc331e179e72265cd" ), "counter" : NumberLong(4) }, "operationTime" : Timestamp(1696769379, 1), "ok" : 0, "errmsg" : "not master and slaveOk=false" , "code" : 13435, "codeName" : "NotPrimaryNoSecondaryOk" , "$clusterTime " : { "clusterTime" : Timestamp(1696769379, 1), "signature" : { "hash" : BinData(0,"AAAAAAAAAAAAAAAAAAAAAAAAAAA=" ), "keyId" : NumberLong(0) } } } : _getErrorWithCode@src/mongo/shell/utils.js:25:13 Mongo.prototype.getDBs/<@src/mongo/shell/mongo.js:147:19 Mongo.prototype.getDBs@src/mongo/shell/mongo.js:99:12 shellHelper.show@src/mongo/shell/utils.js:937:13 shellHelper@src/mongo/shell/utils.js:819:15 @(shellhelp2):1:1 shihanshuors:SECONDARY> rs.slaveOk() WARNING: slaveOk() is deprecated and may be removed in the next major release. Please use secondaryOk() instead. shihanshuors:SECONDARY> show dbs admin 0.000GB articledb 0.000GB config 0.000GB local 0.000GBshihanshuors:SECONDARY> use articledb switched to db articledb shihanshuors:SECONDARY> db.comment.find { "_id" : ObjectId("6241111d951e2161fb8bb4b9" ), "articleid" : "100000" , "content" : "今天天气真好,阳光 明媚" , "userid" : "1001" , "nickname" : "Rose" , "createdatetime" : ISODate("2022-03-28T01:36:29.589Z" ) } shihanshuors:SECONDARY>

发现,不能读取集合的数据。当前从节点只是一个备份,不是奴隶节点,无法读取数据,写当然更不行。

设置读操作权限:说明 :语法 :rs.slaveOk() 或 rs.slaveOk(true)db.getMongo().setSlaveOk() 的简化命令。

现在可实现了读写分离,让主插入数据,让从来读取数据。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 shihanshuors:SECONDARY> rs.slaveOk(false ) WARNING: slaveOk() is deprecated and may be removed in the next major release. Please use secondaryOk() instead. shihanshuors:SECONDARY> db.comment.find() Error: error: { "operationTime" : Timestamp(1648432243, 1), "ok" : 0, "errmsg" : "not master and slaveOk=false" , "code" : 13435, "codeName" : "NotPrimaryNoSecondaryOk" , "$clusterTime " : { "clusterTime" : Timestamp(1648432243, 1), "signature" : { "hash" : BinData(0,"AAAAAAAAAAAAAAAAAAAAAAAAAAA=" ), "keyId" : NumberLong(0) } } } shihanshuors:SECONDARY>

3.登录仲裁者节点27019 仲裁者节点27019,不存放任何业务数据的,可以登录查看,我们发现,arbiter并没有进行数据同步,因为仲裁节点只参与投票,不接收数据

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 [root@localhost ~]# mongo --host=192.168.24.105 --port=27019 MongoDB shell version v4.2.18 connecting to: mongodb://192.168.24.105:27019/? --- shihanshuors:ARBITER> show dbs 2022-03-28T09:52:21.744+0800 E QUERY [js] uncaught exception: Error: listDatabases failed:{ "ok" : 0, "errmsg" : "not master and slaveOk=false" , "code" : 13435, "codeName" : "NotPrimaryNoSecondaryOk" } : _getErrorWithCode@src/mongo/shell/utils.js:25:13 Mongo.prototype.getDBs/<@src/mongo/shell/mongo.js:147:19 Mongo.prototype.getDBs@src/mongo/shell/mongo.js:99:12 shellHelper.show@src/mongo/shell/utils.js:906:13 shellHelper@src/mongo/shell/utils.js:790:15 @(shellhelp2):1:1 shihanshuors:ARBITER> rs.slaveOk() WARNING: slaveOk() is deprecated and may be removed in the next major release. Please use secondaryOk() instead. shihanshuors:ARBITER> use articledb switched to db articledb shihanshuors:ARBITER> db articledb shihanshuors:ARBITER> db.comment.find() Error: error: { "ok" : 0, "errmsg" : "node is not in primary or recovering state" , "code" : 13436, "codeName" : "NotPrimaryOrSecondary" } shihanshuors:ARBITER>

副本集机制 同步机制 为了保证副本集中各成员中的数据副本一致,副本集的副本节点默认会以主节点作为同步源 进行数据同步。

MongoDB使用两种形式完成数据同步过程,分别是完整同步 和变化同步 。

在副本集新增成员 情况下,采用完整同步 方式同步数据副本。

新增成员选择副本集中的主节点作为同步源。

扫描源数据库中的每个集合,并将这些集合中的所有文档插入本地,此过程比较耗时。

通过主节点的oplog重建本地oplog。

完成初始化同步,成为副本节点。

在副本集主节点中数据副本发生变化的情况下,采用变化同步 方式同步数据副本。

副本集主节点数据副本发生变化时,oplog会记录变化内容。

副本节点获取主节点oplog记录变化内容并执行相关操作。

副本节点根据主节点oplog重建本地oplog。

选举机制 如果副本集的主节点在使用过程中发生故障导致无法使用,则其它拥有投票权的成员便会通过选举机制从副本集所有符合选举条件的成员中选出新的主节点。选举的过程可以由任意的非主节点成员发起 ,然后根据优先级和Bully算法(评判谁的数据最新)选举出主节点。在选举出主节点之前,整个集群服务是只读的 ,不能执行写入操作。非仲裁节点都有一个优先级的配置,范围为0~100, 值越大,则越优先成为主节点。默认情况下,优先级是1;如果优先级是0,则不能成为主节点。

1.主节点的选举原则 MongoDB在副本集中,会自动进行主节点的选举,主节点选举的触发条件 :

1) 主节点故障

2) 主节点网络不可达(默认心跳信息为10秒)

3) 人工干预(rs.stepDown(600))

一旦触发选举,就要根据一定规则来选主节点。选举规则是根据票数来决定谁获胜:

1) 票数最高,且获得了“大多数 ”成员的投票支持的节点获胜。“大多数”的定义为:假设复制集内投票成员数量为N,则大多数为 N/2 + 1 。例如:3个投票成员,则大多数的值是2。当复制集内存活成员数量不足大多数时,整个复制集将无法选举出Primary,复制集将无法提供写服务,处于只读状态。

2) 若票数相同,且都获得了“大多数”成员的投票支持的,数据新的节点获胜 。数据的新旧是通过操作日志oplog来对比的。

在获得票数的时候,优先级(priority)参数影响重大。

可以通过设置优先级(priority)来设置额外票数。优先级即权重,取值为0-1000,相当于可额外增加0-1000的票数,优先级的值越大,就越可能获得多数成员的投票(votes)数。指定较高的值可使成员更有资格成为主要成员,更低的值可使成员更不符合条件。

默认情况下,优先级的值是1。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 [root@Server01 mongodb]# mongo --host=192.168.24.105 --port=27017 MongoDB shell version v4.4.24 connecting to: mongodb://192.168.24.105:27017/?compressors=disabled&gssapiServiceName=mongodb Implicit session: session { "id" : UUID("ce47fbae-a157-442f-99f5-354b4e076b84" ) } MongoDB server version: 4.4.24 --- The server generated these startup warnings when booting: 2023-10-14T19:40:26.611+08:00: Access control is not enabled for the database. Read and write access to data and configuration is unrestricted 2023-10-14T19:40:26.611+08:00: You are running this process as the root user, which is not recommended 2023-10-14T19:40:26.611+08:00: /sys/kernel/mm/transparent_hugepage/enabled is 'always' . We suggest setting it to 'never' 2023-10-14T19:40:26.611+08:00: Soft rlimits too low 2023-10-14T19:40:26.611+08:00: currentValue: 1024 2023-10-14T19:40:26.611+08:00: recommendedMinimum: 64000 2023-10-14T19:40:26.645+08:00: 2023-10-14T19:40:26.645+08:00: ** WARNING: This replica set has a Primary-Secondary-Arbiter architecture, but readConcern:majority is enabled 2023-10-14T19:40:26.645+08:00: ** for this node. This is not a recommended configuration. Please see 2023-10-14T19:40:26.645+08:00: ** https://dochub.mongodb.org/core/psa-disable-rc-majority 2023-10-14T19:40:26.645+08:00: --- shihanshuors:PRIMARY> shihanshuors:PRIMARY> shihanshuors:PRIMARY> shihanshuors:PRIMARY> shihanshuors:PRIMARY> rs.conf { "_id" : "shihanshuors" , "version" : 3, "term" : 2, "protocolVersion" : NumberLong(1), "writeConcernMajorityJournalDefault" : true , "members" : [ { "_id" : 0, "host" : "192.168.24.105:27017" , "arbiterOnly" : false , "buildIndexes" : true , "hidden" : false , "priority" : 1, "tags" : { }, "slaveDelay" : NumberLong(0), "votes" : 1 }, { "_id" : 1, "host" : "192.168.24.105:27018" , "arbiterOnly" : false , "buildIndexes" : true , "hidden" : false , "priority" : 1, "tags" : { }, "slaveDelay" : NumberLong(0), "votes" : 1 }, { "_id" : 2, "host" : "192.168.24.105:27019" , "arbiterOnly" : true , "buildIndexes" : true , "hidden" : false , "priority" : 0, "tags" : { }, "slaveDelay" : NumberLong(0), "votes" : 1 } ], "settings" : { "chainingAllowed" : true , "heartbeatIntervalMillis" : 2000, "heartbeatTimeoutSecs" : 10, "electionTimeoutMillis" : 10000, "catchUpTimeoutMillis" : -1, "catchUpTakeoverDelayMillis" : 30000, "getLastErrorModes" : { }, "getLastErrorDefaults" : { "w" : 1, "wtimeout" : 0 }, "replicaSetId" : ObjectId("65229fa43d28ff7e81a43ffc" ) } } shihanshuors:PRIMARY>

可以看出,主节点和副本节点的优先级各为1,即,默认可以认为都已经有了一票。但选举节点,优先级是0,(要注意是,官方说了,选举节点的优先级必须是0,不能是别的值。即不具备选举权,但具有投票权)

故障测试 1.副本节点故障测试 关闭27018副本节点:发现,主节点和仲裁节点对27018的心跳失败。因为主节点还在,因此,没有触发投票选举。如果此时,在主节点写入数据。

1)关闭副本节点27018

1 2 3 4 5 6 [root@Server01 ~]# mongod -f /opt/module/mongodb/shihanshuo_replica_sets/shihanshuors_27018/mongod.conf --shutdown killing process with pid: 2677 [root@Server01 ~]# ps -ef | grep mongod root 2604 1 0 19:40 ? 00:00:13 mongod -f /opt/module/mongodb/shihanshuo_replica_sets/shihanshuors_27017/mongod.conf root 2752 1 0 19:40 ? 00:00:09 mongod -f /opt/module/mongodb/shihanshuo_replica_sets/shihanshuors_27019/mongod.conf root 3455 2308 0 20:15 pts/0 00:00:00 grep --color=auto mongod

2)登入主节点27017,执行 use articledb 切换后执行 db.comment.find() 查看当且数据,最后插入一条新的数据

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 shihanshuors:PRIMARY> show dbs admin 0.000GB articledb 0.000GB config 0.000GB local 0.000GBshihanshuors:PRIMARY> use articledb switched to db articledb shihanshuors:PRIMARY> db articledb shihanshuors:PRIMARY> db.comment.find { "_id" : "7" , "articleid" : "100001" , "content" : "吃饭前,先喝杯水或一碗汤,可减少饭量,对控制体重有帮助" , "userid" : "1007" , "nickname" : "玛丽莲•梦露" , "age" : "18" , "phone" : " 13937165554" , "createdatetime" : ISODate("2023-10-08T12:46:31.423Z" ), "likenum" : "8888" , "state" : "null" } shihanshuors:PRIMARY> db.comment.insert({ "_id" : "1" , "articleid" : "100001" , "content" : "我们不应该把清晨浪费在手机上,健康很重要,一杯温水幸福你我他。" , "userid" : "1002" , "nickname" : "相忘于江湖" , "createdatetime" : ISODate("2022-03-28T10:08:15.522Z" ), "likenum" : 1000, "state" : "1" }) WriteResult({ "nInserted" : 1 }) shihanshuors:PRIMARY> db.comment.find { "_id" : "7" , "articleid" : "100001" , "content" : "吃饭前,先喝杯水或一碗汤,可减少饭量,对控制体重有帮助" , "userid" : "1007" , "nickname" : "玛丽莲•梦露" , "age" : "18" , "phone" : " 13937165554" , "createdatetime" : ISODate("2023-10-08T12:46:31.423Z" ), "likenum" : "8888" , "state" : "null" } { "_id" : "1" , "articleid" : "100001" , "content" : "我们不应该把清晨浪费在手机上,健康很重要,一杯温水幸福你我他。" , "userid" : "1002" , "nickname" : "相忘于江湖" , "createdatetime" : ISODate("2022-03-28T10:08:15.522Z" ), "likenum" : 1000, "state" : "1" } shihanshuors:PRIMARY>

3)再启动从节点,会发现,主节点写入的数据,会自动同步给从节点。