利用Python进行数据分析

第1章 数据分析简介

1.1 数据分析

当今世界对信息技术的依赖程度日渐加深,每天都会产生和存储海量的数据。数据的来源多种多样-自动检测系统、传感器和科学仪器等。不知你有没有意识到,你每次从银行取钱、买东西、写博客、发微博也会产生新的数据。

什么是数据呢?数据实际上不同于信息,至少在形式上不同。对于没有任何形式可言的字节流,除了其数量、用词和发送的时间外,其他一无所知,一眼看上去,很难理解其本质。信息实际上是对数据集进行处理,从中提炼出可用于其他场合的结论,即它是处理数据后得到的结果。从原始数据中抽取信息的这个过程叫作数据分析。

数据分析的目的正是抽取不易推断的信息,而一旦理解了这些信息,就能对产生数据的系统的运行机制进行研究,从而对系统可能的响应和演变做出预测。

数据分析最初用作数据保护,现已发展成为数据建模的方法论,从而完成了到一门真正学科的蜕变。模型实际上是指将所研究的系统转化为数学形式。一旦建立数学或逻辑模型,对系统的响应能做出不同精度的预测,就可以预测在给定输入的情况下,系统会给出怎样的输出。这样看来,数据分析的目标不止于建模,更重要的是其预测能力。

模型的预测能力不仅取决于建模技术的质量,还取决于选择构建整个数据分析工作流所需的优质数据集的能力。因此数据搜寻、数据提取和数据准备等预处理工作也属于数据分析的范畴,它们对最终结果有重要影响。

前面一直在讲数据、数据的准备及数据处理。在数据分析的各个阶段,还有各种各样的数据可视化方法。无论是孤立地看数据,还是将其放到整个数据集来看,理解数据的最好方法莫过于将其绘制成可视化图形,从而传达出数字中蕴含(或隐藏)的信息。到目前为止,已经有很多可视化模式:类型多样的图表。

数据分析的产出为模型和图形化展示,据此可预测所研究系统的响应。随后进入测试阶段,用已知输出结果的一个数据集对模型进行测试。这些数据不是用来定义模型,而是用来检验系统能否重现实际观察到的输出,从而掌握模型的误差,了解其有效性和局限。

拿新模型的测试结果与既有模型进行对比便可知优劣。如果新模型胜出,即可进行数据分析的最后一步:部署。部署阶段需要根据模型给出的预测结果,实现相应的决策,同时还要防范模型预测到的潜在风险。

很多工作都离不开数据分析。了解数据分析及实际操作方法,对工作中做出可靠决策大有裨益。有了它,人们可以检验假说,加深对系统的理解。

1.2 数据分析师的知识范畴

数据分析学科研究的问题面很广。数据分析过程要用到多种工具和方法,它们对计算、数学和统计思维要求较高。

因此,一名优秀的数据分析师必须具备多个学科的知识和实际应用能力。这些学科中有的是数据分析方法的基础,熟练掌握它们很有必要。根据应用领域、研究项目的不同,数据分析师可能还需要掌握其他相关学科的知识。总的来说,这些知识可以帮助分析师更好地理解研究对象以及需要什么样的数据。

通常,对于大的数据分析项目,最好组建一个由各个相关领域的专家组成的团队,他们要能在各自擅长的领域发挥出最大作用。对于小点的项目,一名优秀的分析师就能胜任,但是他必须善于识别数据分析过程中遇到的问题,知道解决问题需要哪些学科的知识和技能,并能及时学习这些学科,有时甚至需要向相关领域的专家请教。简言之,分析师不仅要知道怎么搜寻数据,更应该懂得怎么寻找处理数据的方法。

1.2.1 计算机科学

不论从事什么领域的数据分析工作,掌握计算机科学知识对分析师来说都是最基本的要求。只有具备良好的计算机科学知识及实际应用经验,才能熟练掌握数据分析必备工具。实际上,数据分析的各个步骤都离不开计算机技术,比如用于计算的软件(IDL、MATLAB等)和编程语言(C++、Java、Python等)。

要高效地处理随信息技术迅猛发展而产生的海量数据,就必须使用特定技能。数据研究和抽取,要求分析师掌握各种常见格式的处理技巧。数据通常以某种结构组织在一起,存储于文件或数据库表中,格式多样。常见的数据存储格式有XML、JSON、XLS、CSV等。很多应用都能处理这些格式的数据文件。从数据库中获取数据要稍微麻烦些,需要掌握SQL数据库查询语言,或使用专门为从某种数据库抽取数据而开发的软件。

此外,一些特定类型的数据研究任务中,分析师所能拿到的不是立刻就能用的干净数据,而是文本文件(文档、日志)或网页。需要的数据则来自这些文件中的图表、测量值、访客量或者HTML表格,而解析文件、抽取数据(数据抓取)需要专业知识。

因此,学习信息技术知识很有必要,只有这样才能掌握在当代计算机科学基础上发展起来

的各种工具,比如软件和编程语言。数据分析和可视化离不开它们。

本书尽可能全面地介绍用Python编程语言及专业的库进行数据分析所需的全部知识。针对数据分析的各个阶段,从数据研究、数据挖掘到预测模型研究结果的部署,Python都有专门的库。

1.2.2 数学和统计学

数据分析涉及大量数学知识,本书全篇都少不了它们的身影。数据处理和分析过程涉及的数学知识可能会很复杂。因此具备扎实的数学功底显得尤为重要,至少要能理解正在做的事。熟悉常用的统计学概念也很有必要,因为所有对数据进行的分析和解释都以这些概念为基础。如果说计算机科学提供的是数据分析工具,那么统计学提供的就是基础概念。

统计学为分析师提供了很多工具和方法,全部掌握它们需要多年的磨练。数据分析领域最常用到的统计技术有:

- 贝叶斯方法

- 回归

- 聚类

用到这些方法时,会发现其中数学和统计学知识紧密结合,且对两者都有很高的要求。但是借助本书所讲述的Python库,读者将能驾驭它们。

1.2.3 机器学习和人工智能

数据分析领域最先进的工具之一就是机器学习方法。实际上,尽管数据可视化以及聚类和回归等技术对分析师发现有价值的信息有很大帮助,但在数据分析过程中,分析师经常需要查询数据集中的各种模式,这些步骤专业性很强。

机器学习这门学科所研究的正是如何把一系列步骤和算法结合起来,分析数据,识别数据中存在的模式,找出不同的簇,发现趋势,从数据中抽取有用信息用于数据分析,并实现整个过程的自动化。

机器学习日渐成为数据分析的基础工具,因此了解它(至少也要知道个大概)对数据分析工作的重要性不言而喻。

1.2.4 数据来源领域

数据来源领域(生物、物理、金融、材料试验和人口统计等)的知识也是非常重要的一块。实际上,分析师虽然受过统计学的专业训练,但也必须深入应用领域,记录原始数据,以便更好地理解数据生成过程。此外,数据不仅仅是干巴巴的字符串或数字,还是实际观测参数的表达式,更确切地说是其度量值。因此,对数据来源领域有深入的理解,能提升解释数据的能力。当然,即使是对乐意学习的分析师来说,学习特定领域的知识也是要下一番功夫的。因此最好能找到相关领域的专家,以便有问题时及时咨询。

1.3 理解数据的性质

数据分析所研究的对象自然是数据。在数据分析的各个阶段,数据都是主要关注对象。要分析、处理的原材料由数据构成。经过处理、分析数据后,最终可能会从中得到有用的信息。这些信息能增加对研究对象,也就是产生原始数据的系统理解。

1.3.1 数据到信息的转变

数据是对世界万物的记录。任何可以被测量或分类的事物都能用数据来表示。采集完数据后,可以对其进行研究和分析,以理解事物的性质。人们也常常借助它们进行预测,或者即使做不到预测,至少也能让推测更有根据。

1.3.2 信息到知识的转变

当信息转化为一组有助于更好地理解特定机制的规则时,信息便转化为了知识,因而可以用这些知识预测事件的演变。

1.3.3 数据的类型

数据可以分为两类:

类别型(定类和定序)

数值型(离散和连续)

类别型数据指可以被分成不同组或类别的值或观察结果。类别型数据有两种:**定类(nominal)和定序(ordinal)**。定类型变量的各类别没有内在的顺序,而定序型变量有预先指定的顺序。

数值型数据指通过测量得到的数值或观察结果。数值型数据有两种:离散型和连续型。离散值的个数是可数的,每个值都与其他值区别开来。相反,连续值产生于结果属于某一确定范围的测量或观察。

1.4 数据分析过程

数据分析过程可以用以下几步来描述:转换和处理原始数据,以可视化方式呈现数据,建模做预测。因此,数据分析无外乎由几步组成,其中每一步所起的作用对后面几步而言都至关重要。因此数据分析几乎可以概括为由以下几个阶段组成的过程链:

- 问题定义

- 数据抽取

- 数据准备—–数据清洗

- 数据准备—–数据转换

- 数据探索和可视化

- 预测建模

- 模型验证/测试

- 部署—–结果可视化和阐释

- 部署—–解决方案部署

图1-1为数据分析各步骤的示意图。

图1-1 数据分析过程

1.4.1 问题定义

采集原始数据前,数据分析过程实际上早已开始。实际上,数据分析总是始于要解决的问题,而这个问题需要事先定义。

只有深入探究作为研究对象的系统之后,才有可能准确定义问题:这个系统可能是一种机制、应用或是一般意义上的过程。通常研究工作是为了更好地理解系统的运行方法,尤其是为了理解其运行规则,因为这些规则有助于预测或选择(在知情的基础上进行选择)。

问题定义这一步及产生的相关文档(可交付成果),无论是对于科研还是商业问题都很重要,因为这两项能严格保证分析过程是朝着目标结果前进的。实际上,对系统进行全面或详尽的研究有时会很复杂,一开始可能没有足够的信息。因此问题的定义,尤其是问题的规划,将唯一决定整个数据分析项目所遵循的指导方针。

定义好问题并形成文档后,接下来就可以进入数据分析的项目规划环节。该环节要弄清楚高效完成数据分析项目需要哪些专业人士和资源。因此就得考虑解决方案相关领域的一些事项。你需要寻找各个领域的专家,安装数据分析软件。

因此,在项目规划过程中,应组建起高效的数据分析团队。通常这个团队应该是跨学科的,因为从不同角度研究数据有助于解决问题。因此,一个优秀的团队必然是成功完成数据分析工作

的关键因素之一。

1.4.2 数据抽取

问题定义步骤完成之后,在分析数据前,首先要做的就是获取数据。数据的选取一定要本着创建预测模型的目的,数据选取对数据分析的成功起着至关重要的作用。所采集的样本数据必须尽可能多地反映实际情况,也就是能描述系统对来自现实刺激的反应。实际上,如果原始数据采集不当,即使数据量很大,这些数据描述的情境往往也是与现实相左或存在偏差。

因此,如果对选取不当的数据,或是对不能很好地代表系统的数据集进行数据分析,得到的模型将会偏离作为研究对象的系统。

数据的查找和检索往往要凭借一种直觉,超乎单纯的技术研究和数据抽取。该过程还要求对数据的内在特点和形式有细致入微的理解,而只有对问题的来源领域有丰富的经验和知识,才能做到这一点。

除了所需数据的质量和数量,另一个问题是使用最佳的数据源。

如果工作室环境为(技术或科学)实验室,数据源生成的数据是用来做实验的。这种情况下就很容易鉴别数据源的优劣,这时唯一要注意的就是实验过程的设置。

无论是对于哪个领域的应用,都不可能采用严格的实验方法来重建数据源所属的系统。很多领域的应用需要从周边环境搜寻数据,往往依赖外部实验数据,甚至常通过采访或调查来收集数据。这种情况下,寻找包含数据分析所需全部信息的优质数据源难度很大。这时往往需要从多种数据源搜集信息,以弥补缺陷,识别矛盾之处,使数据集尽可能具有普遍性。

当你想找些数据来用时,Web是个不错的起点。但Web中的大多数数据获取起来具有一定难度。实际上,不是所有的数据都是以文件或是数据库形式存在的,有些数据以这样或那样的格式存在于HTML页面中;有的内容很明确,有的则不然。为了获取网页中的内容,人们研究出了Web抓取(Web scraping)方法,通过识别网页中特定的HTML标签采集数据。有些软件就是专门用来抓取网页的。它们找到符合条件的标签,从中抽取目标数据。查找、抽取完成后,就得到了用于数据分析的数据。

1.4.3 数据准备

在数据分析的所有步骤中,数据准备虽然看上去不太可能出问题,但实际上,这一步需要投入更多的资源和时间才能完成。数据往往来自不同的数据源,有着不同的表现形式和格式。因此,在分析数据之前,所有这些数据都要处理成可用的形式。

数据准备阶段关注的是数据获取、清洗和规范化处理,以及把数据转换为优化过的,也就是准备好的形式,通常为表格形式,以便使用在规划阶段就定好的分析方法处理这些数据。

数据中存在的很多问题都必须解决,比如存在无效的、模棱两可的数据,值缺失,字段重复以及有些数据超出范围等。

1.4.4 数据探索和可视化

探索数据本质上是指从图形或统计数字中搜寻数据,以发现数据中的模式、联系和关系。数据可视化是突出显示可能的模式的最佳工具。

近年来,数据可视化发展迅猛,已成为一门真正的学科。实际上,专门用来呈现数据的技术有很多,从数据集中抽取最佳信息的可视化技术也不少。

数据探索包括初步检验数据,这对于理解采集到的数据的类型和含义很重要。再结合问题定义阶段所获得的信息,确定数据类型,这决定着选用哪种数据分析方法定义模型最合适。

通常,在这个阶段,除了细致研究用数据可视化方法得到的图表外,可能还包括以下一种或多种活动:

- 总结数据

- 为数据分组

- 探索不同属性之间的关系

- 识别模式和趋势

- 建立回归模型

- 建立分类模型

通常来讲,数据分析需要总结与研究数据相关的各种表述。总结(summarization)过程,在不损失重要信息的情况下,将数据浓缩为对系统的解释。

聚类这种数据分析方法用来找出由共同的属性所组成的组(grouping,分组)。

数据分析的另外一个重要步骤关注的是识别(identification)数据中的关系、趋势和异常现象。为了找到这些信息,需要使用合适的工具,同时还要分析可视化后得到的图像。

其他数据挖掘方法,比如决策树和关联规则挖掘,则是自动从数据中抽取重要的事实或规则。这些方法可以和数据可视化配合使用,以便发现数据之间存在的各种关系。

1.4.5 预测建模

数据分析的预测建模阶段,则要创建或选择合适的统计模型来预测某个结果的概率。

探索完数据后,就掌握了用来开发数学模型,为数据中所存在的关系编码的全部信息。这些模型有助于我们理解作为研究对象的系统。具体而言,模型主要有以下两个方面的用途:一是预测系统所产生的数据的值,使用回归模型;二是将新数据分类,使用分类模型或聚类模型。实际上,根据输出结果的类型,模型可分为以下3种。

- 分类模型:模型输出结果为类别型。

- 回归模型:模型输出结果为数值型。

- 聚类模型:模型输出结果为描述型。

生成这些模型的简单方法包括线性回归、逻辑回归、分类、回归树和 K-近邻算法。但是分析方法有多种,且每一种都有自己的特点,擅长处理和分析特定类型的数据。每一种方法都能生成一种特定的模型,选取哪种方法跟模型的自身特点有关。

有些模型输出的预测值与系统实际表现一致,这些模型的结构使得它们能以一种简洁清晰的方式解释我们所研究的系统的某些特点。另外一些模型也能给出正确的预测值,但是它们的结构为“黑箱”,对系统特点的解释能力有限。

1.4.6 模型验证

模型验证阶段也就是测试阶段,对数据分析很重要。在该阶段,会验证用先前采集的数据创建的模型是否有效。该阶段之所以重要,是因为直接与真实系统数据比较,可评估模型所生成的数据的有效性。但其实该阶段是从整个数据分析过程所使用的初始数据集中取一部分用于验证。

通常用于建模的数据称为训练集,用来验证模型的数据称为验证集。

通过比较模型和实际系统的输出结果,就能评估错误率。使用不同的测试集,就可以得出模型的有效性区间。实际上,预测结果只在一定范围内才有效,或因预测值取值范围而异,预测值和有效性之间存在不同层级的对应关系。

模型验证过程,不仅可以得到模型的确切有效程度(其形式为数值),还可以比较它跟其他模型有什么不同。模型验证技巧有不少,其中最著名的是交叉验证。它的基础操作是把训练集分成不同部分,每一部分轮流作为验证集,同时其余部分用作训练集。通过这种迭代的方式,可以得到最佳模型。

1.4.7 部署

数据分析的最后一步-部署,旨在展示结果,也就是给出数据分析的结论。若应用场景为商业领域,部署过程将分析结果转换为对购买数据分析服务的客户有益的方案。若应用场景为科技领域,则将成果转换为设计方案或科技出版物。也就是说,部署过程基本上就是把数据分析的结果应用于实践。

数据分析或挖掘的结果有多种部署方式。通常,数据分析师会在这个阶段为管理层或是客户撰写报告,从概念上描述数据分析结果。报告应上呈经理,以便他们读后做出相应决策,真正用分析结果指导实践。

数据分析师提交的报告通常应该详细论述以下4点:

- 分析结果

- 决策部署

- 风险分析

- 商业影响评估

如果项目的产出包括生成预测模型,那么这些模型就可以以单独应用的形式进行部署或集成到其他软件中。

1.5 定量和定性数据分析

数据分析过程都是以数据为中心,根据数据的特点,其实还可以进行细分。

如果所分析的数据有着严格的数值型或类别型结构,这种分析称为定量分析;如果数据要用自然语言来描述,则称为定性分析。

由于所处理的对象具有不同的特点,这两种数据分析方法也有所不同。

定量分析所处理的数据具有内在逻辑顺序或者能分成不同的类别。这样,数据就有了不同的结构。顺序、类别和结构可以提供更多信息,从而可以以更加严格的数学形式进一步处理数据。用这种数据产生的模型能做出定量预测,因此分析师也就可以得出更加客观的结论。

而定性分析处理的数据通常没有内在结构,至少结构没那么明显,这些数据既不是数值型也不是类别型。例如,适合定性分析研究的数据包括文本、视频和音频。分析这类数据时,往往需要根据实际情况,开发特殊方法来抽取信息。用这些信息创建的模型能做出定性预测,而数据分析师给出的结论可能还包括主观解释。从另一方面来讲,定性分析可用来探索更加复杂的系统,而且它所能得到的结论,严格的数学方法可能无法给出。定性分析通常用来研究社会现象或复杂结构等测量难度很大的系统。

图1-2展示了这两种分析方法的不同之处。

图1-2 定量分析和定性分析

1.6 开放数据

为了满足日益增长的数据需求,人们把很多数据资源放到了网上。这些被称为开放数据(Open Data)的数据资源向任何有数据需求的人免费开放。

下面是网上的一些开放数据资源站点。更完整、详细的开放数据资源请见附录B。

- DataHub网站

- 世界卫生组织

- Data.gov 网站

- 欧盟开放数据门户

- 亚马逊AWS开放数据集

- Facebook Graph

- Healthdata.gov网站

- 谷歌趋势

- 谷歌金融

- 谷歌图书Ngrams项目

- UCI机器学习数据库

就开放数据而言,可以通过LOD云图了解网上都有哪些开放数据资源可用。从云图中能看到当前网上有哪些开放数据资源,以及这些资源之间的关系(见图1-3)。

图1-3 相互联系的开放数据云图2014,设计者为Max Schmachtenberg、Christian Bizer、Anja Jentzsch和 Richard Cyganiak

1.7 Python和数据分析

本书的主要特点是用Python 语言介绍数据分析的所有概念。Python大量的库为数据分析和处理提供了完整的工具集,因此它广泛应用于科学计算领域。

比起R和MATLAB等主要用于数据分析的编程语言,Python不仅提供数据处理平台,而且还有其他语言和专业应用所没有的特点。Python库一直在增加,算法的实现采用更具创新性的方法,再加上它能跟很多语言(C和 Fortran)相对接,这些特点都使得Python在所有可用于数据分析的语言中与众不同。

进一步来说,Python其实不是专用于数据分析的,它还有很多其他方面的用途。比如它本身是一门通用型编程语言,也可以作脚本来用,还能操作数据库;而且由于Django等框架的问世,Python近些年还用来开发Web应用。因此,使用Python开发的数据分析项目,完全可以跟Web 服务器相兼容,也就可以整合到Web应用中。

因此,对于想从事数据分析的读者,Python以及它众多的包,在可以预见的将来会是最佳选择。

1.8 小结

本章介绍了何为数据分析、它由哪些步骤组成、数据在创建预测模型过程中的作用,以及甄选数据是数据分析结果准确可靠的基础。

下一章将基于Python及其各种库,开始数据分析之旅。

第2章 Python世界简介

Python语言及其周边世界由解释器、工具、编辑器、库和笔记本①等组成。近些年来,Python 世界急速膨胀,日趋丰富,以至于第一次接触它的开发者可能会感觉它很复杂,有点不知所措。初次接触Python编程,面对众多选择,你可能会感到迷失了方向,不知从何处入手。

本章将概述Python世界。首先会介绍Python语言的基本情况及特点。然后介绍从何处入手、什么是解释器,以及如何开始编写第一行 Python代码2。最后将介绍如何用 IPython和 Jupyter Notebook3等工具以更加新颖、高级的交互式形式编写程序。

2.1 Python-编程语言

Python编程语言于1991年由Guido van Rossum®发明,它是从ABC语言发展而来的,其特点可以概括为以下几个词:

- 解释型

- 可移植

- 面向对象

- 交互式

- 胶水(interfaced)

- 开源

- 便于理解和使用

Python是一种解释型语言,它采用的是伪编译方法。编写完程序后,要有解释器才能运行。要解释并运行源代码,机器上需要安装解释器程序。因而跟C、C++和Java等语言不同,Python 程序不需要编译。

Python具有很高的可移植性。用解释器作为接口读取和运行代码的最大优势就是可移植性。

实际上,任何现有系统(Linux、Windows和Mac)安装相应版本的解释器后,Python代码无须修改就能在其上运行。正是由于 Python具有这个特点,包括树莓派和其他微处理器在内的小型设备才都把它选作编程语言。

Python 属于面向对象的语言。可以指定表示对象的类,实现继承关系。但是跟C++和 Java 的区别是,Python没有构造函数或析构函数。在Python中,可以实现特定的结构来管理异常。然而,由于Python的语言结构很灵活,可以用函数式编程、向量式编程等方法来实现面向对象方法所能达到的效果。

Python是一种交互式编程语言。由于Python用解释器执行代码,使用环境不同时,Python 可呈现出极为不同的特点。实际上,可以像编写C++或Java那样,编写大量代码后再运行;或者输入一行命令后就执行,这样马上就能得到执行结果,然后根据返回结果再决定下一行代码写什么。执行代码的模式具有高度交互性,使得Python成为像MATLAB那样非常适合计算的语言。Python之所以在科学计算领域获得成功,跟这个特点密切相关。

Python可以用作胶水,粘合C/C++和 Fortran等编程语言,这也是它的一大优点。实际上,Python可以以此弥补执行速度慢这个缺点-这可能是它的唯一缺点。作为一种动态性极高的编程语言,有时执行Python程序所用的时间是用其他语言编写、编译后的静态程序的100倍。因此要解决这类性能问题,可以在Python语言中无缝使用编译好的其他语言的代码。

Python是一门开源的编程语言。Python语言的参考实现CPython完全免费、开源。此外,每一个模块和库都是开源的,它们的代码可以从网上找到。每个月,庞大的开发者社区都会为Python 带来很多改进,使Python的库更加丰富,提升它们的性能。CPython由成立于2001年的非营利机构Python软件基金会管理。该基金会的宗旨是宣传、保护和推动Python编程语言的发展。

Python还是一门易于学习和使用的语言。这可能是Python最为重要的一个特点,因为这是开发者甚至是新手首先就能感受到的。Python代码很直观,读起来很容易,往往会引发用户的无限感慨①。久而久之,它就成为了大多数编程新手的首选。然而,简单并不代表它的应用范围窄,相反,Python广泛用于各个计算领域。此外,比起C++、Java和Fortran等编程语言,Python处理起各种任务来更简单,远没有其他编程语言那么复杂。

Python-解释器

前面讲过,每次运行python命令,Python解释器就会启动,可看到命令提示符>>>。

Python解释器程序无非是读取和解释输入到提示符后面的代码。前面已经提过,解释器既可以一次只接收单条命令,也可以接收整个Python代码文件。不管哪种情况,解释器的处理机制都相同。

每次按下回车键之后,解释器开始以单词为单位逐一(tokenization,单词化)扫描代码(一行或整个文件的所有代码)。这些单词实则是一个个文本片段,解释器把它们组织成为表示程序逻辑结构的树状结构,随后这些代码片段将会被转化为字节码(.pyc或.pyo)。。生成的字节码随后将交由 Python虚拟机(PVM)执行。解释过程到此结束,请见图2-1。

图2-1 Python解释器解释代码的过程

关于这个过程,有一份文档讲得非常好,详见https://www.ics.uci.edu/~pattis/ICS-31/lectures/tokens.pdf。

Python的标准解释器称作Cython,因为它是完全用C语言编写的。除此之外,还有一些用其他语言编写的解释器,比如用Java开发的Jython、用C#开发的(只适用于Windows 系统)IronPython以及全部用Python开发的PyPy。

1.Cython

Cython项目以开发能把Python代码转换为C代码的编译器为基础。C代码随后在Cython环境中执行。这种编译机制使得在Python代码中嵌入能提升效率的C代码成为可能。Cython可以被视为一门新的编程语言,它的发明实现了两种编程语言的融合。可以从网上找到大量相关文档。建议访问http://docs.cython.org。

2.Jython

跟Cython相对应的,还有完全用Java语言开发和编译的Jython。它是由Jim Hugunin在1997年开发的。Jython是用Java语言实现的Python编程语言。具体而言,它具有以下特点:Python 的扩展和包是用Java类而不是Python模块实现的。

3.PyPy

PyPy解释器是一种即时(just-in-time,JIT)编译器,它在运行时直接把Python代码转化为机器码。这样做是为了提升代码的执行速度,却因此只使用了所有Python命令中的很少一部分。这个只包含少数Python命令的子集被称作RPython。关于PyP的更多信息,请访问其官网。

2.2 Python 2和 Python 3

目前,Python社区仍处于从系列2解释器到系列3解释器的过渡阶段。当前这两个版本(2.7版本和3.6版本)都有人在用。两种版本并存的局面,为用户平添几分疑惑,尤其是不知道应该选用哪个版本,或是弄不清楚两者之间到底有什么差异。也许你会问,既然3.x系列更为高级,那为什么2.x系列仍没有停止发版?

当 Guido van Rossum(Python之父)决定对Python语言做出重大改进时,他很快就发现这些改动会使新的 Python 语言与很多现有代码不兼容。因此,他最终决定创建 Python 新版本-Python 3.0。为了解决兼容性问题,保证已有代码的顺利运行,他还决定维护跟历史代码相兼容

的版本,确切地说,就是2.7版本。

Python 3.0版本于2008年发布,而2.7版本则于2010年发布。Python官方决定在2.7版本之后不再发布大的版本。写作本书时(2014年),Python 3.x系列最新的版本号为3.6.5(2018)。

本书使用 Python 3.x系列。但是,除去极少数情况,使用2.7.x系列(最后的版本是2.7.14,于2017年9月发布)应该也不会有问题。

2.2.1 安装Python

要使用Python开发程序,需要在操作系统中安装它。与Windows不同的是,Linux和Mac OS X系统应该预装了某个版本的Python。如果没有或是想安装新版本,方法也很简单。虽然Python 安装方法因操作系统而异,但是操作起来都很容易。

Debian-Ubuntu Linux系统使用以下命令:

apt-get install python

支持rpm包的Red Hat和Fedora Linux系统则使用以下命令:

yum install python

如果使用的是Windows或Mac OS X操作系统,可以从Python官网下载喜欢的版本,自动进行安装。

除了上述方法,如今有很多发行版不仅提供Python解释器,还提供很多工具,这些工具简化了Python、所有的库以及相关应用的管理和安装工作。建议从网上找一个现成的发行版来用。

2.2.2 Python 发行版

由于Python语言获得了成功,应用面很广,开发者需要的功能也多种多样。为了满足这些需求,人们开发了大量的包。这么多年下来,包的数量已经多到几乎不可能靠人工来管理了。

鉴于此,很多Python发行版应运而生,它们能高效地管理成百上千的Python包。实际上,比起单独下载、安装只包含标准库的解释器,然后用到时再逐个安装所需要的库,直接安装Python 发行版更加简单。

这些发行版的核心是包管理器,该应用也只不过是能自动管理、安装、更新、配置和删除作为发行版一部分的Python包。

包管理器非常有用。用户请求所需要的包时(比如要安装一个包),包管理器通常通过网络分析用户所要安装的包的版本号以及它所依赖的包,如果依赖包不存在的话,会顺便下载。

- Anaconda

Anaconda是Continuum Analytics公司开发的免费的Python包发行版,支持Linux、Windows 和Mac OS X操作系统。它不仅提供Python的最新包,还提供搭建Python开发环境所需的大多数工具。

在系统中安装Anaconda后,就可以使用本章所提到的大多数工具和应用,而无须分别安装和管理它们。它所包含的工具有Spyder IDE、Jupyter QtConsole和 Jupyter Notebook。

整个Anaconda发行版用 conda管理所有的包,维护其版本信息,它是Anaconda的包管理器和环境管理器。

conda install <package name>

该发行版最为有趣的一个特点是,它能管理Python版本的多种开发环境。安装Anaconda后,默认安装的是Python 2.7版本以及为该版本开发的包。但这没关系,因为通过创建独立于2.7版本的新环境,Anaconda允许开发者同时使用Python的其他版本。例如创建基于Python 3.6的新环境。

conda create -n py36 python=3.6 anaconda

以上命令将会创建一个新的Anaconda环境,里面安装的包都指向Python3.6。在新环境安装所需的包,不会对Python 2.7环境造成任何影响。创建新环境后,输入下面命令即可激活:

source activate py36

Windows用户需要输入以下命令:

activate py36

C:\Users\Fabio>activate py36

(py36) C:\Users\Fabio>

可以创建使用不同Python版本的环境,只需要修改conda create命令中python选项的值即可。如要使用默认的Python版本,输入以下命令即可:

source deactivate

Windows用户需要输入以下命令:

(py36) C:\Users\Fabio>deactivate

Deactivating environment “py36”…

C:\Users\Fabio>

- Enthought Canopy

Enthought公司提供的Canopy发行版跟 Anaconda很相似。Enthought公司创立于2001年,其最为知名的是SciPy项目(https://www.enthought.com/products/canopy/)。Canopy 发行版支持Linux、Windows和MacOSX系统,包含大量包、工具和应用,用包管理器进行管理。与conda 不同的是,包管理器Canopy完全是图形化的。

然而这个发行版只有基础版Canopy Express 免费。它除了提供各发行版通常都会提供的包之外,还内置了IPython和Canopy IDE,后者具有其他IDE所没有的特殊功能。嵌入IPython是为了把它的环境用作测试和调试代码的窗口。

- Python(x,y)

Python(x,y)是只支持 Windows 系统的一种免费发行版,下载地址为http://code.google.com/p/pythonxy/。它使用Spyder作为IDE。

2.2.3 使用 Python

Python语言包容万象,却又不失简洁,用起来还很灵活。不论用它从事哪个领域的开发(数据分析、科学计算和图形界面等),扩展起来都很容易。也正是出于这个原因,Python的用法多种多样,具体怎么用取决于开发者的喜好和能力。下面介绍本书用到的Python的各种用法。各章讨论的主题有所不同,因此所用到的Python方法也会存在差异,而原则是为不同的任务选用最合适的方法。

- Python shell

走进Python世界最简单的方式莫过于通过Python shell(运行命令行的终端界面)创建一段会话(session)。一次输入一条命令,即可测试它能否正常运行。这种模式阐明了解释器的特性,Python代码所要执行的操作由解释器来决定。解释器能一次读取一条命令,同时保持先前命令所指定的变量的状态,这一点跟MATLAB和其他计算软件相似。

这种模式非常适合第一次接触Python语言的新手。可以逐条测试命令,无须事先编写、编辑好再来运行可能包含多行代码的完整程序。

这种模式也表明可以逐行对代码进行测试、调试或用来处理计算任务。在终端开启会话模式很简单,只需输入以下命令即可:

1 | >>>python |

现在,Python shell已经激活,解释器严阵以待,等待接收Python命令。下面编写最简单也是编程初学者都要编写的经典例子:

1 | >>>print("Hello World!") |

- 运行完整的Python程序

学习 Python的最好方法是编写一个完整的程序,并在终端运行。首先使用简单的文本编辑器编写程序。以代码清单2-1为例,将它保存为MyFirstProgram.py。

代码清单2-1 MyFirstProgram.py

1 | myname= input("What is your name?") |

这样就编写好第一个Python程序了,可以直接在命令行使用python命令运行它。注意,将包含程序代码的文件名放到python命令的后面。

1 | python myFirstProgram.py |

- 使用IDE编写代码

比前面更为复杂的方法是使用IDE(Integrated Development Environment,集成开发环境)编写并运行代码。这些编辑器相当复杂,提供了Python开发所需的工作环境。它们提供的多种工具为开发者带来很多便利,尤其非常有助于调试程序。接下来几节将详细介绍几款当前主流的IDE。

- 跟Python 交互

即将介绍的最后一种方法-交互式编程,在我看来可能是最有创新性的。前三种方法不论好坏,使用其他语言的开发者都在使用。最后一种方法提供了直接与Python代码交互的机会。

从这个方面讲,IPython的发明极大地丰富了Python世界。功能强大的IPython旨在满足分析师、工程师或研究员等类型的开发者和Python解释器进行交互的需求。稍后会详细介绍IPython 以及它的主要特点。

2.2.4 编写Python代码

上节讲了如何编写简单的小程序输出字符串“Hello World”。下面概述Python语言基础,介绍最重要的基础知识。

本节不讨论如何用Python编写程序,或是讲解Python语法,而是简单介绍Python的基本规则,以便继续后面的各个主题。

如果你已熟悉Python语言,可跳过介绍部分。如果你不熟悉编程,觉得相关主题难以理解,建议从网上查找相关文档、教程或课程进行学习。

- 数学运算

前面讲过print()函数几乎可以输出任何内容。其实,Python不仅是输出工具,也是强大的计算器。在命令行开启一段会话,进行下面的数学运算:

1 | >>>1+2 |

Python能对多种数据进行计算,包括复数和含有布尔值的条件表达式。从上面的计算可以看出,Python解释器直接返回计算结果而不需要使用print()函数输出结果,对于存放在变量中的值也是如此。调用变量,就能看到它里面的内容。

1 | >>>a=12*3.4 |

- 导入新的库和函数

前面讲过,Python的一大特点是通过导入各种包和模块来扩展其功能。导入整个包,需要使用import命令:

1 | >>>import math |

这样,math模块中的所有函数都可以在当前会话中使用,因此可以直接调用它们。新会话所能使用的函数的标准集也得到了扩展。这些函数的调用方式如下:

1 | library_name.function_name() |

例如计算变量a所存放的数值的正弦值:

1 | >>>math.sin(a) |

如上所示,调用函数时需带着库的名字。有时会遇到下面这种形式的导入语句:

1 | >>>from math import * |

即使这样做没有问题,也应该避免。实际上,这种导入语句把库中的所有函数都导入进来,在使用时,不用指定库的名称。

1 | sin(a) |

但这种导入方法实际上会导致非常严重的问题,尤其是在导入的库越来越多时。因为分属于不同库的函数可能存在重名的情况,所以如果把它们都导入进来,后导入的函数将覆盖掉先前导入的同名函数。因此程序可能会产生各种错误,甚至出现反常行为。

实际上,这种导入方法通常只用于以下情况:函数数量非常有限,且程序的正常运行又离不开这些函数,同时又完全没有必要导入整个库。

1 | from math import sin |

- 数据结构

前面的例子曾用变量存储一个元素。实际上,Python提供了多种极其有用的数据结构,它们能同时存储多个元素,有时甚至是不同类型的元素。这些数据结构的定义方法因它们内部所存储的数据的结构而异。

- 列表

- 集合

- 字符串

- 元组

- 字典

- 双队列(deque)

- 堆

这只是可以用Python创建的数据结构中的一小部分。这些数据结构里最常用的是字典和列表。

字典(dictionary)这种数据结构,有时也称作dict,其中每个元素(值)都有一个与之相关联的被称作键(key)的标签。字典中的数据没有内在顺序,而只是一个个键值对。

1 | >>>dict ={'name':'William','age':25,'city':'London'} |

如果想获取字典里的某个值,需要指定它所对应的键的名称。

1 | dict["name"] |

如果想迭代输出字典里的所有键值对,需要使用for-in结构,还要用到items()函数。

1 | >>>for key,value in dict.items(): |

列表(list)这种数据结构包含一系列具有明确顺序的元素,这些元素组成一个序列。它支持新增或删除元素操作。每个元素都有一个叫作索引(index)的数字标识,这个数字也就是该元素在序列中的位次。

1 | >>>list=[1,2,3,4] |

如果想获取单个元素,用方括号指定元素的索引即可(列表第1个元素的索引值为0);如果想获取列表(或序列)的一部分,用索引i和$j ^ { \textcircled { 1 } }$指定所需范围的上下界即可。

1 | >>>list[2] |

用负数作为索引,表示从列表的最后一个元素开始,朝第一个元素的方向获取元素。

1 | >>>limit[-1] |

如要扫描列表的每个元素,可使用for-in结构。

1 | >>items=[1,2,3,4,5] |

- 函数式编程

前面例子的for-in结构跟其他编程语言中的循环非常相似。但实际上,如果你想成为一名真正的Python程序员,就应该避免使用显式循环。Python提供了几种替代方法,指定了诸如函数式编程(functional programming,亦即 expression-oriented programming,面向表达式的编程)等编程技巧。

Python提供的用于函数式编程开发的函数有:

- map(function,list),映射函数

- filter(function,list),过滤函数

- reduce(function,list),规约函数

- lambda 函数

- 列表生成式

前面刚刚讲过的for循环对每个元素执行某一操作,然后把结果汇集起来。其实同样功能可以用map()函数来实现。

1 | >>>items=[1,2,3,4,5] |

上述例子首先定义了对每一个元素进行操作的函数,随后把这个函数作为map()函数的第一个参数传递进来。Python允许使用lambda函数直接在第一个参数中定义函数。这样能大幅精简代码,前面的代码结构就可以被浓缩为一行代码。

1 | >>>list(map((lambda x: x+1),items)) |

其他两个函数filter() 和redue()的工作原理与之类似。filter()的工作原理与之类似。filter()函数只抽取函数返回结果()为True的列表元素。reduce()函数对列表所有元素依次计算后返回唯一结果。使用reduce()前,需要导入functools模块。

1 | >>list(filter((lambda x:x<4),items)) |

这两个函数实现了用for循环所能实现的功能。它们取代了这些循环结构及其功能,因为这两者可以表述为简单的函数调用,而函数式编程正是由这样的函数组成的。

函数式编程的最后一个概念叫作列表生成式(list comprehension),可用来以非常自然和简单的方式创建列表,而这种列表创建方式跟数学家描述数据集所使用的类似。列表这个序列所包含的元素由特定的函数或运算来指定。

1 | >>>5 = [x**2 for x in range(5)] |

- 缩进

对掌握其他编程语言的人来说,Python中缩进(indentation)所起的作用很奇特。你可能习惯了为了美观和增强代码的可读性而调整缩进,但是对Python而言,缩进是代码实现的一部分,它把代码分为一个个逻辑块。实际上,在Java、C和C++中,每行代码用英文的分号“;”跟下一行代码区分开;而在Python中,不能使用包括标识逻辑块的大括号在内的任何分隔符①。

其他语言中的分隔符所扮演的角色,在Python 中由缩进来扮演。也就是说,解释器根据每行代码的起始位置来决定它是否属于某个逻辑块。

1 | a=4 |

从这个例子可以看到,由于两段代码中else命令使用的缩进不同,其所表示的条件的含义(请见输出的两个字符串②)也不同。

2.2.5 IPython

IPython是基于Python开发的,增加了多种工具。

- IPython shell,性能有了极大提升的Python终端,功能强大的交互式shell。

- QtConsole,shell和GUI的混合体,实现在控制台而不是单独的窗口中显示图像。

- Jupyter Notebook,集文本、可执行代码、图像和公式的展现于一体的Web界面。

- IPython shell

IPython shell看上去像是从命令行运行的Python会话,但实际上它提供了很多其他功能。它比Python自带的shell更加强大,功能更多。在命令行输入ipython命令,即可启动IPython shell。

1 | > ipython |

如上所示,命令提示符为In[1]这种特殊形式,表示这是第一行输入。IPython命令提示符,无论是输入还是输出缓存都带有编号(索引)。

1 | In [1]: print("Hello World!") |

如上所述,表示输出的提示符也有编号,用Out[1]、Out[2]这类值来表示。IPython 把所有输入都存储到变量中。实际上,所有输入都存储在叫作In的列表中。

1 | In[4] In |

In列表中每个元素的索引恰好是(其所对应的命令的)命令提示符中的数字。因此,指定一个数值,即可得到先前输入的那一行代码。

1 | In[5]:In[3] |

对于输出,也是如此。

1 | In[6]:Out |

- Jupyter项目

近来,IPython项目有了长足发展。自IPython3.0发布以来,该项目便开始迁往新项目 Jupyter。

IPython仍将作为Python shell而存在,但IPython项目的Notebook 及与语言无关的其他组件将会迁移,以组建新项目 Jupyter,见图2-2。

图2-2 Jupyter项目的图标

- Jupyter QtConsole

要从命令行启动这个应用,必须使用以下命令:

ipython qtconsole

或jupyter qtconsole

该应用包含一个GUI界面,它囊括了IPython shell的所有功能,请见图2-3。

图2-3 Jupyter QtConsole

- Jupyter Notebook

Jupyter Notebook是交互式环境IPython的新生代力量(见图2-4)。有了Jupyter Notebook,可执行代码、文本、公式、图像和动画等内容都能整合到Web文档中,其用途很多,比如可用于演示、制作教程或辅助调试程序等。

图2-4 Jupyter Notebook的Web界面

2.3 PyPI仓库-Python包索引

Python 包索引(Python Package Index,PyPI)软件仓库包含Python编程可能会用到的所有软件,例如属于其他Python库的软件。软件仓库直接由各个包的开发者管理,一旦他们的库发布新版本,他们负责将其更新到仓库中。如果想了解PyPI仓库都有哪些包,请访问PyPI官网。

至于如何管理这些包,可以使用PyPI的包管理器pip应用。

从命令行启动 pip应用,就可以对单个包进行安装、更新或删除操作。pip会检查这个包是否已安装。若已安装,则检查是否需要更新。同时,它还会检查是否需要安装其他依赖包;若未安装,pip就会下载和安装这个包以及它的依赖包。

1 | $ pip install <<package_name>> |

至于如何安装pip,如果系统已安装了Python3.4+(2014年3月发布)或Python2.7.9(2014年12月发布),pip也随之安装了。但是,如果使用的是Python的旧版本,则需自行安装,具体方法因操作系统而异。

Linux 系统Debian和Ubuntu,使用以下命令:

$ sudo apt-get install python-pip

Linux系统Fedora,使用以下命令:

$ sudo yum install python-pip

Windows系统,请访问https://pip.pypa.io/en/latest/installing/,下载get-pip.py到计算机上。下载完成后,运行如下命令。

python get-pip.py

这样,就能安装好包管理器。记得把C:\Python3.X\Scripts添加到环境变量PATH中去。

多种 Python IDE

虽然大多数Python开发者习惯了直接在shell(Python或IPython)中编写代码,但除此之外,还可以使用IDE(Interactive Development Environment,交互式开发环境)。IDE除了具有基本的文本编辑功能之外,还提供一系列辅助代码编写和调试的工具。例如代码自动补全功能、查看命令的相关文档、调试和插入断点等。当然,IDE提供的工具比这要丰富得多。

- Spyder

Spyder(Scientific Python Development Environment,Python 科学计算开发环境)IDE跟MATLAB IDE 有很多相似之处(见图2-5)。它在文本编辑器的基础上,添加了句法高亮和代码分析工具。此外,该IDE可在图像应用中添加立刻可用的控件。

Permissions Rw End-of-ines CRLF Encoding:-

图2-5 Spyder IDE

- Eclipse (pyDev)

使用其他编程语言的开发者一定知道Eclipse,它是完全用Java(若要使用,计算机需要安装Java)开发的通用IDE,提供了适用于多种语言的开发环境(见图2-6)。Eclipse有一个版本是专门用于Python开发的,但是要安装pyDev插件。

图2-6 Eclipse IDE

- Sublime

该文本编辑器是Python程序员最喜欢的开发环境之一(见图2-7)。Sublime有多种插件,借助这些插件,用Sublime编写Python程序变得更简单,过程也很享受。

图2-7 Sublime IDE

- Liclipse

与Spyder类似,该环境也是专门用于Python开发的(见图2-8)。它与Eclipse IDE十分相似,但是它完美适配Python语言,因此无须安装pyDev等插件就能使用Python。它的安装和配置比起Eclipse更加简单。

图2-8 Liclipse IDE

- NinjaIDE

NinjaIDE、(NinjaIDE is "Not Just Another IDE", NinjaIDE不只是另一个IDE)为首字母缩略词,该词运用了递归方法。这是一款专门用于Python开发的IDE(见图2-9),最近才开发出来。它凝集了很多开发人员的心血,现在看来已是前途无量,很可能会在接下来几年给开发者带来更多惊喜。

图2-9 Ninja IDE

- Komodo IDE

Komodo IDE 功能强大,提供了多种工具,是完备、专业的开发环境(见图2-10)。它是用C++开发的付费软件,提供适用于包括Python在内的多种编程语言的开发环境。

图2-10 Komodo IDE

2.4SciPy

SciPy(音同“”SighPie”)是一组专门用于科学计算的开源Python库。本书很多章节会用到其中许多库,因为掌握这些库对数据分析很重要。由这些库组成的工具集擅长处理数据计算和可视化,因此用Python分析数据,丝毫不用羡慕其他数据计算和分析环境(比如R或MATLAB)。后续章节会着重讲解下面3个库:

- NumPy

- matplotlib

- pandas

2.4.1 NumPy

NumPy库其名称的含义是“数值Python”(Numeical Python),很多由它发展而来的Python 库都以其为核心。NumPy是用Python进行科学计算的一个基础库,因为它提供了Python基础包所没有提供的数据结构和高性能函数。实际上,正如本书后面将要讲到的,NumPy定义了一种专门用于科学计算的数据结构ndarray-它是一种N维数组。

正确使用这个库,能极大提升计算效率,因此在数值运算过程中掌握如何使用该库很重要。由于它具有独一无二的特性,在本书中几乎随处可见,因此很有必要用一章的篇幅(第3章)来介绍它。

NumPy的如下功能将会被添加到Python标准发行版中。

ndarray:多维数组,比Python基础包提供的速度更快、效率更高。

元素级计算(element-wise computation):一组用于数组或数组之间按照元素级运算的函数。

读-写数据集:一组从硬盘中读取数据或往硬盘写入数据的函数。

整合C、C++和Fortran等编程语言:整合其他语言编写的代码的工具集。

2.4.2 pandas

该包提供了复杂的数据结构和函数,其目的是降低处理难度,提升速度和效率。它是Python 数据分析的核心包。因此,对该包的研究和应用将作为主题贯穿全书(第4、5和6章着重讲解)。详细讲解pandas的各方面知识,尤其是它在数据分析场景中的应用,是本书的主要目标。

该包最为基础的概念为数据框(DataFrame)。它是一个两维表格状数据结构,行和列均有标签。

pandas整合了NumPy库的高性能特性,可处理电子表格或关系型数据库(SQL数据库)中的数据。借助 pandas强大的索引方法,对该类数据结构进行变形、切片、聚合和选取子集等操作比较容易。

2.4.3 matplotlib

这个包是目前绘制2D图像最常用的Python包。数据分析少不了可视化工具,而这个包最适合。第7章将详细讲解它的用法,之后便能以最佳方式展现数据分析结果了。

2.5 小结

本章讲述了Python的主要基础内容,通过简洁的例子介绍了Python的基础概念,解释了它所引入的新特点,尤其是那些比其他语言更为出色的特点,还展示了它的不同使用方法。首先讲解了简单的命令行解释器的使用方法,然后介绍了一系列简单的图形用户界面,最后引入了IDE 这类复杂的开发环境,比如Spyder、Liclipse和NinjaIDE。

本章还介绍了极具创新意义的Jupyter(IPython)项目,展示了以交互式方式(尤其是用Jupyter Notebook)编写代码的可能性。

Python通过第三方库来扩展标准函数集的功能体现了它的模块化特性,就这一点介绍了PyPI 在线仓库以及Python的其他发行版,比如Anaconda和 Enthought Canopy。

下一章将介绍作为Python数值计算基础的第一个库NumPy,还会讲解ndarray这种数据结构。后续章节中数据分析所使用的更为复杂的数据结构都以它为基础。

第3章 NumPy库

NumPy是用Python进行科学计算,尤其是数据分析时,所用到的一个基础库。它是大量Python数学和科学计算包的基础,比如后面要讲到的pandas库就用到了NumPy。pandas库专门用于数据分析,充分借鉴了Python标准库NumPy的相关概念。而Python标准库所提供的内置工具对数据分析方面的大多数计算来说都过于简单或不够用。

为了更好地理解和使用Python所有的科学计算包,尤其是pandas,需要先行掌握NumPy库的用法,这样才能把pandas的用处发挥到极致。pandas是后续章节的主题。

如果你熟悉NumPy库,可跳过本章直接学习下一章;否则,可以借此机会复习一下NumPy 的基础概念,或者运行本章的示例代码,争取尽快步入正轨。

3.1 NumPy简史

Python语言诞生不久,开发人员就产生了数值计算的需求,更为重要的是,科学社区开始考虑用它进行科学计算。

1995年,Jim Hugunin开发了Numeric,这是第一次尝试用Python进行科学计算。随后又诞生了 Numarray包。这两个包都是专门用于数组计算的,但各有各的优势,开发人员只好根据不同的使用场景,从中选择效率更高的包。由于两者之间的区别并不那么明确,开发人员产生了把它们整合为一个包的想法。Travis Oliphant遂着手开发NumPy库,并于2006年发布了它的第一个版本(v1.0)。

从此之后,NumPy成为Python科学计算的扩展包。如今,在计算多维数组和大型数组方面,它是使用最广的。此外,它还提供多个函数,操作起数组来效率很高,还可用来实现高级数学运算。

当前,NumPy是开源项目,使用BSD许可证。在众多开发者的支持下,这个库的潜力得到了进一步挖掘。

3.2 NumPy 安装

通常,大多数Python发行版都把NumPy作为一个基础包。然而,如果NumPy不是基础包的话,可以自行安装。

Linux系统(Ubuntu和Debian),使用如下命令:

sudo apt-get install python-numpy

Linux系统(Fedora),使用如下命令:

sudo yum install numpy scipy

使用Anaconda发行版的Windows系统,使用如下命令:

conda install numpy

NumPy安装到系统之后,在Python会话中输入以下代码导入它NumPy模块:

>>>import numpy as np

3.3 ndarray:NumPy库的心脏

NumPy库的基础是ndarray(N-dimensional array,N维数组)对象。它是一种由同质元素组成的多维数组,元素数量是事先指定好的。同质指的是几乎所有元素的类型和大小都相同。实际上,数据类型由另外一个叫作dtype(data-type,数据类型)的NumPy对象来指定,每个ndarray 只有一种dtype类型。

数组的维数和元素数量由数组的型(shape)来确定,数组的型由N个正整数组成的元组来指定,元组的每个元素对应每一维的大小。数组的维统称为轴(axes),轴的数量被称作秩(rank)。

NumPy数组的另一个特点是大小固定,即创建数组时一旦指定好大小,就不会再发生改变。这与Python的列表有所不同,列表的大小是可以改变的。

定义ndarray最简单的方式是使用array()函数,以Python列表作为参数,列表的元素即是ndarray的元素。

1 | >>>a=np.array([1,2,3]) |

检测新创建的对象是否是ndarray很简单,只需要把新声明的变量传递给type()函数即可。

1 | >>>type(a) |

调用变量的dtype属性,即可获知新建的ndarray属于哪种数据类型。

1 | >>>a.dtype |

刚建的这个数组只有一个轴,因而秩的数量为1,它的型为(3,1)。这些值的获取方法如下:轴数量需要使用ndim属性,数组长度使用size属性,而数组的型要用shape属性。

1 | >>>a.ndim |

上面这个数组非常简单,只有一维。但是数组很容易就能扩展成多维。例如可以定义一个2×2的二维数组:

1 | >>>b=np.array([1.3,2.4],[0.3,4.1]) |

这个数组有两条轴,所以秩为2,每条轴的长度为2。

ndarray对象拥有另外一个叫作 itemsize 的重要属性。它定义了数组中每个元素的长度为几个字节。data属性表示的是包含数组实际元素的缓冲区。该属性至今用得并不多,因为要获取数组中的元素,使用接下来几节即将学到的索引方法即可。

1 | >>>b.itemsize |

3.3.1 创建数组

数组的创建方法有几种,最常用的就是前面讲过的,使用array()函数,参数为单层或嵌套列表。

1 | >>>c=np.array([[1,2,3],[4,5,6]]) |

除了列表,array()函数还可以接收嵌套元组或元组列表作为参数。

1 | >>>d=np.array((1,2,3),(4,5,6)) |

此外,参数可以是由元组或列表组成的列表,其效果相同。

1 | >>>e=np.array([(1,2,3),[4,5,6],(7,8,9)]) |

3.3.2 数据类型

前面只使用过简单的整型和浮点型数据类型,其实 NumPy数组能够包含多种数据类型(见表3-1)。例如可以使用字符串类型:

1 | >>>g = np.array([['a', 'b'],['c', 'd' ]]) |

表3-1 NumPy所支持的数据类型

| 数据类型 | 说明 |

|---|---|

| bool | 以一个字节形式存储的布尔值(True或False) |

| int | 默认整型(与C中的long相同,通常为int64或int32) |

| intc | 完全等同于C中的int(通常为int32或int64) |

| intp | 表示索引的整型(与C中的size_t相同,通常为int32或int64) |

| int8 | 字节(-128~127) |

| int16 | 整型(-32768~32767) |

| int32 | 整型(-2147483648~2147483647) |

| int64 | 整型(-9223372036854775808~9223372036854775807) |

| uint8 | 无符号整型(0~255) |

| uint16 | 无符号整型(0~65535) |

| uint32 | 无符号整型(0-4294967295) |

| uint64 | 无符号整型(0~18446744073709551615) |

| float | float64的简写形式 |

| float16 | 半精度浮点型:符号位、5位指数、10位小数部分 |

| float32 | 单精度浮点型:符号位、8位指数、23位小数部分 |

| float64 | 双精度浮点型:符号位、11位指数、52位小数部分 |

| complex | complex128的简写形式 |

| complex64 | 复数,由两个32位的浮点数来表示(实数部分和虚数部分) |

| complex128 | 复数,由两个64位的浮点数来表示(实数部分和虚数部分) |

3.3.3 dtype 选项

array()函数可以接收多个参数。每个ndarray()对象都有一个与之相关联的dtype对象,该对象唯一定义了数组中每个元素的数据类型。array()函数默认根据列表或元素序列中各元素的数据类型,为ndarray()对象指定最适合的数据类型。但是,可以用dtype选项作为函数array()的参数,明确指定dtype的类型。

例如要定义一个复数数组,可以像下面这样使用dtype选项:

1 | >>>f = np.array([[1,2,3],[4,5,6]],dtype=complex) |

3.3.4 自带的数组创建方法

NumPy库有几个函数能够生成包含初始值的N维数组,数组元素因函数而异。对于本章乃至全书内容,这些函数非常有用。实际上,有了这些函数,仅用一行代码就能生成大量数据。

例如zeros()函数能够生成由 shape参数指定维度信息、元素均为零的数组。举个例子,下述代码会生成一个3×3型的二维数组:

1 | >>>np.zeros((3,3)) |

ones()函数与上述函数相似,生成一个各元素均为1的数组。

1 | >>>np.ones((3,3)) |

这两个函数默认使用float64数据类型创建数组。NumPy arange()函数特别有用。它根据传入的参数,按照特定规则,生成包含一个数值序列的数组。例如要生成一个包含数字0到9的数组,只需传入标识序列结束的数字①作为参数即可。

1 | >>>np.arange(0,10) |

如果不想以0作为起始值,可自行指定,这时需要使用两个参数:第1个为起始值,第2个为结束值。

1 | >>>np.arange(4,10) |

还可以生成等间隔的序列。如果为arange()函数指定了第3个参数,它表示序列中相邻两个值之间的差距2有多大。

1 | >>>np.arange(0,12,3) |

此外,第3个参数还可以是浮点型。

1 | >>>np.arange(0,6,0.6) |

截至目前,所创建的都是一维数组。如果要生成二维数组,仍然可以使用arange()函数,但是要结合reshape()函数。后者按照指定的形状,把一维数组拆分为不同的部分。

1 | >>>np.arange(0,12).reshape(3,4) |

另外一个跟arange()函数非常相似的函数是linspace()。它的前两个参数同样是用来指定序列的起始和结尾,但第3个参数不再表示相邻两个数字之间的距离,而是用来指定我们想把由开头和结尾两个数字所指定的范围分成几个部分。

1 | >>>np.linspace(0,10,5) |

最后介绍另外一个创建包含初始值的数组的方法:使用随机数填充数组。可以使用numpy.random模块的random()函数,数组所包含的元素数量由参数指定。

1 | >>>np.random.random(3) |

每次用random()函数生成的数组,其元素均会有所不同。若要生成多维数组,只需把数组的大小作为参数传递给它。

1 | >>>np.random.random((3,3)) |

3.4 基本操作

前面介绍了新建NumPy数组和定义数组元素的方法。下面介绍数组的各种运算方法。

3.4.1 算术运算符

数组的第一类运算是使用算术运算符进行的运算。最显而易见的是为数组加上或乘以一个标量。

1 | >>>a=np.arange(4) |

这些运算符还可以用于两个数组的运算。在NumPy中,这些运算符为元素级。也就是说,

它们只用于位置相同的元素之间,所得到的运算结果组成一个新的数组。运算结果在新数组中的位置跟操作数位置相同(见图3-1)。

1 | >>>b=np.arange(4,8) |

图3-1 元素级加法

此外,这些运算符还适用于返回值为NumPy数组的函数。例如可以用数组a乘上数组b的正弦值或平方根。

1 | >>>a * np.sin(b) |

对于多维数组,这些运算符仍然是元素级。

1 | >>>A=np.arange(0,9).reshape(3,3) |

3.4.2 矩阵积

选择使用*号作为元素级运算符是NumPy库比较奇怪的一点。实际上,在很多其他数据分析

工具中,*在用于两个矩阵之间的运算时指的是矩阵积(mastrix produet)。而NumPy用dot()函数表示这类乘法,注意,它不是元素级的。

1 | >>np.dot(A,B) |

所得到的数组中每个元素为,第1个矩阵中与该元素行号相同的元素与第2个矩阵中与该元素列号相同的元素,两两相乘后再求和。图3-2描述的正是矩阵积的计算过程(只给出了矩阵积中两个元素的计算过程)。

图3-2 矩阵积中元素的计算方法

矩阵积的另外一种写法是把dot()函数当作其中一个矩阵对象的方法。

1 | >>>A.dot(B) |

请注意,由于矩阵积计算不遵循交换律,因此在这里要多说一句,运算对象的顺序很重要。$A ^ { * } B$确实不等于B*A。

1 | >>>np.dot(B,A) |

3.4.3 自增和自减运算符

Python没有++或–运算符。对变量的值进行自增与自减,需要使用+=或-=运算符。这两个运算符跟前面见过的只有一点不同,运算得到的结果不是赋给一个新数组而是赋给参与运算的数组自身。

1 | >>>a=np.arange(4) |

因此,这类运算符比每次只能加1的自增运算符用途更广。例如修改数组元素的值而不想生成新数组时,就可以使用它们。

1 | array([0,1,2,3]) |

3.4.4 通用函数

通用函数(universal function)通常叫作ufunc,它对数组中的各个元素逐一进行操作。这表明,通用函数分别处理输入数组的每个元素,生成的结果组成一个新的输出数组。输出数组的大小跟输入数组相同。

三角函数等很多数学运算符合通用函数的定义,例如计算平方根的sqrt()函数、用来取对数的log()函数和求正弦值的sin()函数。

1 | >>>a=np.arange(1,5) |

NumPy实现了很多通用函数。

3.4.5 聚合函数

聚合函数是指对一组值(比如一个数组)进行操作,返回一个单一值作为结果的函数。因而,求数组所有元素之和的函数就是聚合函数。ndarray类实现了多个这样的函数。

1 | >>>a=np.array([3.3,4.5,1.2,5.7,0.3]) |

3.5 索引机制、切片和迭代方法

前面讲解了数组创建和数组运算。下面将介绍数组对象的操作方法,以及如何通过索引和切片方法选择元素,以获取数组中某几个元素的视图或者用赋值操作改变元素。最后会讲解数组的迭代方法。

3.5.1 索引机制

数组索引机制指的是用方括号([])加序号的形式引用单个数组元素,它的用处很多,比如抽取元素,选取数组的几个元素,甚至为其赋一个新值。

新建数组的同时,会生成跟数组大小一致的索引(见图3-3)。

图3-3 一维数组的索引机制

要获取数组的单个元素,指定元素的索引即可。

1 | >>>a=np.arange(10,16) |

NumPy数组还可以使用负数作为索引。这些索引同样为递增序列,只不过从0开始,依次增加-1,但实际表示的是从数组的最后一个元素向数组第1个元素移动。在负数索引机制中,数组第1个元素的索引最小。

1 | >>>a[-1] |

方括号内传入多个索引值,可以同时选择多个元素。

1 | >>>a[[1,3,4]] |

下面介绍二维数组,也称矩阵。矩阵是由行和列组成的矩形数组,行和列用两条轴来定义,其中轴0用行表示,轴1用列表示。因此,二维数组的索引用一对值来表示:第1个值为行索引,第2个值为列索引。所以,如果要获取或选取矩阵中的元素,仍使用方括号,但索引值为两个[行索引,列索引](见图3-4)。

图3-4 二维数组的索引机制

1 | >>A=np.arange(10,19).reshape((3,3)) |

如果想获取第2行第3列的元素,需要使用索引值[1,2]。

1 | >>>A[1,2] |

3.5.2 切片操作

切片操作是指抽取数组的一部分元素生成新数组。对Python列表进行切片操作得到的数组是原数组的副本,而对NumPy数组进行切片操作得到的数组则是指向相同缓冲区的视图。

若想抽取(或查看)数组的一部分,必须使用切片句法,即把几个用冒号(:)隔开的数字置于方括号里。

若想抽取数组的一部分,例如从第2个到第6个元素这一部分,就需要在方括号里指定起始元素的索引1和结束元素的索引5。

1 | >>>a=np.arange(10,16) |

若想从上面那一部分元素中,每隔一定数量的元素抽取一个,可以再用一个数字指定所抽取的两个元素之间的间隔大小。例如间隔为2表示每隔一个元素抽取一个。

1 | >>a[1:5:2] |

为了更好地理解切片句法,还应考虑不明确指明起始和结束位置的情况。如果省去第1个数字,NumPy会认为第1个数字是0(对应数组的第1个元素);如果省去第2个数字,NumPy则会认为第2个数字是数组的最大索引值;如果省去最后一个数字,它将会被理解为1,也就是抽取所有元素而不再考虑间隔。

1 | >>>a[::2] |

对于二维数组,切分句法依然适用,只不过需要分别指定行和列的索引值。例如只抽取第1行:

1 | >>A=np.arange(10,9).reshape((3,3)) |

上面代码中,第2个索引处只使用冒号,而没有指定任意数字,这样选择的是所有列。相反,如果想抽取第1列的所有元素,方括号中的两项应该交换位置。

1 | >>>A[:,0] |

如要抽取一个小点儿的矩阵,需要明确指定所有的抽取范围。

1 | >>>A[0:2,0:2] |

如要抽取的行或列的索引不连续,可以把这几个索引放到数组中。

1 | >>>A[[0,2],0:2] |

3.5.3 数组迭代

Python数组元素的迭代很简单,只需要使用for结构即可。

1 | for i ina: |

二维数组当然也可以使用for结构,把两个嵌套在一起即可。第1层循环扫描数组的所有行,第2层循环扫描所有的列。实际上,如果遍历矩阵,就会发现它总是按照第1条轴对矩阵进行扫描。

1 | >>>for row in A: |

如果想遍历矩阵的每个元素,可以使用下面结构,用for循环遍历A.flat。

1 | >>>for item in A.flat: |

除了for循环,NumPy还提供另外一种更为优雅的遍历方法。通常用函数处理行、列或单个元素时,需要用到遍历。如果想用聚合函数处理每一列或行,返回一个数值作为结果,最好用纯NumPy方法处理循环:apply_along_axis()函数。

这个函数接收3个参数:聚合函数、对哪条轴应用迭代操作和数组。如果axis选项的值为0,按列进行迭代操作,处理元素;若值为1,则按行操作。例如可以先求每一列的平均数,再求每一行的平均数。

1 | >>>np.apply_along_axis(np.mean,axis=0,arr=A) |

上述例子使用了NumPy库定义的函数,但是也可以自己定义这样的函数。上面还使用了聚合函数,然而,用通用函数也未尝不可。下面的例子,先后按行、列进行迭代操作,但两者的最终结果一致。通用函数apply_along_axis()实际上是按照指定的轴逐元素遍历数组。

1 | >>>def foo(x): |

如上所示,不论是遍历行还是遍历列,通用函数都将输入数组的每个元素折半处理。

3.6 条件和布尔数组

前面介绍了用索引和切片方法从数组中选择或抽取一部分元素。这些方法使用数值形式的索引。另外一种从数组中有选择性地抽取元素的方法是使用条件表达式和布尔运算符。

下面详细介绍这种方法。例如从由0到1之间的随机数组成的4x4型矩阵中选取所有小于0.5的元素。

1 | >>>A=np.random.random((4,4)) |

创建随机数矩阵后,如果使用表示条件的运算符,比如这里的小于号,将会得到由布尔值组成的数组。对于原数组中条件满足的元素,布尔数组中处于同等位置(该例中为小于0.5的元素所处的位置)的元素为True。

1 | >>>A < 0.5 |

实际上,从数组中选取一部分元素时,隐式地用到了布尔数组。其实,直接把条件表达式置于方括号中,也能抽取所有小于0.5的元素,组成一个新数组。

1 | >>>A[A<0.5] |

3.7 形状变换

创建二维数组时,前面讲过用reshape()函数把一维数组转换为矩阵。

1 | >>>a=np.random.random(12) |

reshape()函数返回一个新数组,因而可用来创建新对象。然而,如果想通过改变数组的形状来改变数组对象,需把表示新形状的元组直接赋给数组的shape属性。

1 | >>>a.shape=(3,4) |

由输出结果来看,上述操作改变了原始数组的形状,而没有返回新对象。改变数组形状的操作是可逆的,ravel()函数可以把二维数组再变回一维数组。

1 | >>>a=a.ravel() |

甚至直接改变数组shape属性的值也可以。

1 | >>>a.shape=(12) |

另外一种重要的运算是交换行列位置的矩阵转置。NumPy的transpose()函数实现了该功能。

1 | >>A.transpose() |

3.8 数组操作

往往需要用已有数组创建新数组。本节介绍如何通过连接或切分已有数组创建新数组。

3.8.1 连接数组

可以把多个数组整合在一起形成一个包含这些数组的新数组。NumPy使用了栈这个概念,提供了几个运用栈概念的函数。例如vstack()函数执行垂直入栈操作,把第2个数组作为行添加到第1个数组,数组朝垂直方向生长。相反,hstack()函数执行水平入栈操作,即把第2个数组作为列添加到第1个数组。

1 | >>>A=np.ones((3,3)) |

另外两个用于多个数组之间栈操作的函数是column_stack()和row_stack()。这两个函数不同于上面两个。通常两个函数把一维数组作为列或行压入栈结构,以形成一个新的二维数组。

1 | >>>a=np.array([0,1,2]) |

3.8.2 数组切分

前面讲了使用压栈操作把多个数组组装到一起的方法。下面介绍它的逆操作:把一个数组分为几部分。在NumPy中,该操作要用到切分方法。同理,有这样一组函数,水平切分用hsplit()函数,垂直切分用vsplit()函数。

1 | >>>A=np.arange(16).reshape((4,4)) |

水平切分数组的意思是把数组按照宽度切分为两部分,例如4×4矩阵将被切分为两个4x2矩阵。

1 | >>>[B,C]=np.hsplit(A,2) |

反之,垂直切分指的是把数组按照高度分为两部分,例如4×4矩阵将被切为两个2×4矩阵。

1 | >>>[B,C]=np.vsplit(A,2) |

split()函数更为复杂,可以把数组分为几个不对称的部分。此外,除了传入数组作为参数外,还得指定被切分部分的索引。如果指定axis=1项,索引为列索引;如果axis=0,索引为行索引。

例如,要把矩阵切分为3部分,第1部分为第1列,第2部分为第2列、第3列,而第3部分为最后一列。需要像下面这样指定索引值。

1 | >>>[A1,A2,A3]=np.split(A,[1,3],axis=1) |

也可以按行切分,方法相同。

1 | >>>[A1,A2,A3]=np.Split(A,[1,3],axis=0) |

split()函数还具有vsplit()和hsplit()函数的功能。

3.9 常用概念

下面介绍NumPy库的几个常用概念,会讲解副本和视图的区别,其中着重讲解两者返回值的不同点,还会介绍NumPy函数的很多事务(transaction)隐式使用的广播机制(broadcasting)。

3.9.1 对象的副本或视图

你可能已经注意到,NumPy中,尤其在进行数组运算或数组操作时,返回结果不是数组的副本就是视图。NumPy中,所有赋值运算不会为数组和数组中的任何元素创建副本。

1 | >>>a=np.array([1,2,3,4]) |

把数组a赋给数组b,实际上不是为a创建副本,b只不过是调用数组a的另外一种方式。实际上,修改a的第3个元素,同样会修改b的第3个元素。数组切片操作返回的对象只是原数组的视图。①

1 | >>>c=a[0:2] |

如上所示,即使是切片操作得到的结果,实际上仍指向相同的对象。如果想为原数组生成一份完整的副本,从而得到一个不同的数组,使用copy()函数即可。

1 | >>>a=np,array([1,2,3,4]) |

上面的例子中,即使改动数组a的元素,数组c仍保持不变。

3.9.2 向量化

向量化和广播这两个概念是NumPy内部实现的基础。有了向量化,编写代码时无须使用显式循环。这些循环实际上不能省略,只不过是在内部实现,被代码中的其他结构代替。向量化的

①注意与Python列表切片操作区别开来。列表操作得到的是副本。

应用使得代码更简洁、更易读,即使用了向量化方法的代码看上去更“Pythonic”。向量化使得很多运算看上去更像是数学表达式,例如NumPy中两个数组相乘可以表示为:

a*b

甚至两个矩阵相乘也可以这么表示:

A*B

其他语言的上述运算要用到多重嵌套循环和for结构体。例如计算数组相乘:

1 | for(i = 0;i<rows;i++){ |

由上可见,使用NumPy时,代码的可读性更强,其表达式更像是数学表达式。

3.9.3 广播机制

广播机制这一操作实现了对两个或以上数组进行运算或用函数处理,即使这些数组形状并不完全相同。也就是说,并不是所有的维度都要彼此兼容才符合广播机制的要求,但它们必须要满足一定的条件。

前面讲过,在NumPy中,如何通过用表示数组各维度长度的元组(也就是数组的型)把数组转换成多维数组。

因此,若两个数组的各维度兼容,也就是两个数组的每一维等长,或其中一个数组为一维,那么广播机制就适用。如果这两个条件都不能满足,NumPy就会抛出异常,说两个数组不兼容。

1 | >>>A=np.arange(16).reshape(4,4) |

执行上述代码,可得到两个数组:

1 | 4 × 4 |

广播机制有两条规则。第1条是为缺失的维度补上个1。如果这时满足兼容性条件,就可以应用广播机制,再来看第2条规则。例如:

1 | 4 x 4 |

兼容性规则满足之后,再来看一下广播机制的第2条规则。这一规则解释的是如何扩展最小的数组,使得它跟最大的数组大小相同,以便使用元素级的函数或运算符。

第2条规则假定缺失元素(一维)都用已有值进行了填充(见图3-5)。

图3-5 应用广播机制的第2条规则

既然两个数组维度相同,它们里面的值就可以相加。

1 | >>>A+b |

上例这种情况比较简单,一个数组较另一个小。还有更复杂的情况,即两个数组形状不同、维度不同、各有长短。

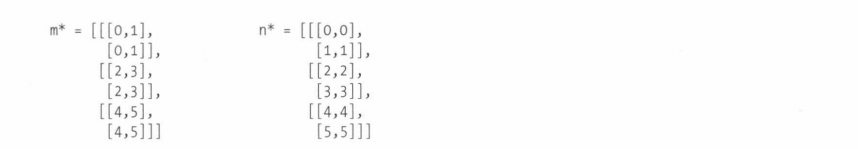

1 | m=np.arange(6).reshape(3,1,2) |

即使是这种复杂情况,分析两个数组的形状,会发现它们仍相互兼容,因此广播规则仍然适用。

1 | 3×1×2 |

这种情况下,两个数组都要扩展维度(进行广播)。

然后,就可以对两个数组进行诸如加法这样的元素级运算。

1 | >>>m+n |

3.10 结构化数组

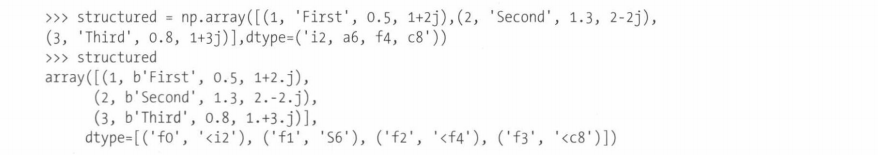

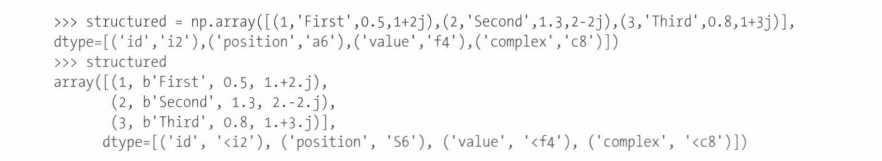

前面的多个例子讲了一维数组和二维数组。在NumPy中,不仅可以创建规模更为复杂的数组,还可以创建结构更为复杂的数组,后者叫作结构化数组(structured array),它包含的是结构或记录而不是独立的元素。

例如可以创建一个简单的结构化数组,其中元素为结构体。可以用dtype选项,指定一系列用逗号隔开的说明符,指明组成结构体的元素及它们的数据类型和顺序。

1 | bytes b1 |

例如指定由一个整数、一个长度为6的字符串、一个长度为4的float类型和一个长度为8位的复数类型组成的结构体,就要在dtype选项中按顺序指定各自的说明符。

还可以在数据类型(dtype)选项中明确指定每个元素的类型,例如int8、uint8、float16、complex64等。

上述两种做法结果相同。生成的数组中,dtype序列包含结构体各项的名称及相应的数据类型。

使用索引值,就能获取包含相应结构体的行。

1 | structured[1] |

自动赋给结构体每个元素的名称可以看成数组列的名称。用它们作为结构化索引,就能引用类型相同或是位于同列的元素。

如上所示,自动分配的名称的第1个字符为f(field,字段),后面紧跟的是表示它在序列中位置的整数。其实,用更有意义的内容作为名字,用处更大。在声明数组时,可以指定各字段的名称。

或在创建完成后,重新定义结构化数组的dtype属性,在元组中指定各字段的名称。

1 | >>>structured.dtype.names = ('id', 'order', 'value', 'complex') |

现在可以使用更有意义的字段名来获取数组的某一列。

3.11 数组数据文件的读写

至此,本书还没有讲如何读取文件中的数据。NumPy这方面的内容很重要,用处很大,尤其是在处理数组中包含大量数据的情况时。这在数据分析中很常见,因为要分析的数据集通常都很大,所以由人工来管理这类事务的执行,以及接下来的从一台计算机或计算过程的一段会话读取数据到另一台计算机或另一段会话,是不可取甚至是不可能的。

NumPy提供了几个函数,数据分析师可用其把结果保存到文本或二进制文件中。类似地,NumPy还提供了从文件中读取数据并将其转换为数组的方法。

3.11.1 二进制文件的读写

NumPy的save的save()方法以二进制格式保存数据,load()方法以二进制格式保存数据,load()方法则从二进制文件中读取数据。()

假如要保存一个数组,例如数据分析过程产生的结果,调用save()函数即可,参数有两个:要保存到的文件名和要保存的数组,其中文件名中的.npy扩展名系统会自动添加。

1 | data=([[0.86466285,0.76943895,0.22678279], |

若要恢复存储在.npy文件中的数据,可以使用load()函数,用文件名作为参数,这次记得添加.npy扩展名。

1 | >>>loaded_data = np.load('saved_data.npy') |

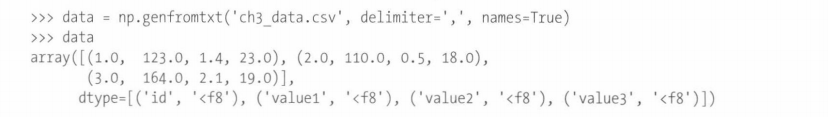

3.11.2 读取文件中列表形式的数据

很多时候要读写文本格式的数据(比如TXT或CSV)。当使用NumPy或其他应用时,考虑到文本格式的文件不必使用这些应用也能处理,因此通常都会将数据存储为文本格式而不是二进制格式。拿几行CSV(Comma-Separated Values,用逗号分割的值)格式的数据为例。这种格式为列表形式,每两个值之间用逗号隔开(见代码清单3-1)。

代码清单3-1 ch3_data.csv

1 | id,value1,value2,value3 |

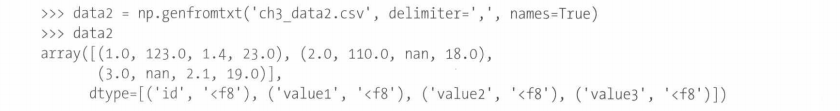

NumPy的 genfromtxt()函数可以从文本文件中读取数据并将其插入数组中。通常而言,这个函数接收3个参数:存放数据的文件名、用于分割值的字符(该例中为逗号)和数据是否含有列标题。在接下来这个例子中,分隔符为逗号。

输出结果是一个结构化数组,各列的标题变为各字段的名称。

这个函数其实包含两层隐式循环:第1层循环每次读取一行,第2层循环将每一行的多个值分开后,再对这些值进行转化,依次插入所创建的元素。这个函数的优点是它能处理文件中的缺失数据。

以上面的文件为例(见代码清单3-2),从中删除几个元素后,将其另存为data2.csv。

代码清单3-2 ch3_data2.csv

1 | id,value1,value2,value3 |

运行下述命令,观察genfromtxt()是怎样把内容为空的项填充为nan值的。

输出结果中,数组的下面为文件的列标题。可以将这些标题看成能够充当索引的标签,用它们就能按列抽取元素。

1 | >>>data2['id'] |

而按照传统方法,使用数值索引则是按行抽取数据。

1 | >>>data2[0] |

3.12 小结

本章介绍了NumPy库所有的主要内容。通过一系列例子讲解了NumPy的多种功能,它们是书中其他内容的基础。实际上,后续多个概念来自其他更为专业的科学计算库,但是这些库的结构参考了NumPy,并且是以NumPy库为基础进行开发的。

本章还介绍了ndarray扩展了Python的功能,因而适用于科学计算,尤其是数据分析。

对想从事数据分析的人来说,掌握NumPy至关重要。

下一章将介绍一个新库pandas。它以NumPy为基础,吸收了本章讲到的所有基础概念,并进行了扩展,更适合数据分析。

第4章 pandas库

下面开始介绍本书的重心:pandas库。这个库是用Python语言分析数据的得力工具。

本章将介绍这个库的基础知识、安装方法,以及 Series(序列)和DataFrame(数据框)这两种数据结构,还会使用pandas库的几个基础函数处理最常见的数据分析任务。熟悉这些操作对本书后续内容的学习起着至关重要的作用。因此,建议重复练习本章教授的所有技能,直到熟练掌握。

本章还将通过多个例子讲解 pandas 库采用的新概念:它的数据结构所使用的索引机制。至于如何充分利用索引机制处理数据,这一章和接下来几章会作讲解。

本章最后将介绍如何通过层级索引将索引机制这个概念同时扩展到多层。

4.1 pandas:Python数据分析库

pandas是一个专门用于数据分析的开源Python库。目前,所有使用Python语言研究和分析数据集的专业人士,在做相关统计分析和决策时,pandas都是他们的基础工具。

2008年,Wes McKinney一人挑起了pandas库的设计和开发工作。2012年,他的同事Sien Chang加入开发。他俩一起开发出了Python社区最为有用的库之一—-pandas。

数据分析工作需要一个专门的库,它能以最简单的方式提供数据处理、数据抽取和数据操作所需的全部工具,开发pandas正是为了满足这个需求。

Wes McKinney 选择以NumPy库作为Python库 pandas的基础进行设计。可以说,该选择对于pandas的成功和它的迅速扩展起着至关重要的作用。实际上,选择以NumPy为基础,不仅使pandas能和其他大多数模块相兼容,而且还能借力NumPy模块在计算方面性能高的优势。

另外一个意义深远的决定是为数据分析专门设计了两种数据结构。实际情况是,pandas没有使用Python已有的内置数据结构,也没有使用其他库的数据结构,而是开发了两种新型的数据结构。

这两种数据结构的设计初衷是用于关系型或带标签的数据。用它们管理与SQL关系数据库和Excel工作表具有类似特征的数据很方便。

本书会讲到一系列数据分析的基础操作,操作对象通常为数据库表或工作表。pandas提供多个函数和方法用于数据分析,在很多情况下,它们是执行这些操作的最佳方法。

因此,pandas的主要目的是为每一位数据分析人士提供所有的基础工具。

4.2 安装pandas

安装 pandas库最简单和最常用的方法是先安装一个发行版,例如先安装 Anaconda或Enthought,再用发行版安装pandas。

4.2.1 用Anaconda安装

对于选用Anaconda发行版的读者,安装pandas很简单。首先查看pandas是否已经安装,安装的版本号是多少。在终端输入以下命令:

conda list pandas

因为我事先在计算机(Windows系统)上安装了pandas库,所以得到如下输出结果:

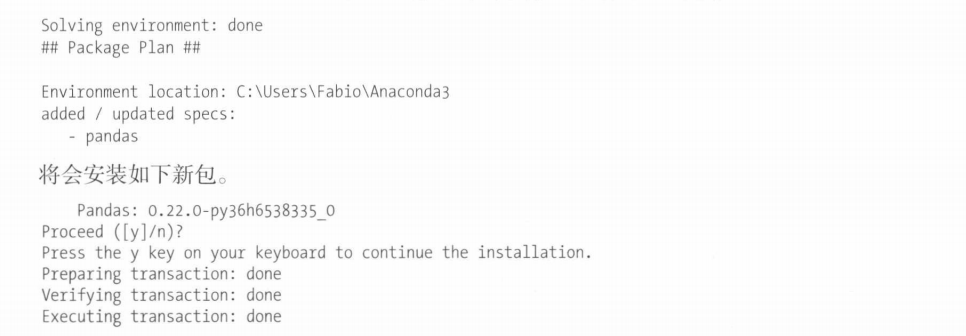

如果之前未安装,就需要安装pandas库。请输入以下命令:conda install pandas

Anaconda立即检查所有的依赖库,管理其他模块的安装,你不必费心。

如果想更新pandas库,命令也很简单直接:

conda update pandas

Anaconda 会检查 pandas以及所有依赖模块的版本,如果有更新,会予以提示,并询问你是否想更新。

4.2.2 用PyPI安装

还可以从PyPI安装pandas,命令如下:pip install pandas

4.2.3 Linux系统上的安装方法

如果使用的是某一Linux发行版,且不打算使用打包好的Python发行版,可以像安装其他包那样安装 pandas。

Debian和 Ubuntu Linux系统,使用如下命令:sudo apt-get install python-pandas

OpenSuse和Fedora系统,则需要使用以下命令:zypper in python-pandas

4.2.4 用源代码安装

如果想通过编译源代码来安装pandas模块,请参考https://github.com/pandas-dev/pandas。

1 | git clone git://github.com/pydata/pandas.git |

编译前,确保已经安装 Cython。更多信息请参考包括官方文档(http://pandas.pydata.org/pandas-docs/stable/install.html)在内的在线文档。

4.2.5 Windows 模块仓库

Windows系统用户如果喜欢自己管理模块,以便总是使用最新模块,可以从网上模块仓库下载很多第3方模块—Christoph Gohlke的Windows系统Python扩展包仓库(www.lfd.uci.edu/~gohlke/pythonlibs/)。每个模块都提供32位和64位WHL(wheel)格式的安装包。如果要安装模块,需要使用pip命令(参见第2章的PyPI)。

pip install SomePackege-1.0.whl

如要安装pandas,可查找并下载下面这个包:

pip install pandas-0.22.0-cp36-cp36m-win_amd64.wh1

选择模块时,注意选择与Python版本和计算机系统相兼容的版本。此外,虽然NumPy不依赖其他包,但是pandas依赖多个包。要确保安装所有的依赖包,不过安装顺序并不重要。

这种方法的缺点是,每个包要单独安装,没有包管理器来协助管理版本和依赖;而优点是,对这些模块及其版本有更大的控制权,不必用发行版提供的包,可使用最新的包。

4.3 测试pandas是否安装成功

pandas库还提供一项功能,安装完成后,可运行测试,检查内部命令能否执行(官方文档表示,所有内部代码的测试覆盖率高达97%)。

首先确保 Python发行版安装了nose模块(请见下面“nose模块”的介绍)。若已安装,输入以下命令开始测试:nosetests pandas

测试任务需要花费几分钟时间,测试完成后,将显示问题列表。

4.4 开始pandas之旅

对于本章内容,建议打开 Python shell,逐条输入命令。这样有助于你熟悉本章讲解的各个函数和数据结构。

此外,本章前面例子中定义的数据和函数在后面仍然有效,无须每次重复定义。每个例子结束后,建议重复练习各条命令,可适当修改,在操作过程中留意如何操纵数据结构中的数据。这种方法非常适合用来熟悉本章讲解的几项主要内容,你可以以交互式方式探索命令的作用,从而避免机械地编写和执行代码。

首先,在Python shell打开一段会话,导入pandas库。pandas的常用导入方法如下:

1 | import pandas as pd |

因此,本书之后再出现pd和np时,它们分别指的是与pandas和NumPy这两个库相关的对象或方法,即使你可能想使用下面这种方法导入pandas模块:

1 | >>>from pandas import * |

这样就无须用pd指定函数、对象或方法了。然而,Python社区不提倡这种方法。

4.5 pandas数据结构简介

pandas的核心为两大数据结构,数据分析相关的所有事务都是围绕着这两种结构进行的:

- Series

- DataFrame

后面也会讲,Series这类数据结构用于存储一个序列这样的一维数据,而DataFrame作为更复杂的数据结构,则用于存储多维数据。

虽然这些数据结构不能解决所有问题,但它们为大多数应用提供了有效和强大的工具。就简洁性而言,它们理解和使用起来都很简单。此外,很多更为复杂的数据结构都可以追溯到这两种结构。

然而,两者的奇特之处是将Index(索引)对象和标签整合到自己的结构中。后面将会看到,该特点使得这两种数据结构易于操作。

4.5.1 Series 对象

pandas库的Series对象用来表示一维数据结构,跟数组类似,但多了一些额外的功能。它的内部结构很简单(见图4-1),由两个相互关联的数组组成,其中主数组用来存放数据(NumPy 任意类型数据)。主数组的每个元素都有一个与之相关联的标签,这些标签存储在另外一个叫作index的数组中。

图4-1 Series对象的结构

1. 声明Series对象

调用Series()构造函数,把要存放在Series对象中的数据以数组形式传入,就能创建一个如图4-1所示的Series对象。

1 | >>>s=pd.5eries([12,-4,7,9]) |

从 Series的输出可以看到,左侧index是一列标签,右侧是标签对应的元素。

声明Series时,若不指定标签,pandas默认使用从0开始依次递增的数值作为标签。这种情况下,标签与Series对象中元素的索引(在数组中的位置)一致。

然而,最好使用有意义的标签,用以区分和识别每个元素,而不用考虑元素插入到Series中的顺序。

因此,调用构造函数时,就需要指定index选项,把存放有标签的数组赋给它,其中标签为字符串类型。

1 | s=pd.Series([12,-4,7,9],index=['a','b','c','d']) |

如果想分别查看组成Series对象的两个数组,可像下面这样调用它的两个属性:index(索引)和values(元素)。

1 | >>>s.values |

2. 选择内部元素

若想获取Series对象内部的元素,把它作为普通的NumPy数组,指定键即可。

1 | s[2] |

或者,指定位于索引位置处的标签。

1 | s['b'] |

跟从NumPy数组选择多个元素的方法相同,可像下面这样选取多项:

1 | >>>s[0:2] |

这种情况甚至可以用元素对应的标签,只不过要把标签放到数组中:

1 | >>>s[['b','c']] |

3. 为元素赋值

理解了单个元素的选取方法,赋值方法也就不言自明。可以用索引或标签选取元素后进行赋值。

1 | >>>s[1]=0 |

4. 用NumPy数组或其他Series 对象定义新Series 对象

可以用NumPy数组或现有的Series对象定义新的Series对象。

1 | arr=np.array([1,2,3,4]) |

请注意,新Series对象中的元素不是原NumPy数组或Series对象元素的副本,而是对它们的引用。也就是说,这些对象是动态插入到新 Series对象中。如果改变原有对象元素的值,新Series对象中这些元素也会发生改变。

1 | s3 |

上述例子,改动arr数组第3个元素的值,同时也会修改Series对象s3中相应的元素。

5. 筛选元素

pandas库的开发是以NumPy库为基础的,因此就数据结构而言,NumPy数组的多种操作方法得以扩展到Series对象中,其中就有根据条件筛选数据结构中的元素这一方法。

若要获取Series对象中所有大于8的元素,可使用以下代码:

1 | >>>s[s>8] |

6. Series 对象运算和数学函数

适用于NumPy数组的运算符(+、-、*和/)或其他数学函数,也适用于Series对象。

至于运算符,直接用来编写算术表达式即可。

1 | >>>s/2 |

然而,至于NumPy库的数学函数,必须指定它们的出处np,并把Series实例作为参数传入。

1 | >>>np.log(s) |

7. Series 对象的组成元素

Series对象往往包含重复的元素,你很可能想知道里面都包含哪些元素,统计元素重复出现的次数或判断一个元素是否在Series中。

首先声明一个包含多个重复元素的Series对象。

1 | >>>serd=pd.Series([1,0,2,1,2,3],index=['white', 'white', 'blue', 'green', 'green', 'yellow']) |

要弄清楚Series对象包含多少个不同的元素,可使用unique()函数。其返回结果为一个数组,包含Series去重后的元素,但顺序可能不同。

1 | >>>serd.unique() |

跟unique()函数相似的另外一个函数是value_counts()函数,它不仅返回各个元素,还计算每个元素在Series中的出现次数。

1 | >>>serd.value_counts() |

最后,isin()函数用来判断所属关系,也就是判断给定的一列元素是否包含在数据结构之中。isin()函数返回布尔值,可用于筛选 Series或DataFrame列中的数据。

1 | >>>serd.isin([0,3]) |

8. NaN

前面的一个例子求负数的对数,返回结果为NaN(Not a Number,非数值)。数据结构中若字段为空或者不符合数字的定义时,用这个特定的值来表示。

通常NaN值表示数据有问题,必须对其进行处理,尤其是在数据分析时。从有问题的数据源抽取数据,或者数据源缺失数据,往往就会产生这类数据。进一步来讲,计算负数的对数,执行计算或函数时出现异常等特定情况,也可能产生这类数据。后续章节会讲解 NaN值的几种处理方法。

尽管NaN值是数据有问题才产生的,然而在pandas中是可以定义这类数据,并把它添加到Series等数据结构中的。创建数据结构时,可为数组中元素缺失的项输入np.NaN。

1 | s2=pd.Series([5,-3,np.NaN,14]) |

isnul1()和 notnul1()函数用来识别没有对应元素的索引时非常好用。

1 | >>>s2.isnull() |

上述两个函数返回两个由布尔值组成的Series对象,其元素值是True还是False取决于原Series对象的元素是否为NaN。如果是NaN,isnul1()函数返回值为True;反之,如果不是NaN,notnul1()函数返回值为True。这两个函数常用作筛选条件。

1 | >>>s2[s2.notnull()] |

9. Series 用作字典

还可以把Series对象当作字典(dict,dictionary)对象来用。定义Series对象时,就可以利用这种相似性。实际上,可以用事先定义好的字典来创建Series对象。

1 | mydict = {'red': 2000, 'blue': 1000, 'yellow':500,'orange': 1000} |

上述例子中,索引数组用字典的键来填充,每个索引所对应的元素为用作索引的键在字典中对应的值。还可以单独指定索引,pandas会控制字典的键和数组索引标签之间的相关性。若遇缺失值处,pandas就会为其添加NaN。

1 | colors = ['red', 'yellow', 'orange', 'blue', 'green'] |

10. Series 对象之间的运算

前面讲过Series对象和标量之间的数学运算,Series对象之间也可以进行这类运算,甚至标签也可以参与运算。

实际上,Series这种数据结构在运算时有一大优点,它能通过识别标签对齐不一致的数据。

下面这个例子求只有部分元素标签相同的两个Series对象之和。

1 | mydict2 = {'red' :400, 'yellow' :1000, 'black':700} |

上述运算得到一个新Series对象,其中只对标签相同的元素求和。其他只属于任何一个Series 对象的标签也被添加到新对象中,只不过它们的值均为NaN。

4.5.2 DataFrame 对象

DataFrame 这种列表式数据结构跟工作表(最常见的是Excel工作表)极为相似,其设计初衷是将Series的使用场景由一维扩展到多维。DataFrame由按一定顺序排列的多列数据(见图4-2)组成,各列的数据类型可以有所不同(数值、字符串或布尔值等)。

图4-2 DataFrame数据结构

Series对象的索引数组存放有每个元素的标签,而DataFrame 对象则有所不同,它有两个索引数组。第1个数组与行相关,它与Series的索引数组极为相似。每个标签与标签所在行的所有元素相关联。而第2个数组包含一系列列标签,每个标签与一列数据相关联。

DataFrame 还可以理解为一个由 Series组成的字典,其中每一列的名为字典的键,形成DataFrame的列的Series作为字典的值。具体而言,每个Series的所有元素映射到叫作index的标签数组。

1.定义DataFrame 对象

新建DataFrame对象的最常用方法是传递一个dict对象给DataFrame()构造函数。dict对象以每一列的名称作为键,每个键都有一个数组作为值。

1 | >>>data = {'color' : ['blue', 'green', 'yellow','red', 'white'], |

如果用来创建DataFrame对象的dict对象包含一些用不到的数据,可以只选择自己感兴趣的。在DataFrame构造函数中,用columns选项指定需要的列即可。新建的DataFrame各列顺序与你指定的列顺序一致,而与它们在dict对象中的顺序无关。

1 | >>>frame2 =pd.DataFrame(data,columns=['object','price']) |

DataFrame 对象跟 Series类似,如果index数组没有明确指定标签,pandas也会自动为其添加一列从0开始的数值作为索引。如果想用标签作为DataFrame的索引,则要把标签放到数组中,赋给 index选项。

1 | >>frame2 = pd.DataFrame(data,index=['one','"two",'three','four','five']) |

既已引入两个新选项index和columns,还可以想出一种定义DataFrame的新方法。我们不再使用dict对象,而是定义一个构造函数,按如下顺序指定3个参数:数据矩阵、index选项和columns 选项。记得将存放有标签的数组赋给 index选项,将存放有列名称的数组赋给 columns 选项。

本书后续很多例子会体现,要想便捷地创建包含数据的矩阵,可以使用 np.arange(16).reshape((4,4))生成一个4x4型、包含数字0~15的矩阵。

1 | >>>frame3 = pd.DataFrame(np.arange(16).reshape((4,4)), |

2.选取元素

如果想知道DataFrame对象所有列的名称,在DataFrame对象实例上调用columns属性即可。

1 | >>>frame.columns |

类似地,要获取索引列表,调用index属性即可。

1 | >>>frame.index |

如果要获取存储在数据结构中的所有元素,可以使用values属性。

1 | >>>frame.values |

或者,如果只想选择一列内容,把这一列的名称作为索引即可。

1 | >>>frame['price'] |

如上所示,返回值为Series对象。另一种方法是用列名称作为DataFrame实例的属性。

1 | >>>frame.price |

至于DataFrame中的行,用loc属性和行的索引值就能获取。

1 | >>>frame.loc[2] |

返回结果同样是一个Series对象,其中列的名称已经变为索引数组的标签,而列中的元素变为Series的数据部分。

用一个数组指定多个索引值就能选取多行:

1 | >>>frame.loc[[2,4]] |

若要从DataFrame 抽取一部分,可以用索引值选择你想要的行。其实可以把一行看作DataFrame的一部分,通过指定索引范围来选取,其中这一行的索引作为起始索引值(下面例子中的0),下一行的索引作为结束索引(下面例子中的1)。

1 | >>>frame[0:1] |

如上,返回结果为只包含一行数据的DataFrame对象。如需多行,必须扩展选择范围。

1 | >>>frame[1:3] |

最后,若要获取存储在DataFrame中的一个元素,需要依次指定元素所在的列名称、行的索引值或标签。

1 | >>>frame['object'][3] |

3.赋值

一旦掌握了获取组成DataFrame的各元素的方法,依照相同的逻辑就能增加或修改元素。

例如前面讲过用 index属性指定DataFrame结构中的索引数组,用columns属性指定包含列名称的行。还可以用name属性为这两个二级结构指定标签,便于识别。

1 | >>>frame.index.name='id' |

灵活程度非常高是pandas 数据结构的一大优点。实际上,可以在任何层级修改它们的内部结构。例如执行添加一列新元素这类常规操作。

添加列的方法很简单,指定DataFrame实例新列的名称,为其赋值即可。

1 | >>>frame['new']= 12 |

从结果可以看出,DataFrame新增了名为“new”的一列,它的各个元素均为12。然而,如果想更新一列的内容,需要把一个数组赋给这一列。

1 | >>>frame['new']= [3.0,1.3,2.2,0.8,1.1] |

如果想更新某一列的全部数据,方法类似。例如借助np.arange()函数预先定义一个序列,用它更新某一列的所有元素。

为DataFrame的各列赋一个Series对象也可以创建DataFrame,例如使用np.arange()函数生成一个递增序列。

1 | >>>ser=pd.1Series(np.arange(5)) |

最后介绍修改单个元素的方法:选择元素,为其赋新值即可。

1 | >>>frame['price'][2]=3.3 |

4.元素的所属关系

前面讲过用isin()函数判断一组元素是否属于Series对象,其实该函数对DataFrame对象也适用。

1 | frame.isin([1.0,'pen']) |

这样就得到了一个只包含布尔值的DataFrame对象,其中只有满足从属关系的元素为True。若把上述返回结果作为条件,将得到一个新DataFrame,其中只包含满足条件的元素。

1 | >>>frame[frame.isin([1.0,'pen'])] |

5.删除一列

若想删除一整列的所有数据,可用del命令。

1 | >>>del frame['new'] |

6.筛选

对于DataFrame对象,也可以通过指定条件筛选元素。例如获取所有小于指定数字(比如1.2)的元素。

1 | >>>frame[frame<1.2] |

返回的DataFrame对象只包含所有小于1.2的数字,各元素的位置保持不变。其他不符合条件的元素被替换为NaN。

7.用嵌套字典生成DataFrame 对象

嵌套字典是Python广泛使用的数据结构,示例如下:

1 | nestdict = {'red':{2012: 22,2013:33}, |

直接将这种数据结构作为参数传递给 DataFrame()构造函数,pandas就会将外部的键解释成列名称,将内部的键解释为用作索引的标签。

解释嵌套结构时,可能并非所有位置都有相应的元素存在。pandas会用NaN填补缺失的元素。

1 | >>>nestdict ={'red':{2012: 22,2013:33}, |

8. DataFrame转置

处理表格型数据时可能会用到转置操作(列变为行,行变为列)。pandas提供了一种很简单的转置方法。调用T属性就能得到DataFrame对象的转置形式。

1 | >>>frame2.T |

4.5.3 Index 对象

前面介绍了 Series、DataFrame对象及其结构形式,以及这些数据结构的特性。实际上,它们在数据分析方面的大多数优秀特性都取决于完全整合到这些数据结构中的Index对象。

轴标签或其他用作轴名称的元数据就存储为Index对象。前面讲过如何把存储多个标签的数组转化为Index对象:指定构造函数的index选项。

1 | >>>ser=pd.Series([5,0,3,8,4],,index=['red' , 'blue' , 'yellow', 'white', 'green']) |

跟 pandas数据结构(Series和DataFrame)中其他元素不同的是,Index对象不可改变。声明后,它不能改变。不同数据结构共用Index对象时,该特性能保证它的安全。

每个Index对象都有很多方法和属性,当想知道它们所包含的值时,这些方法和属性非常有用。

1.Index对象的方法

Index对象提供了几种方法,可用来获取数据结构索引的相关信息。例如idmin()和idmax()函数分别返回索引值最小和最大的元素。

1 | >>>ser.idxmin() |

2.含有重复标签的Index

前面介绍过的所有索引都是位于一个单独的数据结构中,且所有标签都是唯一的。虽然只有满足这个条件,很多函数才能运行,但是对pandas数据结构而言,这个条件并不是必需的。

例如定义一个含有重复标签的Series。

1 | >>>serd=pd.Series(range(6),index=['white','white',, 'blue', 'green', 'green','yellow']) |

从数据结构中选取元素时,如果一个标签对应多个元素,将得到一个Series对象而不是单个元素。

1 | >>>serd['white'] |

以上逻辑适用于索引中存在重复项的DataFrame,其返回结果为DataFrame对象。

数据结构很小时,识别索引的重复项很容易,但随着数据结构逐渐增大,难度也在增加。pandas的Index对象还有is_unique属性。调用该属性,就可以知道数据结构(Series和 DataFrame)中是否存在重复的索引项。

1 | >>>serd.index.is_unique |

4.6 索引对象的其他功能

与Python常用数据结构相比,pandas不仅利用了NumPy数组的高性能优势,还整合了索引机制。

最终事实证明,这样做颇有几分成效。实际上,虽然已有的动态数据结构极为灵活,但在结构中增加诸如标签这样的内部索引机制,使得开发人员可以更简单、直接地操作这些数据结构。

下面详细讲解几种使用索引机制实现的基础操作。

- 更换索引

- 删除

- 对齐

4.6.1 更换索引

前面讲过,数据结构一旦声明,Index 对象就不能改变。这么说一点也没错,但是执行更换索引操作就可以解决这个问题。

实际上,重新定义索引之后,就能用现有的数据结构生成一个新的数据结构。

1 | ser=pd.Series([2,5,7,4],index=['one','two','three','four']) |

pandas的 reindex()函数可更换 Series对象的索引。它根据新标签序列,重新调整原 Series 的元素,生成一个新的Series对象。

更换索引时,可以调整索引序列中各标签的顺序,删除或增加新标签。若增加新标签,pandas 会添加NaN作为其元素。

1 | ser.reindex(['three','four', 'five','one']) |

从返回结果可以看到,标签顺序全部调整过。删除了标签two及其元素,增加了新标签five。

然而,重新编制索引,定义所有的标签序列可能会很麻烦,对大型DataFrame来说更是如此。但是可以使用自动填充或插值方法。

为了更好地理解自动编制索引功能,首先定义以下Series对象。

1 | >>>ser3=pd.5eries([1,5,6,3],index=[0,3,5,6]) |

刚定义的Series对象,其索引列并不完整而是缺失了几个值(1、2和4)。常见的需求为插值,以得到一个完整的序列。方法是用 reindex()函数,method 选项的值为ffill。此外,还需要指定索引值的范围。要指定一列0~5的值,参数为range(6)。

1 | >>>ser3.reindex(range(6), method='ffill') |

由结果可见,新Series对象添加了原Series对象缺失的索引项。新插入的索引项,其元素为前面索引编号比它小的那一项的元素,所以索引项1、2的值为1,也就是索引项0的值。

如果想用新插入索引后面的元素,需要使用bfill方法。

1 | >>>ser3.reindex(range(6), method='bfill') |

用这种方法,索引项1和2的元素则为5,也就是索引项3的元素。

更换索引的概念可以由Series扩展到DataFrame,不仅可以更换索引(行),还可以更换列,甚至更换两者。如前所述,可以增加行或列,对于原数据结构中缺失的元素,pandas用NaN进行填充。

1 | >>frame.reindex(range(5), method='ffill',columns=['colors', 'price', 'new', 'object']) |

4.6.2 删除

另一种跟Index对象相关的操作是删除。因为索引和列名称有了标签作为标识,所以删除操作变得很简单。

pandas专门提供了一个用于删除操作的函数:drop(),它返回不包含已删除索引及其元素的新对象。

例如想从Series对象中删除一项,首先定义一个含有4个元素的Series对象,其中各元素标签均不相同。

1 | >>>ser=pd.Series(np.arange(4.),index=['red','blue','yellow','white']) |

假如想删除标签为yellow的这一项。用标签作为drop()函数的参数,就可以删除这一项。

1 | >>ser.drop('yellow') |

传入一个由多个标签组成的数组,可以删除多项。

1 | >>>ser.drop(['blue','white']) |

要删除 DataFrame中的元素,需要指定元素两个轴的轴标签。下面举例说明,首先声明一个DataFrame对象。

1 | >>>frame = pd.DataFrame(np.arange(16).reshape((4,4)), |

传入行的索引可删除行。

1 | frame.drop(['blue','yellow']) |

要删除列,需要指定列的索引,但是还必须用 axis选项指定从哪个轴删除元素。如果按照列的方向删除,axis的值为1。

1 | >>>frame.drop(['pen','pencil'],axis=1) |

4.6.3 算术和数据对齐

pandas 能将两个数据结构的索引对齐,这可能是与pandas数据结构索引对象有关的最强大的功能。这一点尤其体现在数据结构之间的算术运算上。参与运算的两个数据结构,其索引项顺序可能不一致,而且有的索引项可能只存在于一个数据结构中。

从下面几个例子中可以发现,进行算术运算时,pandas很擅长对齐不同数据结构的索引项。例如首先定义两个Series对象,分别指定两个不完全一致的标签数组。

1 | >>>s1= pd.Series([3,2,5,1],['white', 'yellow', 'green', 'blue']) |

算术运算种类很多,考虑一下最简单的求和运算。刚定义的两个Series对象,有些标签两者都有,有些只属于其中一个对象。如果一个标签,两个Series对象都有,就把它们的元素相加,反之,标签也会显示在结果(新Series对象)中,只不过元素为NaN。

1 | >>>s1+s2 |

DataFrame 对象之间的运算,虽然看起来可能更复杂,但对齐规则相同,只不过行和列都要执行对齐操作。

frame1=pd.DataFrame(np.arange(16)..reshape((4,4))

··· index=[‘red’, ‘blue’, ‘yellow’, ‘white’],

… columns=[‘ball’, ‘pen’, ‘pencil’, ‘paper])

frame2 = pd.DataFrame(np.arange(12).reshape((4,3)),

··· index=[‘blue’, ‘green’, ‘white’,’yellow’],

··· columns=[‘mug’,’pen’,’ball’])

frame1

ball pen pencil paper

red 0 1 2 3

blue 4 5 6 7

yellow 8 9 10 11

white 12 13 14 15

frame2

mug pen ball

blue 0 1 2

green 3 4 5

white 6 7 8

yellow 9 10 11

frame1 +frame2

ball mug paper pen pencil

blue 6.0 NaN NaN 6.0 NaN

green NaN NaN NaN NaN NaN

red NaN NaN NaN NaN NaN

white 20.0 NaN NaN 20.0 NaN

yellow 19.0 NaN NaN 19.0 NaN

4.7 数据结构之间的运算

前面介绍了Series和DataFrame等数据结构,以及针对它们的多种基本操作,下面讲解两种及以上数据结构之间的运算。

前面介绍了两个对象之间的算术运算。下面详细介绍两种数据结构之间的运算。

4.7.1 灵活的算术运算方法

前面讲过可直接在pandas数据结构之间使用算术运算符。相同的运算还可以借助灵活的算术运算方法来完成。

- add()

- sub()

- div()

- mul()

这些函数的调用方法与数学运算符的使用方法不同。例如两个DataFrame对象的求和运算,不再使用“frame1+frame2”这种格式,而是使用下面这种格式:

1 | >>>frame1.add(frame2) |

如上所示,结果跟使用+运算符所得到的相同。此外,如果两个DataFrame 对象的索引和列名称差别很大,新得到的DataFrame对象将有很多元素为NaN。本章后面会讲到这类数据的处理方法。

4.7.2 DataFrame和Series对象之间的运算

再次回到算术运算符,pandas允许参与运算的对象为不同的数据结构,比如 DataFrame 和Series。举例之前,首先定义两个数据结构。

1 | >>>frame =pd.DataFrame(np.arange(16).reshape((4,4)), |

定义数据结构时,特意让Series对象的索引和DataFrame对象的列名称保持一致。这样就可以直接对它们执行运算。

1 | >>>frame - ser |

如上所示,DataFrame对象各元素分别减去了Series对象中索引与之相同的元素。DataFrame 对象每一列的所有元素,无论对应哪一个索引项,都执行了减法操作。

如果一个索引项只存在于其中一个数据结构之中,则运算结果中会为该索引项生成一列,只不过该列的所有元素都是NaN。

1 | >>>ser['mug'] = 9 |

4.8 函数应用和映射

本节将讲解pandas库函数。

4.8.1 操作元素的函数

pandas 库以 NumPy为基础,并对它的很多功能进行了扩展,以用来操作新数据结构 Series 和DataFrame。通用函数(ufunc,universal function)就是经过扩展得到的功能,这类函数能对数据结构中的元素进行操作,因此特别有用。

1 | >>>frame = pd.DataFrame(np.arange(16).reshape((4,4)), |

例如使用NumPy的np.sqrt()函数就能计算DataFrame对象每个元素的平方根。

1 | >>>np.sqrt(frame) |

4.8.2 按行或列执行操作的函数

除了通用函数,用户还可以自己定义函数。需要注意的是这些函数对一维数组进行运算,返

回结果为一个数值。例如可以定义一个计算数组元素取值范围的lambda函数。

1 | f = lambdax:x.max()-x,min()-x,min()() |

还可以用下面这种形式定义函数:

1 | >>>def f(x): |

用apply()函数可以在DataFrame对象上调用刚定义的函数。

1 | >>>frame.apply(f) |

然而,每一列的运算结果为一个数值。如果想用函数处理行而不是列,需将axis 选项设置为1。

1 | >>>fame.apply(f,axis=1) |

apply()函数并不是一定要返回一个标量,它还可以返回 Series对象,因而可以借助它同时执行多个函数。每调用一次函数,就会有两个或两个以上的返回结果。可以像下面这样指定一个函数。

1 | >>>def f(x) |

像之前一样,应用这个函数,但是返回结果不再是Series而是DataFrame对象,并且DataFrame 对象的行数跟函数返回值的数量相等。

1 | >>>frame.apply(f) |

4.8.3 统计函数

数组的大多数统计函数对DataFrame 对象依旧有效,因此没有必要使用apply()函数。例如sum()和mean()函数分别用来计算 DataFrame对象元素之和及它们的均值。

1 | >>>frame.sum() |

describe()函数能计算多个统计量。

1 | >>>frame.describe() |

4.9 排序和排位次

另外一种使用索引机制的基础操作是排序(sorting)。对数据进行排序通常为必要操作,因此简化它的实现非常重要。pandas的sort_index()函数返回一个跟原对象元素相同但顺序不同的新对象。

首先看一下Series对象各项的排序方法。要排序的索引只有一列,因此操作很简单。

1 | >>>ser=pd.Series([5,0,3,8,4], |

输出结果中,各元素按照以字母表顺序升序排列(A~Z)的标签排序。这是默认的排序方法,但若指定ascending选项,将其值置为False,则可按照降序排列。

1 | >>>ser.sort_index(ascending=False) |

对于DataFrame对象,可分别对两条轴中的任意一条进行排序。如果要根据索引对行进行排序,可依旧使用SOrtindex()函数,不用指定参数,前面已经讲过;如果要按列进行排序,则需要指定axis选项,其值为1。

1 | >>>frame = pd.DataFrame(np.arange(16)..reshape((4,4)) |

至此,已经讲解了根据索引进行排序的方法。但往往还需要对数据结构中的元素进行排序,对于这个问题,Series和DataFrame对象有所不同,要区别对待。

对Series对象排序,使用sort_values()函数。

1 | >>>ser.sort_values() |

对DataFrame对象排序,使用前面用过的sort_values()函数,只不过要用by选项指定根据哪一列进行排序。

1 | >>>frame.sort_values(by='pen') |

如果要基于两列或更多的列进行排序,则把这些列的名称放到数组中,赋给by选项。

1 | frame.sort_values(by=['pen','pencil']) |

排位次操作(ranking)跟排序操作紧密相关,该操作为序列的每个元素安排一个位次(初始值为1,依次加1),位次越靠前,所使用的数值越小。

1 | >>>ser.rank() |

还可以把数据在数据结构中的顺序(没有进行排序操作)作为它的位次。只要使用 method 选项把first赋给它即可。

1 | >>>ser.rank(method='first') |

默认位次使用升序。要按照降序排列,就把ascending选项的值置为False。

1 | >>>ser.rank(ascending=False) |

4.10 相关性和协方差

相关性(correlation)和协方差(covariance)是两个重要的统计量,pandas计算这两个量的函数分别是corr()和 cov()。这两个量的计算通常涉及两个Series对象。

1 | >>>seq2=pd.Series([3,4,3,4,5,4,3,2],['2006','2007','2008', |

还可以计算单个DataFrame对象的相关性和协方差,返回结果为新DataFrame对象形式的矩阵。

1 | >>>frame2=pd.DataFrame([[1,4,3,6],[4,5,6,1],[3,3,1,5],[4,1,6,4]], |

用corrwith()方法可以计算DataFrame对象的列或行与Series对象或其他DataFrame 对象元素两两之间的相关性。

1 | >>>ser =pd.Series([0,1,2,3,9], |

4.11 NaN数据

由前几节可知,补上缺失的数值很容易,它们在数据结构中用NaN来表示,以便于识别。在数据分析过程中,有些元素在某个数据结构中没有定义,这种情况很常见。

pandas意在更好地管理这种可能出现的情况。实际上,本节将讲解缺失值的处理方法,这样许多问题就可以避免。比如pandas库在计算各种描述性统计量时,其实没有考虑NaN值。

4.11.1 为元素赋NaN值

有时需要专门为数据结构中的元素赋NaN值,这时用NumPy的np.NaN(或np.nan)即可。

1 | >>>Ser=pd.Series([0,1,2,np.NaN,9], |

4.11.2 过滤NaN

数据分析过程中,有几种去除NaN的方法。然而,手动逐一删除NaN元素很麻烦,也很不安全,无法确保删除了所有的NaN,而dropna()函数有助于解决这个问题。

1 | >>>ser.dropna() |

另一种方法是,用notnul1()函数作为选取元素的条件,实现直接过滤。

1 | >>>ser[ser.notnull()] |

DataFrame 处理起来要稍微复杂点。如果对这类对象使用dropna()函数,只要行或列有一个NaN元素,该行或列的全部元素都会被删除。

1 | >>>frame3 = pd.DataFrame([[6,np.nan,6],[np.nan,np.nan,np.nan],[2,np.nan,5]], |

因此,为了避免删除整行或整列,需使用how选项,指定其值为all,告知dropna()函数只删除所有元素均为NaN的行或列。

1 | >>>frame3.dropna(how='all') |

4.11.3 为NaN元素填充其他值

删除NaN元素,可能会删除跟数据分析相关的其他数据,所以与其冒着风险去过滤NaN元素,不如用其他数值替代NaN。fillna()函数能满足大多数需要。这个函数以替换NaN的元素作为参数。所有NaN可以替换为同一个元素,如下所示:

1 | >>>frame3.fillna(0) |

或者,若要将不同列的NaN替换为不同的元素,依次指定列名称及要替换成的元素即可。

1 | >>>frame3.fillna({'ball':1, 'mug':0, 'pen':99}) |

4.12 等级索引和分级

等级索引(hierarchical indexing)是pandas的一个重要功能,单条轴可以有多级索引。可以像操作两维结构那样处理多维数据。

举个简单的例子:创建包含两列索引的Series对象,即创建一个包含两层的数据结构。

1 | >>>mser=pd.Series(np.random.rand(8) |

通过指定等级索引,二级元素的选取操作得以简化。

其实可以选取第1列索引中某一索引项的元素,使用最经典的做法即可。

1 | >>>mser['white'] |

或者像下面这样,选取第2列索引中某一索引项的元素。

1 | mser[:,'up'] |

若要选取某个元素,指定两个索引即可,很直观吧?

1 | mser['white','up'] |

等级索引在调整数据形状和进行基于组的操作(比如创建数据透视表)方面起着非常重要的作用。例如可以用一个特殊函数 unstack()调整数据并将其用于DataFrame。这个函数把使用的等级索引Series对象转换为一个简单的DataFrame对象,其中把第2列索引转换为相应的列。

1 | >>>mser.unstack() |

如果想进行逆操作,把DataFrame对象转换为Series对象,可使用stack()函数。

1 | frame |

对于DataFrame对象,可以为它的行和列都定义等级索引。声明DataFrame对象时,为index 选项和 columns 选项分别指定一个元素为数组的数组。

1 | >>>mframe = pd.DataFrame(np.random.randn(16).reshape(4,4) |

4.12.1 重新调整顺序和为层级排序

有时需要调整某一条轴上各层级的顺序或者调整某一层中各元素的顺序。

swaplevel()函数以要互换位置的两个层级的名称为参数,返回交换位置后的一个新对象,其中各元素的顺序保持不变。

1 | >>>mframe.columns.names= ['objects','id'] |

而sort_index()函数只根据所指定的某个层级将数据排序。

mframe.sort_index(level=’colors’)

objects objects pen paper id 1 2 1 2 colors status red down 2.668155 0.528971 -1.633708 0.921735 up -1.561761 1.225509 -0.244772 0.345843 white down -1.886825 1.700858 -1.060846 -0.197669 up -1.964055 1.312100 -0.914750 -0.941930

4.12.2 按层级统计数据

DataFrame或Series对象的很多描述性和概括统计量都有level选项,可用它指定要获取哪个层级的描述性和概括统计量。

如果对行一层级进行统计,把层级的名称赋给level选项即可。

mframe.sum(level=’colors’)

objects pen paper id 1 2 1 2 colors red 1.106394 1.754480 -1.878480 1.267578 white -3.850881 3.012959 -1.975596 -1.139599

若想对某一层级的列进行统计,例如id,则需要把axis选项的值设置为1,把第2条轴作为参数。

mframe.sum(level=’id’, axis=1)

| id | | 1 | | 2 |

| colors | status | | | |

| white | up | -2.87880 | 6 | 0.370170 |

| | down | -2.94767 | 2 | 1.503189 |

| red | up | -1.806532 | | 1.571352 |

| | down | 1.034447 | | 1.450706 |

4.13 小结

本章介绍了pandas库、它的安装方法及特点。

然后介绍了它的两种基础数据结构Series和DataFrame,及其操作方法和主要特点,尤其是这两种结构索引机制的重要性以及它们的最佳操作方法。最后展示了通过创建层级索引扩展这两种数据结构,以按照不同的次级层级分发其中的数据。

下一章将介绍从文件等外部数据源获取数据和把分析结果写入文件的方法。

第5章 pandas:数据读写

上一章介绍了pandas库及其用于分析数据的基础功能,还提到了DataFrame和Series是这个库的核心,数据处理、计算和分析都是围绕它们展开的。

本章将介绍 pandas从多种存储媒介(比如文件和数据库)读取数据的工具,还将介绍直接将不同的数据结构写入不同格式文件的方法,而无须过多考虑所用技术。

本章主要介绍pandas的多种I/OAPI函数,它们可直接将数据作为DataFrame对象进行读写。首先会介绍文本文件的读写,随后逐步过渡到更加复杂的二进制文件。

本章最后将讲解SQL和NoSQL常用数据库的连接方法,举例说明如何直接把DataFrame中的数据存储到数据库中,还会介绍如何从数据库读取数据,存储为DataFrame对象,并从中检索内容。

5.1 I/O API 工具

pandas是数据分析专用库,因此可以想见,它主要关注数据计算和处理。此外,从外部文件读写数据也被视作数据处理的一部分。实际上,正如后面会讲到的,即使在这个阶段,也可以对数据做一定的处理,为后续分析数据做好准备。

因此,数据读写对数据分析很重要,于是pandas库必须为此提供专门的工具-一组被称为I/OAPI的函数。这些函数分为完全对称的两大类:读取函数和写入函数。

| 读取函数 | 写入函数 |

|---|---|

| read_csv | to_csV |

| read_excel | to_excel |

| read_hdf | $t o h d f$ |

| read_json | to_json |

| read_sql | to_sql |

| read_html | to_html |

| read_clipboard | to_clipboard |

| read_stata | to_stata |

| read_clipboard | to_clipboard |

| read_pickle | to_pickle |

| read_msgpack | to_msgpack |

| read_gbq | to_gbq |

5.2 CSV和文本文件

多年来,人们已习惯了文本文件的读写,特别是列表形式的数据。如果文件每一行的多个元素是用逗号隔开的,则这种格式叫作CSV,这可能是最广为人知和最受欢迎的格式。

其他由空格或制表符分隔的列表数据通常存储在各种文本文件中(扩展名通常为.txt)。

因此这种文件类型是最常见的数据源,它易于转录和解释。pandas的下列函数专门用来处理这种文件类型:

- read_csv

- read_table

- to_csv

5.3 读取CSV或文本文件中的数据

根据一般经验,对数据分析人员来说,最常执行的操作是从CSV文件或其他类型的文本文件中读取数据。

动手处理文件之前,需要先导入以下两个库:

1 | >>>import numpy as np |

为了说明pandas处理这类数据的方法,在工作目录下创建一个短小的CSV文件,将其保存为ch05_01.csv,如代码清单5-1所示。

代码清单5-1 ch05_01.csv

white,red,blue,green,animal

1,5,2,3,cat

2,7,8,5,dog

3,3,6,7,horse

2,2,8,3,duck

4,4,2,1,mouse

这个文件以逗号作为分隔符,因此可以用read_csv()函数读取它的内容,同时将其转换为DataFrame 对象。

1 | >>>csvframe =pd.read_csv('ch05_01.csv') |

| white | red | blue | green | animal | |

|---|---|---|---|---|---|

| 0 | 1 | 5 | 2 | 3 | cat |

| 1 | 2 | 7 | 8 | 5 | dog |

| 2 | 3 | 3 | 6 | 7 | horse |

| 3 | 2 | 2 | 8 | 3 | duck |

| 4 | 4 | 4 | 2 | 1 | mouse |

如上所示,读取CSV文件中的数据很简单。CSV文件中的数据为列表数据,位于不同列的元素用逗号隔开。既然CSV文件被视作文本文件,因此可以用read_table()函数,但是需要指

定分隔符。

1 | >>>pd.read_table('cho5_01.csv',sep=',') |

| white | red | blue | green | animal | |

|---|---|---|---|---|---|

| O | 1 | 5 | 2 | 3 | cat |

| 1 | 2 | 7 | 8 | 5 | dog |

| 2 | 3 | 3 | 6 | 7 | horse |

| 3 | 2 | 2 | 8 | 3 | duck |

| 4 | 4 | 4 | 2 | 1 | mouse |

从上述例子可知,标识各列名称的表头位于CSV文件的第1行,但通常并非如此,往往CSV 文件的第1行就是列表数据(见代码清单5-2)。

代码清单5-2 ch05_02.csv

1,5,2,3,cat

2,7,8,5,dog

3,3,6,7,horse

2,2,8,3,duck

4,4,2,1,mouse

1 | >>>pd.read_csv('ch05_02.csv') |

对于没有表头这种情况,用header选项,将其值置为None,pandas会添加默认表头。

1 | >>>pd.read_csv('ch05_02.csv',header=None) |

此外,还可以用names选项指定表头,直接把存有各列名称的数组赋给它。

1 | >>>pd.read_csv('cho5_02.csv', names=['id', 'white', 'red', 'blue', 'green', 'animal']) |

考虑一下更复杂的情况,假如想读取CSV文件,创建一个具有等级结构的DataFrame对象。为此,可以添加index_col选项,扩展readcsv()函数的功能,把所有想转换为索引的列名称赋给index_col。

为了更好地理解这种可能性,新建一个CSV文件,其中有两列将用作等级索引。然后,将其保存到工作目录,文件名为ch05_03.csv(见代码清单5-3)。

代码清单5-3 ch05_03.csv

color,status,item1,item2,item3

black,up,3,4,6

black,down,2,6,7

white,up,5,5,5

white,down,3,3,2

white,left,1,2,1

red,up,2,2,2

red,down,1,1,4

1 | >>>pd.read_csv('cho5_03.csv',index_col=['color', 'status']) |

5.3.1 用RegExp解析TXT文件

有时要解析的数据文件不是以逗号或分号分隔的。对于这种情况,正则表达式就能派上用场。可以使用sep 选项指定正则表达式,在read_table()函数内使用。

为了更好地理解正则表达式的用法,以及用它分隔多个元素的方法,可以从简单的例子入手。比如一个TXT文件,它里面的元素是以空格或制表符分隔的,且没有规律可言。在这种情况下,只有用正则表达式才能兼顾两种分隔符。可以使用通配符\s*。\s匹配空格或制表符(若只匹配制表符,可使用\t),星号表示这些字符可能有多个(其他常用通配符请见表5-1),即相邻元素之间是由多个空格或制表符隔开的。

表5-1 元字符

| 元字符 | 说明 |

|---|---|

| . | 换行符以外的单个字符 |

| \s | 空格或制表符 |

| \S | 空格或制表符以外的字符 |

| \d | 数字 |

| \D | 非数字 |

| \n | 换行符 |

| ^ | 行首 |

| $ | 行尾 |

| [] | 字符集 |

举一个极端的例子,所有元素随机以制表符或空格分隔(见代码清单5-4)。

代码清单5-4 ch05_04.txt

white red blue green

1 5 2 3

2 7 8 5

3 3 6 7

1 | >>>pd.read_table('ch05_04.txt',sep='\s+',engine='python') |

如上所示,得到了一个完美的DataFrame对象,其中所有元素均处在正确的位置。

接下来这个例子看起来有点奇怪或不寻常,但其实并不罕见。该例子非常有助于理解正则表达式潜在的强大功能。通常可以把逗号、空格和制表符等看作分隔符,但实际应用中,字母数字组合或者整数均可用作分隔符,比如数字0。

在接下来这个例子中,TXT文件中数字和字母杂糅在一起,需要从中抽取数字部分。

若TXT文件中的数据无表头,记得将header选项置为None(见代码清单5-5)。

代码清单5-5 ch05_05.txt

000END123AAA122

001END124BBB321

002END125CCC333

1 | >>>pd.read_table('ch05_05.txt',header=None,engine='python') |

另一种很常见的情况是,解析数据时把空行排除在外。文件中的表头或没有必要的注释,有时用不到(见代码清单5-6)。使用skiprows选项,可以排除多余的行。把要排除的行的行号放到数组中,赋给该选项即可。

使用该选项时,需要注意一点。若要排除前5行,需要这样写:skiprows=5;若只是排除第5行,写作skiprows=[5]。

代码清单5-6 ch05_06.txt

########### LOG FILE ############

This file has been generated by automatic system

white,red,blue,green,animal

12-Feb-2015: Counting of animals inside the house

1,5,2,3,cat

2,7,8,5,dog

13-Feb-2015: Counting of animals outside the house

3,3,6,7,horse

2,2,8,3,duck

4,4,2,1,mouse

1 | >>>pd.read_table('ch05_06.txt',sep=',',skiprows=[0,1,3,6]) |

5.3.2 从TXT文件读取部分数据

处理大文件或是只对文件部分数据感兴趣时,往往需要按照部分(块)读取文件,因为只需要部分数据。这两种情况都得使用迭代,而我们对解析整个文件不感兴趣。

举例来说,假如只想读取文件的一部分,可明确指定要解析的行号,这时要用到nrows 和skiprows选项。你可以指定起始行n(n=SkipRows)和从起始行往后读多少行(nrows=i)。

1 | >>>pd.read_csv('ch05_02.csv',skiprows=[2],nrows=3,header=None) |

另外一项既有趣又很常用的操作是切分想要解析的文本,然后遍历各个部分,逐一对其执行特定操作。

例如对于一列数字,每隔两行取一个累加起来,最后把和插入到Series对象中。这个小例子理解起来很简单,也没有实际应用价值,但是一旦领会了其原理,就能将其用于更加复杂的情况。

1 | >>>out=pd.Series() |

5.3.3 将数据写入CSV文件

从文件读取数据很常用,把计算结果或数据结构所包含的数据写入数据文件也是常用的必要操作。

例如把DataFrame中的数据写入CSV文件。写入过程,就要用到$t o _ { - } c s V ( )$函数,其参数为即将生成的文件名(见代码清单5-7)。

1 | >>>frame=pd.DataFrame(np.arange(16)..reshape((4,4)), |

打开pandas库生成的新文件ch05_07.csv,就会看到如代码清单5-7所示的数据。

代码清单5-7 ch05_07.csv

,ball,pen,pencil,paper

0,1,2,3

4,5,6,7

8,9,10,11

12,13,14,15

由上述例子可知,把DataFrame写入文件时,索引和列名称连同数据一起写入。使用index 和header选项,把它们的值设置为False,可取消这一默认行为(见代码清单5-8)。

1 | >>>frame3 = pd.DataFrame([[6,np.nan,np.nan,6,np.nan], |

代码清单 5-9 ch05_08.csv

,ball,mug,paper,pen,pencil

blue,6.0,,,6.0,

green,,,,,

red,,,,,

white,20.0,,,20.0,

yellow,19.0,,,19.0

写数据时需要注意,数据结构中的NaN写入文件后,显示为空字段(见代码清单5-9)。

1 | >>>frame3 = pd.DataFrame([[6,np.nan,np.nan,6,np.nan], |

| ball | mug | paper | pen | pencil | |

|---|---|---|---|---|---|

| blue | 6.0 | NaN | NaN | 6.0 | NaN |

| green | NaN | NaN | NaN | NaN | NaN |

| red | NaN | NaN | NaN | NaN | NaN |

| white | 20.0 | NaN | NaN | 20.0 | NaN |

| yellow | 19.0 | NaN | NaN | 19.0 | NaN |

代码清单5-9 ch05_08.csv

,ball,mug,paper,pen,pencil

blue,6.0,,,6.0,

green,,,,,

red,,,,,

white,20.0,,,20.0,

yellow,19.0,,,19.0

其实可以用to_csv()函数的na_rep选项把空字段替换为需要的值。

frame3.to_csv(‘ch05_09.csv’,na_rep=’NaN’)

代码清单5-10 ch05_09.csv

,ball,mug,paper,pen,pencil

blue,6.0,NaN,NaN,6.0,NaN

green,NaN,NaN,NaN,NaN,NaN

red,NaN,NaN,NaN,NaN,NaN

white,20.0,NaN,NaN,20.0,NaN

yellow,19.0,NaN,NaN,19.0,NaN

说明 在上述几个例子中,DataFrame一直是本书讨论的主题,因为通常需要将这种数据结构写入文件。但是,所有这些函数和选项也适用于Series。

5.4 读写HTML文件

pandas提供以下I/O API函数用于读写HTML格式的文件:

- read_html()

- tohtml()

这两个函数非常有用。把DataFrame等复杂的数据结构直接转换为HTML表格很简单,无须编写一长串HTML代码就能实现。pandas尤擅于此。该功能能给Web开发带来很多便捷。

逆操作也很有用,因为如今主要的数据源为因特网。网上的很多数据并不总是拿来就能用的,它们不是存储在TXT或CSV文件中。这些数据是网页文本的一部分,因此实现一个读取网页数据的函数非常有必要。

读取网页数据这种操作被称为网页抓取,应用极广。它逐渐演变成数据分析过程中的一项基础操作,被整合到了数据分析的第1步-数据挖掘和数据准备。

说明 如今很多网站为避免模块缺失和错误信息,已采用HTML5格式。强烈建议安装html5lib 模块。若使用Anaconda,安装命令为:conda install htm15lib

5.4.1 写入数据到HTML文件

下面介绍把DataFrame转换为HTML表格的方法。DataFrame的内部结构被自动转换为嵌入在表格中的

因为DataFrame等数据结构可能很复杂,规模很大,所以对需要开发网页的人来说,往HTML 文件写入数据的函数用处很大。

为了更好地理解它的功能,下面举例说明。先定义一个简单的DataFrame对象。

to_html()函数可以直接把DataFrame转换为HTML表格。

frame = pd.DataFrame(np.arange(4).reshape(2,2))

I/O API函数是在pandas数据结构内部定义的,因此可以直接在DataFrame 实例上调用to_html()函数。

print(frame.to_html()

| 0 | 1 | |

|---|---|---|

| 0 | 0 | 1 |

| 1 | 2 | 3 |

如上所示,该函数按照 DataFrame的内部结构,正确生成了创建 HTML表格所需的 HTML 标签。

下面的例子演示如何在HTML文件中自动生成表格。我们将创建一个比上面更加复杂、具有索引和列名称的DataFrame对象。

1 | >>>frame =pd.DataFrame(np.random.random((4,4)), |

| up | down | right | left | |

|---|---|---|---|---|

| white | 0.292434 | 0.457176 | 0.905139 | 0.737622 |

| black | 0.794233 | 0.949371 | 0.540191 | 0.367835 |

| red | 0.204529 | 0.981573 | 0.118329 | 0.761552 |

| blue | 0.628790 | 0.585922 | 0.039153 | 0.461598 |

考虑一下如何生成一个字符串并把它写入到HTML页面。这个例子虽然短小,但是可以直接在Web浏览器中理解和测试pandas的功能。

首先创建一个包含HTML页面代码的字符串:

1 | >>>s=['<HTML>'] |

既然HTML页面的所有内容都存储在变量html中,可以直接把它写入到myFrame.html文件中:

1 | >>html_file=open('myFrame.html','w') |

工作目录中多了myFrame.html文件。双击直接用浏览器打开它,将会看到HTML表格显示在网页的左上方,如图5-1所示。

图5-1 DataFrame转换为网页的HTML表格

5.4.2 从HTML文件读取数据

如上所示,pandas可以直接用DataFrame生成HTML表格。逆操作也很简单,read_html()函数解析 HTML 页面,寻找HTML表格。如果找到,就将其转换为可以直接用于数据分析的DataFrame对象。

具体而言,即使只有一个表格,read_html()函数也会返回一个DataFrame列表。可解析的数据源类型多样。例如读取任意目录中的HTML文件,比如解析上个例子中创建的HTML文件。

1 | >>>web_frames=pd.read_html('myFrame.html') |

| Unnamed: O | up | down | right | left | |

|---|---|---|---|---|---|

| 0 | white | 0.292434 | 0.457176 | 0.905139 | 0.737622 |

| 1 | black | 0.794233 | 0.949371 | 0.540191 | 0.367835 |

| 2 | red | 0.204529 | 0.981573 | 0.118329 | 0.761552 |

| 3 | blue | 0.628790 | 0.585922 | 0.039153 | 0.461598 |

如上所示,所有跟HTML表格无关的标签都没有考虑在内。具体而言,web_frames是一个元素为DataFrame的列表,虽然这个例子中只抽取了一个表格。要从列表中选择想使用的DataFrame,可用传统的索引方法。由于这里只有一个元素,因此索引为0。

然而,read_html()函数最常用的模式是以网址作为参数,直接解析并抽取网页中的表格。

举个例子,下面的网址所指向页面的HTML表格为一排行榜,包含用户名字和得分两项。可以直接以这个地址为参数进行处理。

1 | >>>ranking =pd.read_html('https://www.meccanismocompless0.org/en/ |

| Member | points | levels | Unnamed:3 | |

|---|---|---|---|---|

| O | 1 | BrunoOrsini | 1075 | NaN |

| 1 | 2 | Berserker | 700 | NaN |

| 2 | 3 | albertosallu | 275 | NaN |

| 3 | 4 | Mr.Y | 180 | NaN |

| 4 | 5 | Jon | 170 | NaN |

| 5 | 6 | michele sisi | 120 | NaN |

| 6 | 7 | STEFANO GUST | 120 | NaN |

| 7 | 8 | Davide Alois | 105 | NaN |

| 8 | 9 | Cecilia Lala | 105 | NaN |

上述操作适用于解析任意一个包含一个或多个表格的网页。

5.5 从XML读取数据

pandas的所有I/OAPI函数中,没有专门用来处理XML(可扩展标记语言)格式的。虽然没有,但这种格式其实很重要,因为很多结构化数据都是以XML格式存储的。pandas没有专门的处理函数也没关系,因为Python有很多读写XML格式数据的库(除了pandas)。

其中一个库叫作lxml,它在大文件处理方面性能优异,因而从众多同类库之中脱颖而出。本节将介绍如何用它处理XML文件,以及如何把它和pandas整合起来,以最终从XML文件中获取所需数据并将其转换为DataFrame 对象。要想获得关于这个库的更多信息,建议访问lxml的官方网站。

以代码清单5-11的XML文件为例。新建books.xml文件,写入下述代码,并将其保存到工作目录下。

代码清单5-11 books.xml

1 |

|

在这个例子中,你需要直接把XML中的数据结构转换为DataFrame对象。要完成该操作,首先要用到lxml库的二级模块objectify,导入方法如下:

from lxml import objectify

这样就可以用parse()函数解析XML文件了。

xml=objectify.parse(‘books.xml’)

xml

<lxml.etree._ElementTree object at 0x0000000009734E08>

上述代码得到一棵对象树,它是lxml模块的一种内部数据结构。

下面详细介绍这类对象。要想在树结构中拣选元素,必须先定义根节点。可以用getroot()函数获取根节点。

root=xml.getroot()

既然定义了根结构,就可以获取树结构的各个节点了,每个节点与原始的XML文件中的标签相对应。节点的名称跟标签名称相同。因此,要选择节点,只需依次指定几个标签。注意各标签之间用点号分隔,标签的次序反映的正是树中节点的层级顺序。

root.Book.Author

‘Ross,Mark’

root.Book.PublishDate

‘2014-22-01’

这样就可以获取单个节点了。若要同时获取多个元素,可以使用getchildren()函数,它能获取某个元素的所有子节点。

root.getchildren()

[<Element Book at 0x9c66688>, <Element Book at 0x9c66e08>]

再用tag属性,就能得到子节点tag属性的名称了。

[child.tag fo child in root.Book.getchildren()]

[‘Author’, ‘Title’, ‘Genre’, ‘Price’, ‘PublishDate’]

可用text属性获取位于标签之间的内容。

[child.text for child in root.Book.getchildren()]

[‘Ross, Mark’, ‘XML Cookbook’, ‘Computr’,’23.56’,’2014-22-01’]

lxml.etree树结构是可遍历的,接下来要把树结构转换为DataFrame对象。定义以下函数,分析eTree的所有内容,逐行填充DataFrame对象。

def etree2df(root):

··· column_names=[]-

··· for i in range(o,len(root.getchildren()[0].getchildren()

… column_names.append(root.getchildren()[o].getchildren()

xml:frame = pd.DataFrame(columns=column_names)

for j in range(0, len(root.getchildren()

obj =root.getchildren()[j].getchildren()

texts=[

for k in range(0, len(column_names)):

texts.append(obj[k].text)

row=dict(zip(column_names,texts))

row_s=pd.Series(row)

rows.name=j

xml:frame = xml:frame.append(row_s)

return xml:frame

.·.

etree2df(root)

Author Title Genre Price PublishDate

0 Ross,Mark XML Cookbook Computer 23.56 2014-22-01

1 Bracket,Barbara XML for Dummies Computer 35.95 2014-12-16

5.6 读写Microsoft Excel 文件

由上节可知,从CSV文件读取数据的操作很简单。除了CSV文件,用Excel工作表存放列表形式的数据也很常见。

pandas专门定义了几个函数来处理这种格式。前面给出的I/O API函数中,有两个是专门用于Excel文件的:

口$t _ { 0 } \exp _ { - } \exp ( )$

readexcel()

read_excel() Excel 2007(xlgx)两类文件。该函数之所以能够读取Excel,是因为它整合了xlrd模块。

首先,打开一个Excel文件,在sheetl 和 sheet2中输入图5-2中的数据。然后将其保存为ch05_data.xlsx。

图5-2 Excel文件 sheetl和sheet2中的两组数据

要读取XLSX文件中的数据,并将其转换为DataFrame对象,只需要使用$r e a d \underline { e } \times c e l ( )$函数。

pd.read_excel(‘ch05_data.xlsx’)

| white | red | green | black | |

|---|---|---|---|---|

| a | 12 | 23 | 17 | 18 |

| b | 22 | 16 | 19 | 18 |

| C | 14 | 23 | 22 | 21 |

如上所示,读取Excel时,默认返回的DataFrame对象包含第1个工作表中的数据。若要读取第2个工作表中的数据,需要用第2个参数指定工作表的名称或工作表的序号(索引)。

pd.read_excel(‘chos_data.xlsx’,’Sheet2’)

| yellow | purple | blue | orange | |

|---|---|---|---|---|

| A | 11 | 16 | 44 | 22 |

| B | 20 | 22 | 23 | 44 |

| C | 30 | 31 | 37 | 32 |

pd.read_excel(‘ch05_data.xlsx’,1)

| yellow | purple | blue | orange | |

|---|---|---|---|---|

| A | 11 | 16 | 44 | 22 |

| B | 20 | 22 | 23 | 44 |

| C | 30 | 31 | 37 | 32 |

上述操作也适用于Excel写操作。因此要将DataFrame对象转换为Excel工作表,代码如下:

frame = pd.DataFrame(np.random.random((4,4)),

··· $\in d x [ ^ { t } \exp 1 ^ { t } , ^ { \prime } \exp 2 ^ { \prime } , ^ { \prime } \exp 3 ^ { \prime } , ^ { \prime } \exp 4 ^ { \prime } ] $

… columns = [‘Jan2015’, ‘Fab2015’,’Mar2015’, ‘Apr2005’])

frame

| Jan2015 | Fab2015 | Mar2015 | Apr2005 | |

|---|---|---|---|---|

| exp1 | 0.030083 | 0.065339 | 0.960494 | 0.510847 |

| exp2 | 0.531885 | 0.706945 | 0.964943 | 0.085642 |

| exp3 | 0.981325 | 0.868894 | 0.947871 | 0.387600 |

| exp4 | 0.832527 | 0.357885 | 0.538138 | 0.357990 |

frame.to_excel(‘data2.xlsx’)

工作目录中会生成一个包含数据的新 Excel文件,如图5-3所示。

图5-3 Excel文件中的DataFrame数据

5.7 JSON数据

JSON(JavaScript Object Notation,JavaScript 对象标记)已成为最常用的标准数据格式之一,特别是在Web数据的传输方面。因此,如果使用Web数据,通常要处理这类数据格式。

这种格式很灵活,尽管数据结构跟常见的列表形式差别很大。

本节将介绍I/OAPI函数中的read_json本节将介绍I/OAPI函数中的read_json()和to_json() ()函数的用法。其中一个例子处理JSON 格式的结构化数据,这跟真实应用场景更为接近。

用于检测JSON格式是否正确的一个很好用的在线应用是JSONViewer。输入或复制 JSON 数据到这个Web应用中,就可以检测其格式是否合法。它还能以树状结构显示数据,易于理解(如图5-4所示)。

图5-4 JSONViewer

下面考虑更实际的使用场景:将一个DataFrame转换为JSON文件。首先定义一个DataFrame 对象,然后调用它的to_json()函数,传入要创建的文件名作为参数。

frame=pd.DataFrame(np.arange(16)..reshape(4,4)

$\in d e x = [ ^ { \pi } \cdot \sin i t e ^ { \pi } , “ b l a c k ^ { \prime } , ^ { \prime } r e d ^ { \prime } , “ b l u e ^ { \prime } ] $

… $c o l u m n s = [ ^ { * } u p ^ { * } , ^ { * } d o u m ^ { * } , ^ { * } x i g h t ^ { * } , ^ { * } l e f t ^ { * } ] )$

frame.tojson(‘frame.json’)

工作目录中新增一个JSON文件(见代码清单5-12),它包含JSON格式的DataFrame数据。

代码清单5-12 frame.json

${ ^ { \prime \prime } \cup P ^ { \prime \prime } : { P ^ { \prime \prime } M h i t e ^ { \prime \prime } : 0 , ^ { \prime \prime } b l a c k ^ { \prime \prime } : 4 , ^ { \prime \prime } x e d ^ { - 1 n } : 8 , “ b l u e ^ { \prime \prime } : 1 2 }$ “down”$: { “ M h i t e “ : 1 , “ b l a c k ^ { m } : 5 , “ I e d ^ { m } : 9 , “ b l u e ^ { n } : 1 3 }$

$( r _ { 1 } ) _ { B } e ^ { r } : ( r [ \cdot ] } \ln i e ^ { - 2 } , s _ { D } ) , b i d e ^ { r \theta } : 1 0 , v l u e ^ { - i 4 } ; ( m h i e ^ { - 2 } ; “ ( m h i e ^ { - 2 } , 6 ) 2 d e ^ { r ^ { r } }$

写入操作的逆操作-读取JSON文件也很简单,用read_json()函数,传入文件名作为参数即可。

pd.read_json(‘frame.json’)

| down | left | right | up | |

|---|---|---|---|---|

| black | 5 | 7 | 6 | 4 |

| blue | 13 | 15 | 14 | 12 |

| red | 9 | 11 | 10 | 8 |

| white | 1 | 3 | 2 | 0 |

上述例子相当简单,其中的JSON数据为列表形式(因为frame.json文件是由DataFrame对象转换而来的)。然而,JSON文件中的数据通常不是列表形式。因此需要将字典结构的文件转换为列表形式。这个过程称为规范化(normalization)。

pandas库的json_normalize()函数能将字典或列表转换为表格。使用前,首先需要导入这个函数:

from pandas.i0.json import json_normalize

然后,用任意文本编辑器编写如代码清单5-13所示的JSON文件,将其保存到工作目录下,文件名为books.json。

代码清单5-13 books.json